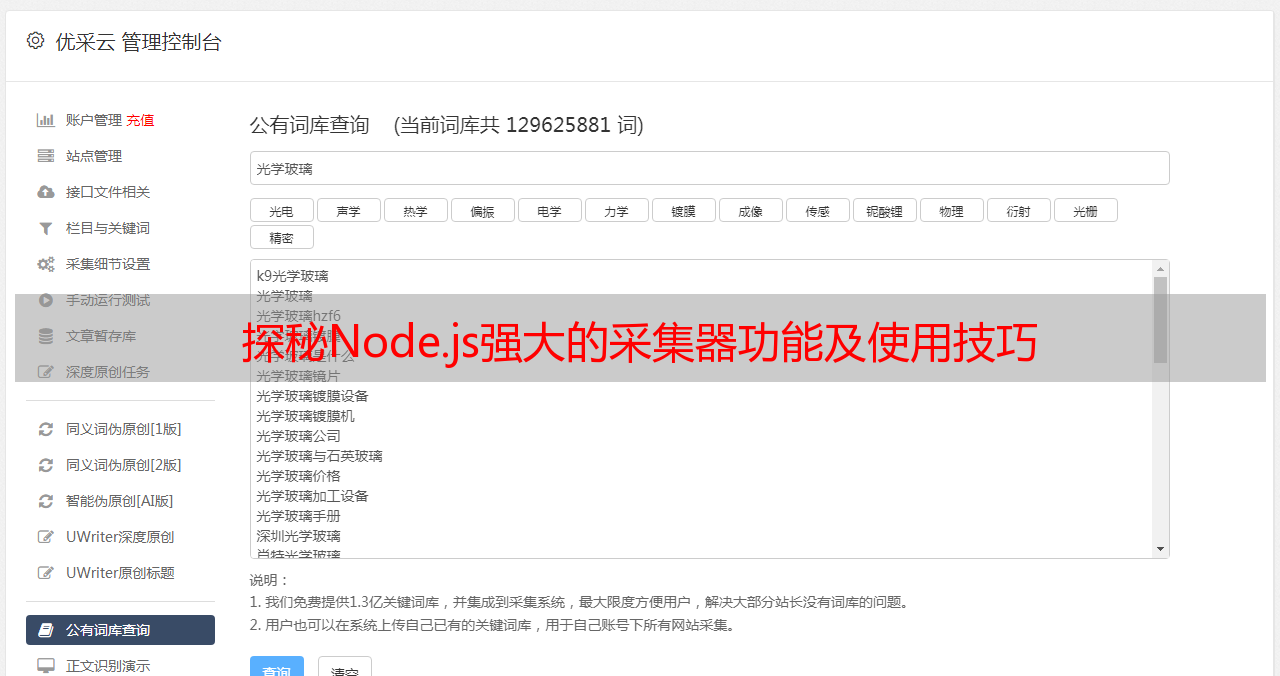

探秘Node.js强大的采集器功能及使用技巧

优采云 发布时间: 2023-04-30 03:54Node.js是一种基于Chrome V8引擎构建的JavaScript运行环境,可以用于构建高效、可伸缩的网络应用。而Node.js提供的强大的网络和文件I/O库,也让它成为了一个非常适合编写爬虫程序的平台。

在众多的Node.js爬虫工具中,有一款特别受欢迎——“node 强大的采集器”。今天我们就来揭秘这个爬虫神器,在9个方面逐步分析它的强大功能和使用方法。

1.网络请求模块

“node 强大的采集器”内置了强大的网络请求模块,支持HTTP/HTTPS/FTP等协议,并且可以设置代理、cookie等信息。我们可以使用以下代码来发起一个GET请求:

const Crawler = require('crawler');

const c = new Crawler();

c.queue({

uri:'https://www.ucaiyun.com',

callback: function(error, res, done){

if(error){

console.log(error);

} else {

console.log(res.body);

}

done();

}

});

在这段代码中,我们首先引入了“node 强大的采集器”的核心模块Crawler,并创建了一个Crawler实例c。接着我们调用了c.queue()方法,传入一个uri参数和一个callback回调函数。在回调函数中,我们可以处理请求的结果。

2.页面解析模块

“node 强大的采集器”内置了多种页面解析模块,包括HTML解析、XML解析、JSON解析等。我们可以使用以下代码来解析一个HTML页面:

const Crawler = require('crawler');

const c = new Crawler();

c.queue({

uri:'https://www.ucaiyun.com',

callback: function(error, res, done){

if(error){

console.log(error);

} else {

const $= res.$;

console.log($('title').text());

}

done();

}

});

在这段代码中,我们使用了cheerio模块来解析HTML页面,并使用了$res对象来获取cheerio实例$。接着我们可以使用$()方法来选择元素,并使用text()方法来获取元素文本。

3.并发控制模块

“node 强大的采集器”支持并发控制,可以同时发起多个请求,并且可以设置最大并发数。我们可以使用以下代码来设置最大并发数为10:

const Crawler = require('crawler');

const c = new Crawler({

maxConnections: 10

});

在这段代码中,我们创建了一个Crawler实例c,并设置了maxConnections参数为10。

4.数据存储模块

“node 强大的采集器”内置了多种数据存储模块,包括文件存储、数据库存储等。我们可以使用以下代码将数据存储到MongoDB数据库中:

const Crawler = require('crawler');

const mongoose = require('mongoose');

mongoose.connect('mongodb://localhost/test');

const Book = mongoose.model('Book',{

title: String,

author: String

});

const c = new Crawler();

c.queue({

uri:'https://www.ucaiyun.com',

callback: function(error, res, done){

if(error){

console.log(error);

} else {

const book = new Book({

title:$('title').text(),

author:$('meta[name="author"]').attr('content')

});

book.save();

}

done();

}

});

在这段代码中,我们首先使用mongoose模块连接到本地的MongoDB数据库,并定义了一个Book模型。接着我们在回调函数中创建了一个Book实例,并调用save()方法将数据保存到数据库中。

5.队列管理模块

“node 强大的采集器”内置了队列管理模块,可以管理请求的顺序和优先级。我们可以使用以下代码来设置请求的优先级:

const Crawler = require('crawler');

const c = new Crawler();

c.queue([

{

uri:'https://www.ucaiyun.com',

priority: 1

},

{

uri:'https://www.ucaiyun.com/about',

priority: 2

},

{

uri:'https://www.ucaiyun.com/contact',

priority: 3

}

]);

在这段代码中,我们使用了一个数组来传入多个请求,并且为每个请求设置了不同的优先级。

6.超时控制模块

“node 强大的采集器”内置了超时控制模块,可以设置请求的超时时间并且可以处理超时错误。我们可以使用以下代码来设置请求的超时时间为5秒:

const Crawler = require('crawler');

const c = new Crawler({

timeout: 5000

});

在这段代码中,我们创建了一个Crawler实例c,并设置了timeout参数为5000毫秒。

7.重试控制模块

“node 强大的采集器”内置了重试控制模块,可以处理网络错误和其他异常情况。我们可以使用以下代码来设置最大重试次数为3次:

const Crawler = require('crawler');

const c = new Crawler({

retries: 3

});

在这段代码中,我们创建了一个Crawler实例c,并设置了retries参数为3次。

8.日志记录模块

“node 强大的采集器”内置了日志记录模块,可以记录请求的详细信息和错误信息。我们可以使用以下代码来启用日志记录:

const Crawler = require('crawler');

const c = new Crawler({

logger: console.log,

logLevel:'debug'

});

在这段代码中,我们创建了一个Crawler实例c,并设置了logger参数为console.log方法,logLevel参数为debug级别。

9.分布式爬虫模块

“node 强大的采集器”支持分布式爬虫,可以将任务分配给多个节点进行处理。我们可以使用以下代码来启用分布式爬虫:

const Crawler = require('crawler');

const c = new Crawler({

distributed: true

});

在这段代码中,我们创建了一个Crawler实例c,并设置了distributed参数为true。

总结

“node 强大的采集器”是一款非常强大的Node.js爬虫工具,它内置了多种功能模块,包括网络请求、页面解析、并发控制、数据存储、队列管理、超时控制、重试控制、日志记录和分布式爬虫等。使用“node 强大的采集器”,我们可以轻松编写高效、可靠的爬虫程序,从而实现各种数据采集和分析任务。

如果你想让你的网站拥有更好的SEO效果,那么你需要使用优采云提供的SEO优化服务。优采云是一家专业的SEO优化公司,提供全方位的SEO优化服务,包括网站诊断、关键词排名、内容创作等。欢迎访问www.ucaiyun.com了解更多信息。