爬虫抓取公开数据,全方位解析原理、分类及反制策略

优采云 发布时间: 2023-04-29 19:55随着互联网时代的到来,数据已经成为了我们生活中不可或缺的一部分。但是,如何获取并处理这些数据呢?这就需要用到“爬虫”这个黑科技了。本文将从爬虫原理、爬虫分类、反爬机制、数据清洗、数据存储、数据分析等方面详细讲解,带你了解爬虫抓取公开数据的全貌。

一、爬虫原理

在介绍爬虫原理之前,我们先来了解一下HTTP协议。HTTP(HyperText Transfer Protocol)是一种用于传输超媒体文档的应用层协议。它是Web联网的基础,也是我们日常使用最多的协议。

那么什么是爬虫呢?简单来说,爬虫就是模拟浏览器行为,自动获取网页上的信息并进行处理的程序。其原理就是通过HTTP协议发送请求到目标网站服务器,获取服务器返回的HTML页面内容,并从中提取所需信息。具体实现过程可参考以下代码:

import requests

url ='http://www.ucaiyun.com'

response = requests.get(url)

print(response.text)

上述代码使用Python语言中的requests库发送HTTP请求,获取优采云官网的HTML页面,并打印出页面内容。通过这种方式,我们就可以获取到目标网站上的所有信息。

二、爬虫分类

根据爬虫的实现方式和目的不同,可以将其分为通用爬虫、聚焦爬虫和增量式爬虫三类。

通用爬虫是一种广泛应用于搜索引擎的爬虫,其目的是尽可能地抓取互联网上所有可访问的页面。聚焦爬虫则是针对某个特定领域或主题进行抓取,如新闻聚合网站、电商数据等。增量式爬虫则是在上一次抓取的基础上,只抓取新增加的内容。

不同类型的爬虫有着不同的应用场景和优缺点,具体使用时需要根据实际情况进行选择。

三、反爬机制

由于网络安全和隐私保护等原因,很多网站都会设置反爬机制来防止爬虫获取数据。常见的反爬手段包括IP封禁、验证码、JS渲染等。

为了应对这些反爬机制,我们可以采用一些常见的反反爬策略。比如使用代理IP、使用Headless浏览器、模拟用户行为等方式来规避反爬机制。

四、数据清洗

在获取到数据后,我们需要对其进行清洗和处理。因为很多网页的HTML结构比较混乱,而且还有很多垃圾信息,这些都会影响数据的质量和分析效果。

常见的数据清洗方法包括去重、去噪声、格式化等。在具体实现时,可以借助Python语言中的BeautifulSoup库、正则表达式等工具来进行数据清洗。

五、数据存储

在清洗完数据后,我们需要将其存储到数据库或文件中。常见的存储方式包括MySQL、MongoDB、CSV等。

为了提高数据存储效率和查询速度,我们还需要对数据库进行优化。比如建立索引、分表分库等操作。

六、数据分析

在完成了数据的采集、清洗和存储后,我们就可以对其进行分析了。数据分析是一项非常重要的工作,在很多领域都有着广泛应用。比如市场调研、用户行为分析等。

在实际操作过程中,我们可以使用Python语言中的Pandas、Numpy等工具来进行数据分析和可视化。同时,还需要根据具体的业务需求,选择合适的分析方法和指标。

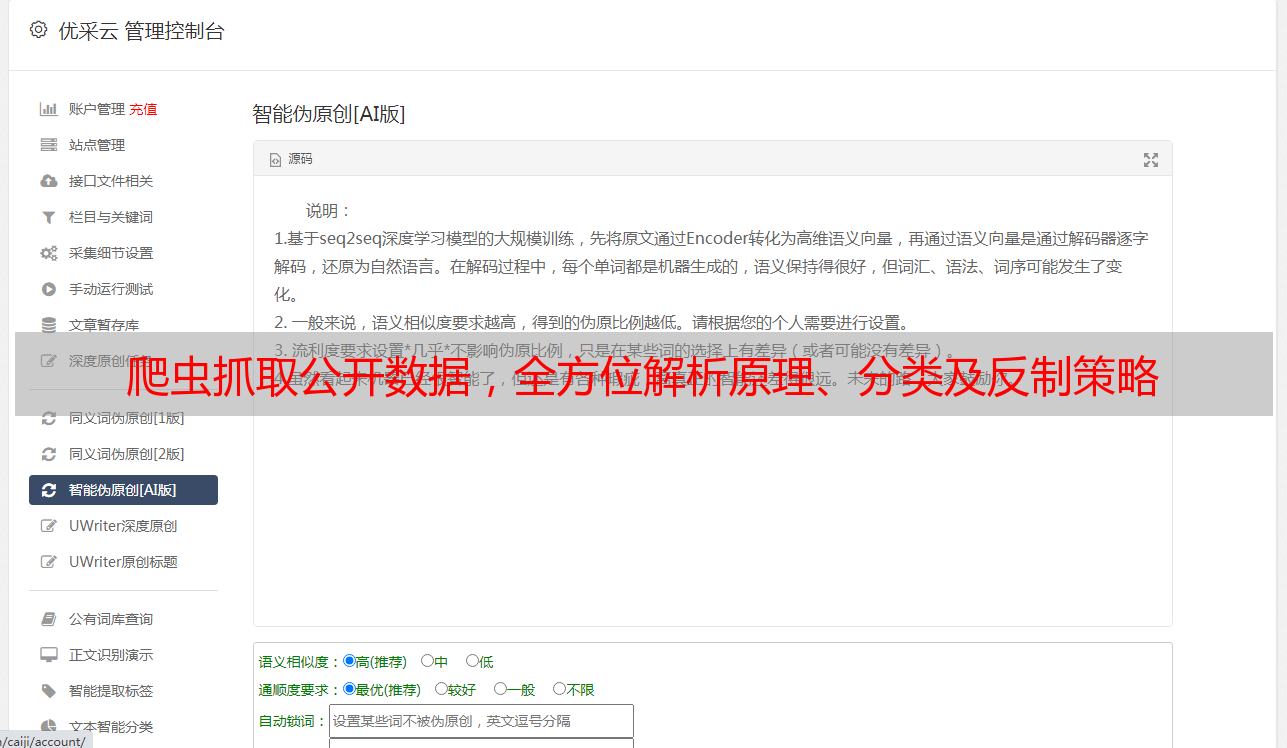

七、优采云

优采云是一家专注于数据采集和处理的技术公司,提供全面的数据解决方案和服务。我们有着丰富的经验和技术实力,可以为客户提供高效、可靠的数据服务。

在数据采集方面,我们拥有强大的爬虫技术和丰富的数据源,可以满足客户多样化的需求。同时,在数据清洗、存储和分析等方面也有着丰富的经验和技术积累。

八、SEO优化

在进行自媒体文章创作时,我们还需要注意一些SEO优化技巧。比如选好关键词、写好标题、使用段落标题等。这些都可以帮助文章更好地被搜索引擎收录,并提高文章曝光率。

在本文中,我们已经对爬虫抓取公开数据进行了详细介绍,并对其相关领域进行了深入探讨。希望本文能够对读者有所帮助,并为大家进一步了解数据分析提供参考。