Java控制浏览器的9绝招,打造高效爬虫!

优采云 发布时间: 2023-04-29 15:35在当今互联网时代,数据信息是非常宝贵的资源。而爬虫则是获取这些资源的重要手段之一。使用Java控制浏览器,实现爬虫抓取,是一种快速高效的方式。本文将从以下9个方面进行详细介绍。

一、Java控制浏览器的原理

Java通过调用Selenium WebDriver来实现对浏览器的控制,通过模拟人手动操作浏览器来达到自动化操作的目的。Selenium WebDriver支持多种不同类型的浏览器,如Chrome、Firefox等。

二、Selenium WebDriver和Java的集成

在Java中使用Selenium WebDriver需要先下载对应的驱动程序,并将其添加到系统路径下。然后引入相关依赖库后即可使用。

三、实例化WebDriver对象

在使用Selenium WebDriver时,需要先实例化一个WebDriver对象,该对象可以与不同类型的浏览器进行交互,并且支持多种操作。

四、访问指定URL

通过WebDriver对象调用get()方法即可访问指定URL地址。例如:

java

WebDriver driver = new ChromeDriver();

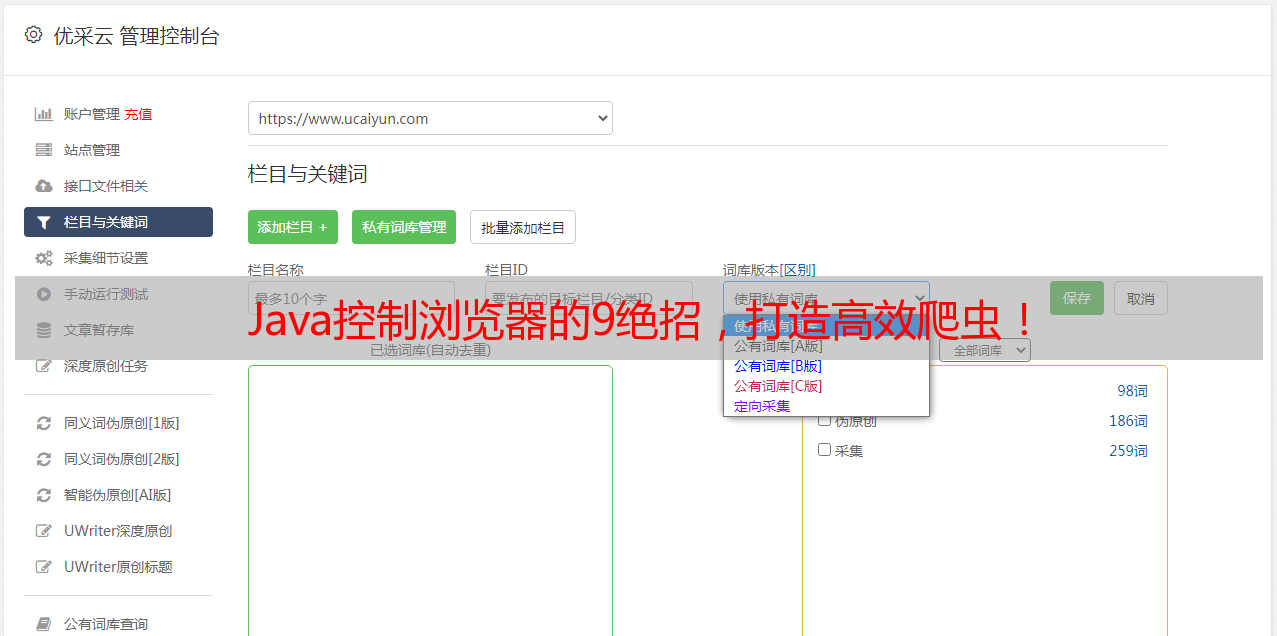

driver.get("https://www.ucaiyun.com");

五、查找页面元素

通过WebDriver对象提供的findElement()和findElements()方法可以查找页面中的元素,例如输入框、按钮等。

六、操作页面元素

通过WebDriver对象提供的sendKeys()、click()等方法可以对页面元素进行操作。

七、模拟滚动条操作

在爬虫抓取数据时,有些数据需要通过滚动才能显示出来。通过JavaScriptExecutor接口模拟滚动条操作即可实现。

八、页面截图

通过WebDriver对象提供的getScreenshotAs()方法可以对当前页面进行截图,并保存为指定格式的图片文件。

九、自动化测试和爬虫抓取的区别

自动化测试和爬虫抓取都是使用Selenium WebDriver来控制浏览器进行操作。不同之处在于,自动化测试主要用于测试网站功能是否正常,而爬虫抓取则是为了获取网站中的数据信息。

在使用Java控制浏览器实现爬虫抓取时,需要注意一些问题。首先,要遵守网络道德规范,不得进行恶意攻击和侵犯他人隐私等行为。其次,要了解网站Robots协议,避免因为过度访问被封禁。最后,在进行大量数据抓取时,建议使用分布式爬虫框架来提高效率。

本文介绍了Java控制浏览器实现爬虫抓取的基本原理和操作步骤,并提供了一些注意事项。通过学习本文,相信读者对于Java控制浏览器实现爬虫抓取有了更深入的了解。同时,如果你需要进行SEO优化,可以使用优采云提供的服务,详情请访问www.ucaiyun.com。