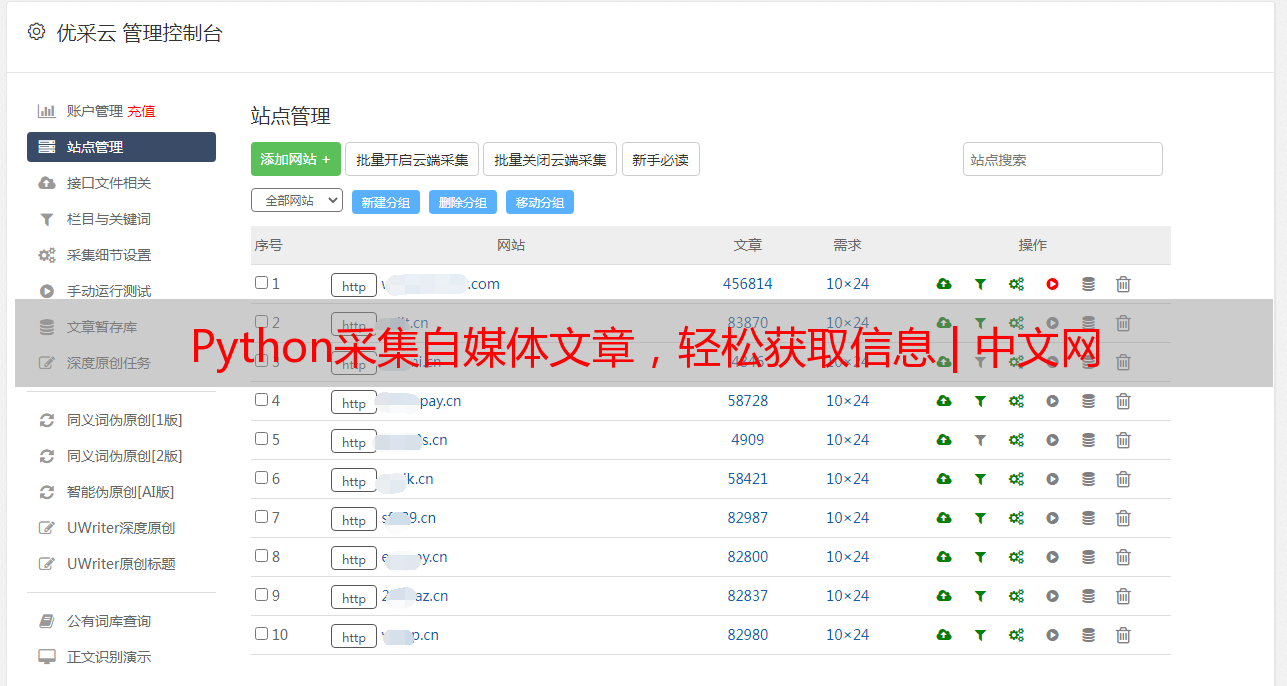

Python采集自媒体文章,轻松获取信息 | 中文网

优采云 发布时间: 2023-04-29 04:59Python 作为一种高级编程语言,不仅可以用于软件开发、数据分析等领域,还可以用于自媒体内容采集。在当今信息爆炸的时代,如何快速获取有价值的信息并加以利用,对于自媒体的发展至关重要。本文将从以下 10 个方面详细讲解如何使用 Python 进行文章采集。

1.网页请求

Python 中有多种库可以用来发送 HTTP 请求,比如 urllib、requests 等。其中 requests 库是最常用的一个。通过 requests.get()函数可以发送 GET 请求,得到网页的 HTML 代码。

python

import requests

url ='https://www.ucaiyun.com/'

response = requests.get(url)

html = response.text

2.解析 HTML

获取到网页 HTML 后,我们需要对其进行解析和提取。Python 中最常用的解析库是 BeautifulSoup。BeautifulSoup 提供了一些方法来遍历 HTML 文档树,并且可以根据标签、属性等信息来查找节点。

python

from bs4 import BeautifulSoup

soup = BeautifulSoup(html,'html.parser')

title = soup.find('title').text

3.正则表达式

除了 BeautifulSoup 外,还可以使用正则表达式对 HTML 进行解析。正则表达式是一种字符串匹配的工具,可以用来查找、替换、分割字符串等。

python

import re

pattern ='<title>(.*?)</title>'

title = re.findall(pattern, html)[0]

4. XPath

XPath 是一种在 XML 文档中查找信息的语言,也可以用于 HTML 文档的解析。Python 中最常用的 XPath 库是 lxml。

python

from lxml import etree

tree = etree.HTML(html)

title = tree.xpath('//title/text()')[0]

5. RSS 订阅

RSS(Really Simple Syndication)是一种用于发布经常更新数据的格式,比如博客文章、新闻等。Python 中有多个库可以用来解析 RSS 订阅,比如 feedparser、PyRSS2Gen 等。

python

import feedparser

url ='https://www.ucaiyun.com/feed'

feed = feedparser.parse(url)

for entry in feed.entries:

title = entry.title

6. API 调用

很多网站提供了 API 接口,可以通过调用接口获取数据。Python 中可以使用 requests 库来发送 API 请求,并且可以使用 json 库来解析 JSON 格式的响应数据。

python

import requests

import json

url ='https://api.example.com/articles'

params ={'category':'tech','limit': 10}

response = requests.get(url, params=params)

data =6b75574d3f962e34b1fac1addebc32f4.loads(response.text)

for article in data['articles']:

title = article['title']

7.数据存储

获取到文章数据后,需要将其存储到本地或者服务器上。Python 中可以使用多种方式来存储数据,比如文本文件、CSV 文件、数据库等。

python

import csv

with open('articles.csv','w', newline='', encoding='utf-8') as f:

writer = csv.writer(f)

writer.writerow(['title','url'])

for article in articles:

writer.writerow([article['title'], article['url']])

8.定时任务

有些文章需要定期采集,比如每天更新的新闻。Python 中可以使用 APScheduler 库来实现定时任务的调度。

python

from apscheduler.schedulers.blocking import BlockingScheduler

def job():

#采集文章

scheduler = BlockingScheduler()

scheduler.add_job(job,'interval', hours=24)

scheduler.start()

9.多线程

采集文章是一个耗时的过程,如果只使用单线程会很慢。Python 中可以使用 threading 或者 concurrent.futures 库来实现多线程采集。

python

import threading

def job():

#采集文章

threads =[]

for i in range(10):

t = threading.Thread(target=job)

threads.append(t)

for t in threads:

t.start()

for t in threads:

t.join()

10.反爬虫

有些网站会对爬虫进行限制,比如设置验证码、封禁 IP 等。为了避免被反爬虫机制识别,我们可以在爬虫中加入一些策略,比如设置 User-Agent、使用代理 IP 等。

以上就是使用 Python 进行文章采集的 10 个方面的详细讲解。通过掌握这些技术,我们可以快速高效地获取有价值的文章信息,从而打造出更加优秀的自媒体内容。如果您需要更加专业的文章采集服务和 SEO 优化支持,请联系优采云(www.ucaiyun.com)。