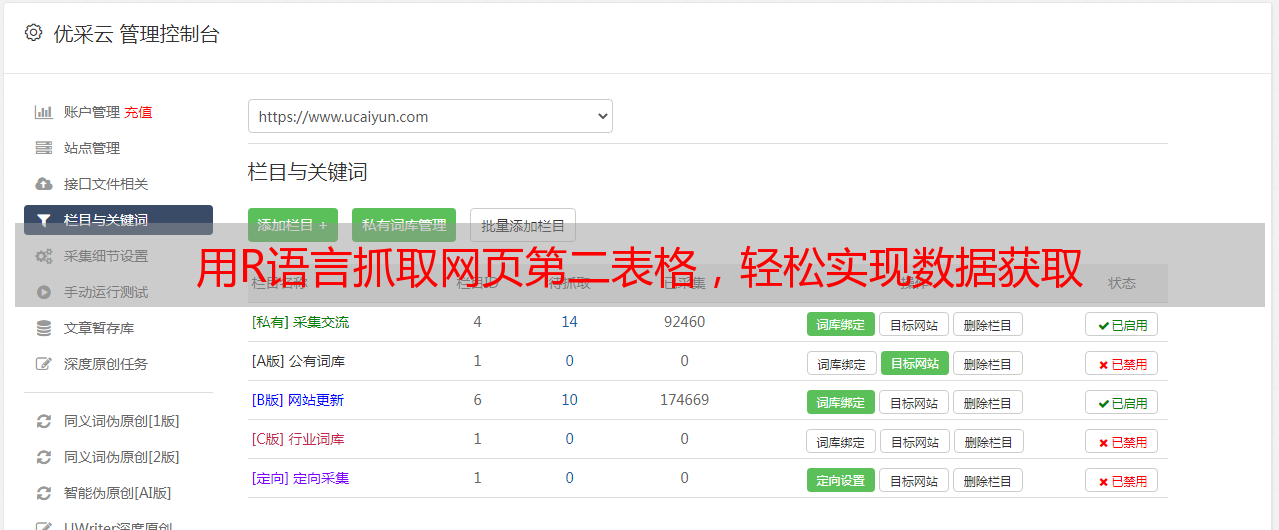

用R语言抓取网页第二表格,轻松实现数据获取

优采云 发布时间: 2023-04-28 19:31如果你经常需要从网站上获取数据,那么你一定知道这是一项非常费时费力的工作。特别是当你需要抓取多个页面上的数据时,手动复制粘贴可能会让你崩溃。但是,如果你会使用R语言,那么你可以轻松地解决这个问题。

在本文中,我们将介绍如何使用R语言抓取网页的第二个表格,并将其保存到一个数据框中。我们将分为以下10个方面进行逐步分析讨论:

1.安装必要的软件包

在使用R语言进行网页抓取之前,需要安装两个必要的软件包:rvest和xml2。可以使用以下命令来安装它们:

r

install.packages("rvest")

install.packages("xml2")

2.导入必要的库

在开始编写代码之前,请确保已经加载了所需的库。可以使用以下命令来导入它们:

r

library(rvest)

library(xml2)

3.指定要抓取的网页

在这个例子中,我们将从一个名为“example.com”的虚拟网站中抓取数据。可以使用以下代码指定要抓取的URL:

r

url <-"http://www.example.com"

4.发送HTTP请求并获取响应

使用以下代码发送HTTP请求并获取响应:

r

response <- read_html(url)

5.定位表格

在这个例子中,我们将使用以下代码来定位第二个表格:

r

table2 <- response %>% html_nodes("table")[2]%>% html_table(fill = TRUE)

6.将表格转换为数据框

使用以下代码将表格转换为数据框:

r

df <- as.data.frame(table2)

7.清理数据框

在有些情况下,抓取的数据可能需要进行清理和转换。可以使用以下代码来清理数据框:

r

df$column1 <- as.numeric(gsub(",","", df$column1))

df$column2 <- as.Date(df$column2,"%m/%d/%Y")

8.保存数据框

使用以下代码将数据框保存到本地文件:

r

write.csv(df,"data.csv", row.names = FALSE)

9.自动化抓取过程

如果你需要抓取多个页面上的相同类型的数据,那么手动执行上述步骤可能会非常耗时。幸运的是,可以使用循环自动化整个过程。以下是一个简单的示例代码:

r

#定义要抓取的URL列表

urls <-c("http://www.example.com/page1","http://www.example.com/page2","http://www.example.com/page3")

#循环抓取每个页面上的数据

for (i in 1:length(urls)){

url <- urls[i]

response <- read_html(url)

table2 <- response %>% html_nodes("table")[2]%>% html_table(fill = TRUE)

df <- as.data.frame(table2)

write.csv(df, paste0("data_",i,".csv"), row.names = FALSE)

}

10.总结

在本文中,我们介绍了如何使用R语言轻松抓取网页的第二个表格。我们还讨论了如何自动化整个过程,以便在需要抓取多个页面上的相同类型的数据时更加高效。使用这些技术,您可以轻松地从网站上获取数据,并将其保存到本地文件中以供进一步分析。

优采云提供专业的SEO优化服务,帮助企业提升网站排名和流量。如果您需要SEO优化服务,请访问www.ucaiyun.com。