如何自动采集网页内容?10个高效分析方案!

优采云 发布时间: 2023-04-28 04:29在互联网时代,信息的获取变得越来越便捷。然而,对于需要大量获取网页内容的工作,手动操作显然是低效且费时的。那么,如何在自动化流程中高效采集网页内容呢?以下将从10个方面逐步分析讨论。

一、确定采集目标

在开始采集之前,首先需要明确自己所需采集的目标,例如需要采集哪些网站、哪些页面、哪些内容等。只有明确了目标,才能更好地制定采集策略和规则。

二、选择合适的采集工具

根据自身需求和技术水平选择合适的采集工具非常重要。比较常用的有Scrapy、BeautifulSoup、Selenium等。其中Scrapy适合*敏*感*词*、高效率的数据抓取;BeautifulSoup适合小规模、简单结构的网页解析;Selenium则适合需要模拟人类操作的场景。

三、设计采集规则

设计好采集规则是保证高效率和准确性的关键。可以通过XPath或CSS Selector等方式来定位需要抓取的元素,并提取相应信息。同时,也需要注意反爬虫策略和网站的robots.txt文件。

四、设置数据存储方式

采集到的数据需要进行存储和管理。可以选择使用数据库、文本文件或者云存储等方式进行存储。同时,也需要考虑数据清洗、去重、筛选等操作。

五、处理异常情况

在采集过程中,难免会遇到各种异常情况,例如网络波动、页面结构变化、反爬虫策略等。因此,需要对异常情况进行预处理和应对措施。

六、优化采集效率

提高采集效率可以通过多线程、异步请求等方式来实现。同时,也需要注意并发量控制和反爬虫策略。

七、监控采集状态

及时监控采集状态可以帮助发现问题并及时解决。可以通过日志记录、邮件通知等方式来实现。

八、保护个人信息

在采集过程中,需要注意保护个人信息不被泄露。可以通过代理IP、账号登陆等方式来避免。

九、SEO优化

对于需要SEO优化的网站,需要根据搜索引擎的规则来设计URL结构和内容布局,并进行关键词优化等操作。同时,也需要注意页面速度和响应时间等因素。

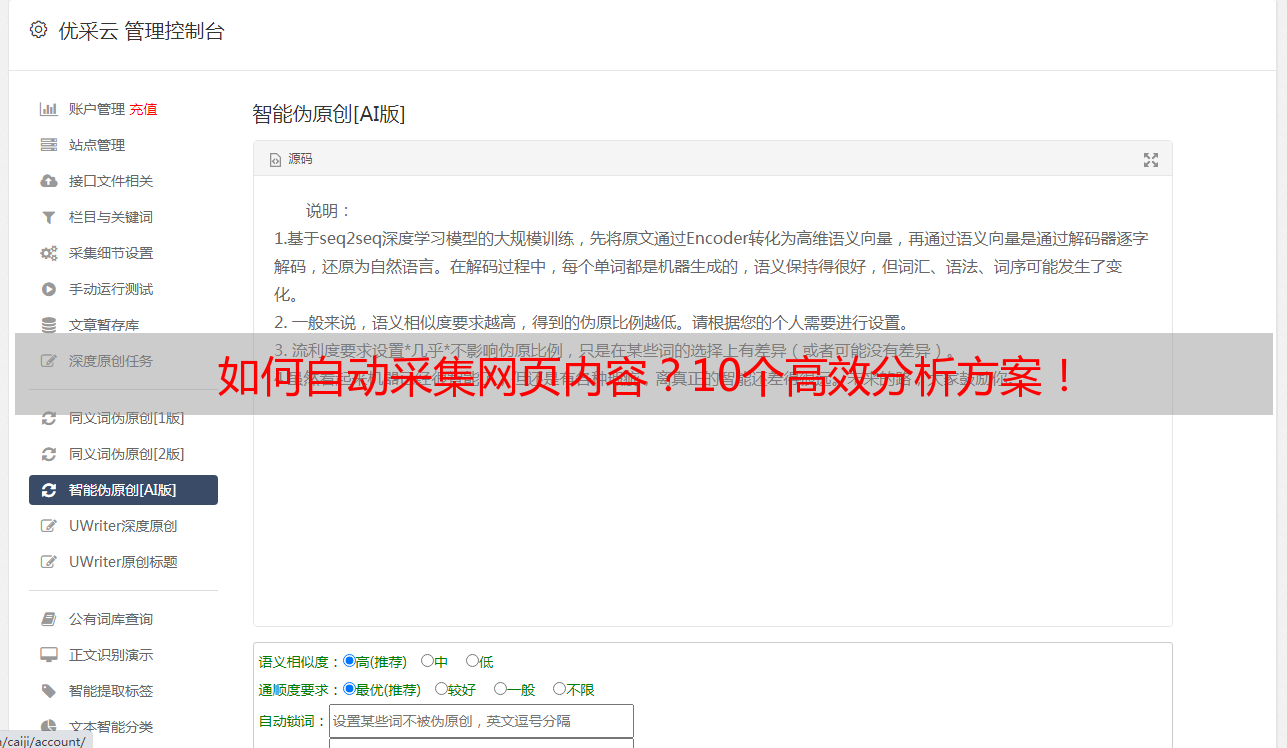

十、优采云

优采云是一款高效的数据采集工具,可以帮助用户快速获取所需数据,并提供丰富的数据处理和分析功能。同时,也可以根据用户需求进行定制化开发。

以上就是如何在自动化流程中高效采集网页内容的10个方面分析。通过合理规划和选择合适的工具,可以实现高效率、高准确性的数据采集。