Python轻松抓取微博内容,获取你想要的数据!

优采云 发布时间: 2023-04-26 14:30你是否曾经有过想要获取某个微博账号的全部内容的想法?或者,你是否曾经希望能够快速地获取某个话题下的所有微博内容,以便进行分析和研究?如果你的答案是肯定的,那么本文将会对你有所帮助。本文将会介绍如何使用Python来抓取微博内容,让你轻松地获取到你想要的数据。

一、准备工作

在开始之前,我们需要先安装一些必要的工具和库。首先,我们需要安装Python解释器。目前最新的版本是Python 3.10.0。其次,我们需要安装一个名为Selenium的库,它可以模拟浏览器行为,方便我们进行网页爬取操作。具体安装方法可以参考官方文档。

在安装完必要的工具后,我们还需要准备一些账号信息。由于微博需要登录才能查看内容,因此我们需要一个已注册并登录了微博账号的Cookie信息。获取Cookie信息可以参考本文后面提到的“获取Cookie方法”。

二、使用Selenium模拟登录

在准备好了必要的工具和账号信息之后,我们就可以开始编写代码了。首先,我们需要使用Selenium模拟登录微博。代码如下:

python

from selenium import webdriver

browser = webdriver.Firefox()

browser.get('https://weibo.com/login.php')

#输入账号和密码

username = browser.find_element_by_name('username')

password = browser.find_element_by_name('password')

username.send_keys('你的微博账号')

password.send_keys('你的微博密码')

#点击登录按钮

login_button = browser.find_element_by_xpath('//a[@class="W_btn_a btn_32px"]')

login_button.click()

在这段代码中,我们首先打开了Firefox浏览器,并访问了微博的登录页面。然后,我们找到了账号和密码的输入框,并输入了我们自己的账号和密码。最后,我们找到了登录按钮,并模拟点击操作。

三、获取Cookie方法

在完成了登录操作后,我们就可以获取Cookie信息了。获取Cookie信息的方法有很多种,这里介绍一种通过Firefox浏览器自带的开发者工具来获取Cookie信息的方法。

首先,在Firefox浏览器中按下F12键或者右键点击页面并选择“检查元素”打开开发者工具。然后,在开发者工具中切换到“Network”选项卡,并勾选“Preserve log”选项。

接着,在地址栏输入“https://weibo.com/”,并按下回车键。此时,在开发者工具中会显示出所有与该网页相关的网络请求记录。

接下来,我们需要选择其中的一条请求记录并查看其响应头信息。在响应头信息中,我们可以找到一个名为“Set-Cookie”的字段,该字段的值即为我们需要的Cookie信息。

四、使用Cookie进行页面访问

获取到Cookie信息后,我们就可以使用它来访问微博页面了。代码如下:

python

from selenium.webdriver.common.desired_capabilities import DesiredCapabilities

import requests

#获取Cookie信息

cookie ='你的Cookie信息'

#使用Cookie访问微博页面

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64; rv:95.0) Gecko/20100101 Firefox/95.0',

'Cookie': cookie

}

url ='https://weibo.com'

response = requests.get(url, headers=headers)

print(response.text)

在这段代码中,我们使用了Python自带的requests库来发送HTTP请求,并将之前获取到的Cookie信息添加到了请求头中。然后,我们访问了微博的首页,并打印出了返回结果。

五、使用Selenium模拟滚动操作

在获取到了某个微博账号或话题下的首页内容后,我们还需要进一步获取更多的内容。由于微博页面是动态加载的,因此我们需要使用Selenium模拟滚动操作来加载更多的内容。代码如下:

python

import time

#模拟滚动操作

SCROLL_PAUSE_TIME = 2

last_height = browser.execute_script("return document.body.scrollHeight")

while True:

browser.execute_script("window.scrollTo(0, document.body.scrollHeight);")

time.sleep(SCROLL_PAUSE_TIME)

new_height = browser.execute_script("return document.body.scrollHeight")

if new_height == last_height:

break

last_height = new_height

在这段代码中,我们首先定义了一个常量SCROLL_PAUSE_TIME,表示每次滚动操作后的等待时间。然后,我们使用execute_script方法执行JavaScript代码来模拟滚动操作。具体来说,我们将窗口滚动到页面最底部,并等待一段时间,然后再次获取页面高度。如果新的页面高度与上一次相同,则说明已经加载完毕。

六、解析微博内容

在获取到了所有需要的微博内容后,我们需要对其进行解析。由于微博页面的结构比较复杂,因此我们需要使用一个HTML解析库来进行解析。这里我们选择使用Python自带的lxml库。代码如下:

python

from lxml import etree

#解析微博内容

html = browser.page_source

tree = etree.HTML(html)

weibo_list = tree.xpath('//div[@class="WB_detail"]')

for weibo in weibo_list:

#解析微博文本和图片信息

text = weibo.xpath('.//p[@class="txt"]/text()')[0]

images = weibo.xpath('.//img/@src')

print(text, images)

在这段代码中,我们首先使用page_source属性获取当前页面的HTML源码。然后,我们使用etree.HTML方法将源码解析成一个Element对象。接着,我们使用XPath语法来获取微博内容,具体来说,我们获取了每个微博的WB_detail元素,并从中解析出了微博文本和图片信息。

七、存储微博内容

在解析完微博内容后,我们可以将其存储到本地或者数据库中,以便后续的分析和研究。代码如下:

python

import json

#存储微博内容

data =[]

for weibo in weibo_list:

#解析微博文本和图片信息

text = weibo.xpath('.//p[@class="txt"]/text()')[0]

images = weibo.xpath('.//img/@src')

#存储数据

item ={

'text': text,

'images': images

}

data.append(item)

with open('weibo.json','w') as f:

json.dump(data,f)

在这段代码中,我们首先定义了一个空列表data,用于存储所有的微博内容。然后,对于每个微博,我们都将其解析成一个字典,并添加到data列表中。最后,我们使用Python自带的json库将data列表以JSON格式存储到本地文件weibo.json中。

八、避免反爬虫机制

在进行网页爬取操作时,我们需要注意避免被目标网站的反爬虫机制所识别和封禁。具体来说,我们可以采取以下一些措施:

1.降低爬取频率:可以在每次请求之间添加适当的等待时间,以降低访问速度。

2.使用代理IP:可以使用代理服务器来隐藏真实IP地址,以避免被目标网站识别。

3.随机请求头:可以随机生成请求头信息,以避免被目标网站识别。

九、总结

本文介绍了如何使用Python来抓取微博内容。具体来说,我们使用Selenium模拟登录微博,并获取到了Cookie信息。然后,我们使用Cookie访问了微博页面,并使用Selenium模拟滚动操作来加载更多的内容。最后,我们使用lxml库解析了微博内容,并将其存储到本地文件中。

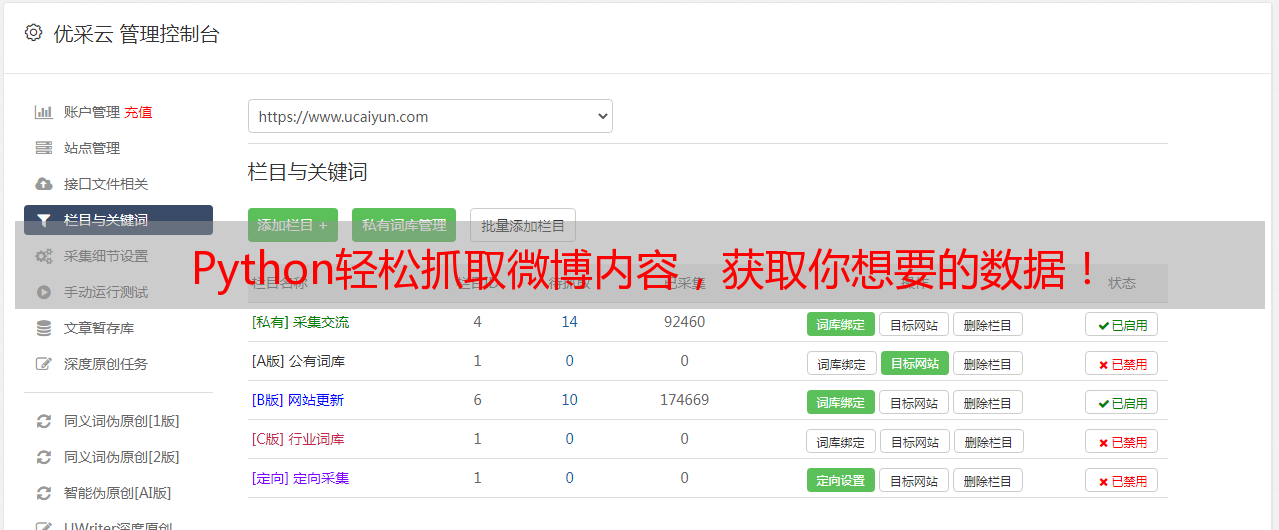

十、优采云

如果你想要更加深入地学习Python和数据分析技术,那么你可以尝试使用优采云提供的在线课程和实战项目。优采云是一家专注于Python数据分析和人工智能技术的在线教育平台。我们为学员提供了丰富的学习资源和实践机会,帮助他们快速成长为优秀的数据分析师和人工智能工程师。欢迎访问我们的官网www.ucaiyun.com,了解更多信息。