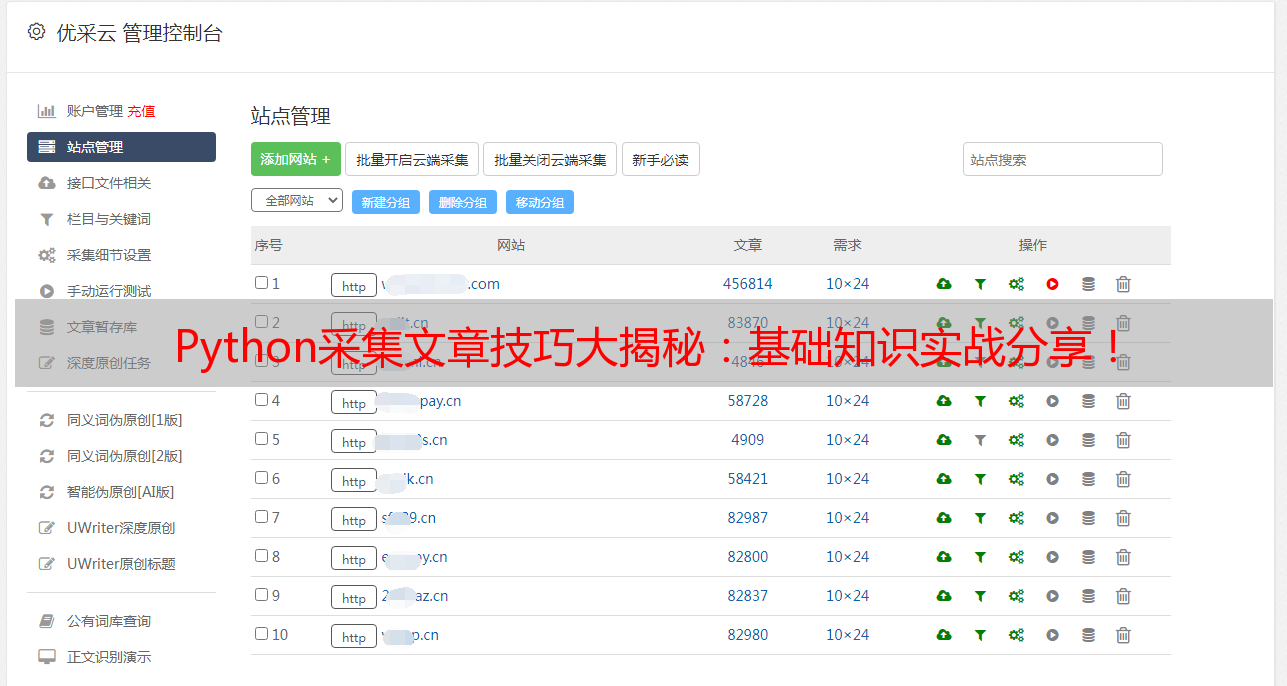

Python采集文章技巧大揭秘:基础知识实战分享!

优采云 发布时间: 2023-04-22 12:46Python作为一种高级编程语言,有着广泛的应用场景。其中,Python采集文章是其重要的应用方向之一。本文将从以下10个方面逐步分析Python采集文章的实现方法和技巧。

一、Python基础知识

在进行Python采集文章之前,需要掌握基本的Python语法、数据类型和函数等基础知识。对于刚入门的读者,建议先学习相关的教程和视频,熟悉Python编程环境和操作方法。

二、网络爬虫原理

Python采集文章的核心技术是网络爬虫。网络爬虫是指通过程序自动访问网页并提取所需信息的技术。其原理是模拟浏览器行为,发送HTTP请求并解析响应内容,从中提取所需信息。

三、HTTP协议

在进行网络爬虫时,需要了解HTTP协议。HTTP协议是Web通信的基础,它定义了客户端和服务器之间的通信规则。通过掌握HTTP协议,可以更好地理解网络爬虫的实现过程。

四、BeautifulSoup库

BeautifulSoup是Python中常用的HTML解析库,用于从HTML或XML文档中提取数据。通过使用BeautifulSoup库,可以方便地从网页中提取所需信息。

五、XPath和CSS选择器

XPath和CSS选择器是两种常用的网页元素定位方法。XPath是XML路径语言的缩写,它通过路径表达式来选取XML文档中的节点或节点集合。CSS选择器则是一种用于选取HTML文档中特定元素的语法。

六、正则表达式

正则表达式是一种用于匹配字符串的工具。在进行Python采集文章时,有时需要使用正则表达式来提取所需信息。掌握正则表达式可以让我们更加灵活地处理网页内容。

七、Selenium库

Selenium是一种自动化测试工具,也可以用于网络爬虫。通过使用Selenium库,我们可以模拟浏览器行为,并获取JavaScript生成的页面内容。

八、Scrapy框架

Scrapy是一个Python编写的开源网络爬虫框架。它内置了多种功能,包括数据抓取、数据处理和数据存储等。使用Scrapy可以快速构建高效稳定的网络爬虫程序。

九、反爬虫技术

为了防止被恶意爬虫攻击,一些网站会采用反爬虫技术。其中比较常见的技术包括IP封锁、验证码和User-Agent检测等。在进行Python采集文章时,需要注意避免被反爬虫技术识别。

十、Python采集文章实例

最后,我们通过一个具体的Python采集文章实例来展示上述技术的应用。假设我们需要从某个新闻网站上采集最近一周的文章标题和链接,并保存到本地文件中。我们可以使用Python代码实现这一功能。

python

import requests

from bs4 import BeautifulSoup

url ='https://www.example.com/news/'

headers ={'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text,'html.parser')

articles = soup.find_all('article')

with open('news.txt','w', encoding='utf-8') as f:

for article in articles:

title = article.find('h2').text

link = article.find('a')['href']

f.write(title +'\t'+ link +'\n')

以上代码使用requests库发送HTTP请求,使用BeautifulSoup库解析HTML文档,并使用文件操作将结果保存到本地文件中。

通过以上10个方面的分析,相信读者已经对Python采集文章有了更深刻的理解。在实际应用中,需要根据具体情况选择合适的技术和工具,并遵守相关法律法规和道德规范。优采云提供的SEO优化服务可以帮助网站提高排名,欢迎访问www.ucaiyun.com了解更多信息。