Python爬虫自动获取公众号文章列表,轻松实现!

优采云 发布时间: 2023-04-21 07:34近年来,随着微信公众号的崛起,越来越多的企业和个人开始使用微信公众号来传播信息。但是,想要获取某个公众号的全部文章列表是一件非常麻烦的事情。手动复制粘贴每篇文章的链接,然后再去下载,这样的方式既费时又费力。那么有没有一种更加高效、自动化的方法呢?答案是肯定的。本文将介绍如何使用Python爬虫技术来实现自动获取微信公众号文章列表,并将其保存到本地文件中。

第一步:获取公众号的历史消息页面

首先,我们需要获取到该公众号历史消息页面的URL地址。这个URL地址可以通过在微信公众平台上登录该公众号后,在历史消息页面中查看得到。我们可以使用requests库来发送HTTP请求,并使用BeautifulSoup库来解析HTML文档。

9124f3bace2c53be0cbc40e2643c5c81#公众号历史消息页面URL

url ='https://mp.weixin.qq.com/mp/profile_ext?action=home&__biz=Mzg5ODA2MjQyOA==&scene=124#wechat_redirect'

#发送HTTP请求

response = requests.get(url)

#解析HTML文档

soup = BeautifulSoup(response.content,'html.parser')

第二步:获取公众号文章列表

在历史消息页面中,我们可以找到所有文章的标题、发布时间、阅读量等信息。我们可以通过解析HTML文档来获取这些信息,并将其保存到一个列表中。在此之前,我们需要先找到包含文章列表的标签。

python

#找到包含文章列表的标签

article_list = soup.find_all('div', class_='weui_media_bd')

接下来,我们可以遍历这个标签列表,并从中提取出每篇文章的标题、发布时间、阅读量等信息。

python

for article in article_list:

#获取文章标题

title = article.h4.text.strip()

#获取发布时间和阅读量

time_and_read = article.p.text.strip()

time = time_and_read.split()[0]

read = time_and_read.split()[1]

#将这些信息保存到一个字典中,并将字典添加到列表中

article_dict ={

'title': title,

'time': time,

'read': read

}

articles.append(article_dict)

第三步:保存文章列表到本地文件

最后一步是将文章列表保存到本地文件中。我们可以使用Python内置的csv库来实现这个功能。

python

import csv

#将文章列表保存到CSV文件中

with open('articles.csv','w', encoding='utf-8-sig', newline='') as csvfile:

writer = csv.writer(csvfile)

writer.writerow(['标题','发布时间','阅读量'])

for article in articles:

writer.writerow([article['title'], article['time'], article['read']])

到此为止,我们已经成功地使用Python爬虫技术实现了自动获取微信公众号文章列表的功能。这个方法不仅可以帮助我们省去手动复制粘贴的麻烦,还可以自动保存文章列表到本地文件中,方便我们后续的数据分析和处理。

总结一下,获取微信公众号文章列表的步骤如下:

1.获取公众号历史消息页面的URL地址;

2.发送HTTP请求,并解析HTML文档;

3.找到包含文章列表的标签,遍历标签列表并提取出每篇文章的标题、发布时间、阅读量等信息;

4.将这些信息保存到一个字典中,并将字典添加到列表中;

5.使用csv库将文章列表保存到本地文件中。

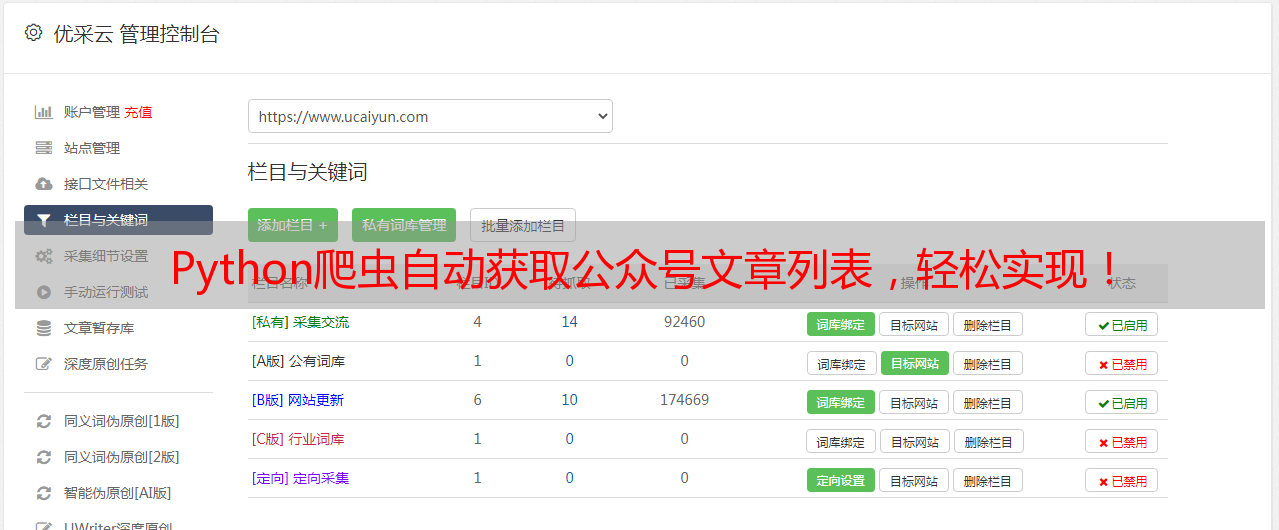

以上就是本文介绍的内容。如果你想深入了解Python爬虫技术,可以关注优采云官网(www.ucaiyun.com)。优采云是一家专业的SEO优化服务提供商,拥有多年的行业经验和专业的技术团队。