轻松采集!八招教你玩转crawling插件,提高效率!

优采云 发布时间: 2023-04-20 15:48在信息时代,信息的获取和利用是至关重要的。而对于自媒体从业者来说,采集和处理大量信息更是必不可少的一项工作。然而,手动获取信息既费时又费力,而且难以保证准确性。这时候,crawling采集插件就可以帮助我们轻松实现信息的快速采集和自动化处理。本文将从八个方面详细介绍crawling采集插件的使用方法和优势。

一、crawling采集插件的基本概念

crawling采集插件是一款基于Python语言开发的网络爬虫工具,它可以模拟浏览器行为,自动化地获取网页数据,并将其保存到本地或数据库中。其主要特点包括:支持多线程、支持JavaScript渲染、支持定时任务、支持数据去重等。使用crawling采集插件,我们可以快速地抓取大量数据,并进行进一步的分析处理。

二、crawling采集插件的安装与配置

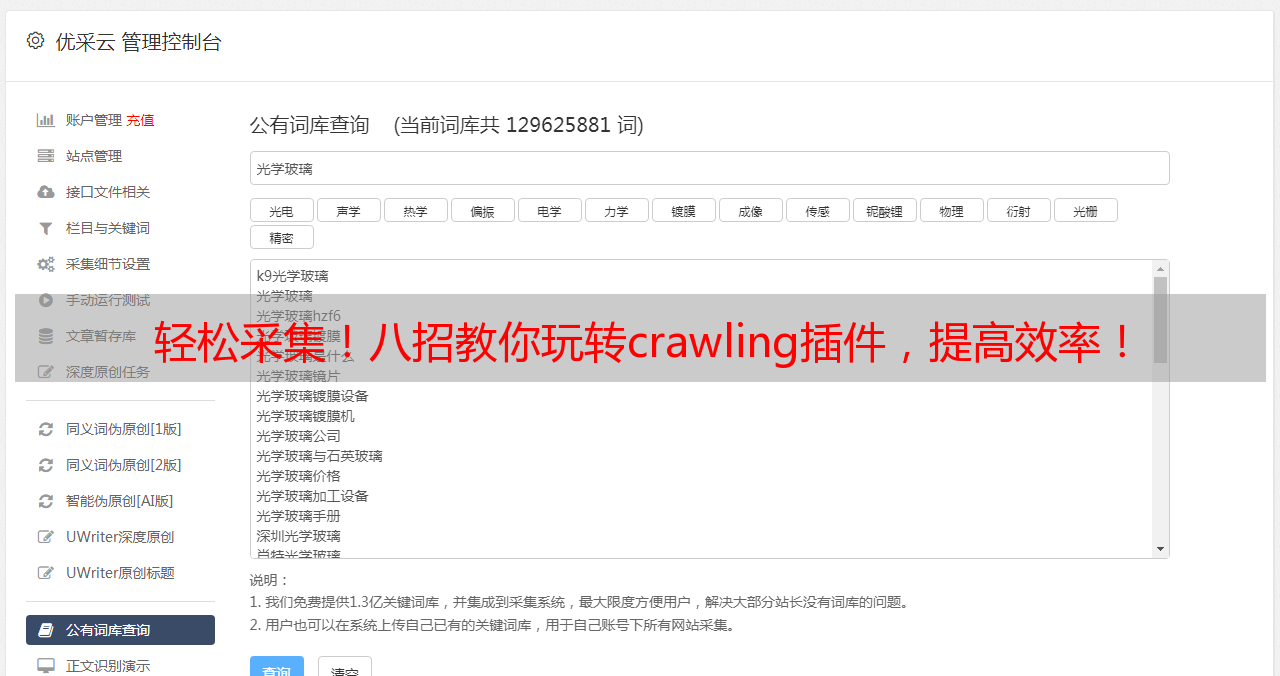

安装crawling采集插件非常简单,只需要在命令行中输入pip install crawling即可完成安装。安装完成后,我们需要进行一些配置,如设置代理、设置请求头、设置爬虫间隔时间等。在这里,我们推荐使用优采云提供的crawling采集插件,它不仅安全可靠,而且支持云端配置,让用户可以更加方便地进行配置和管理。

三、crawling采集插件的基本用法

crawling采集插件的基本用法非常简单。我们只需要定义一个Spider类,并在其中编写对应的爬虫逻辑即可。具体来说,我们需要定义start_urls(起始URL)、parse(解析函数)等属性和方法,并在解析函数中编写数据提取和保存逻辑。另外,我们还可以通过设置ITEM_PIPELINES等参数来进一步处理数据。下面是一个简单的crawling采集插件示例:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['http://www.example.com']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

'tags': quote.css('div.tags a.tag::text').getall(),

}

四、crawling采集插件的高级用法

除了基本用法外,crawling采集插件还提供了许多高级用法,如使用Selenium模拟浏览器、使用代理IP、处理验证码等。这些高级用法可以帮助我们更好地应对各种复杂情况。下面是一个使用Selenium模拟浏览器的crawling采集插件示例:

python

import scrapy

from scrapy_selenium import SeleniumRequest

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['http://www.example.com']

def start_requests(self):

for url in self.start_urls:

yield SeleniumRequest(url=url, callback=self.parse)

def parse(self, response):

#使用response来获取网页源代码,进行进一步解析和处理

五、crawling采集插件的数据存储

crawling采集插件支持将数据保存到本地文件或数据库中,以供后续使用。其中,本地文件保存方式包括CSV、JSON、XML等格式,而数据库保存方式则包括MySQL、MongoDB等常见数据库。下面是一个将数据保存到MySQL数据库的crawling采集插件示例:

python

import scrapy

from scrapy.utils.project import get_project_settings

from scrapy.exporters import CsvItemExporter

from scrapy.exceptions import DropItem

import mysql.connector

class MySQLPipeline(object):

def open_spider(self, spider):

self.settings = get_project_settings()

self.conn = mysql.connector.connect(

host=self.settings['MYSQL_HOST'],

port=self.settings['MYSQL_PORT'],

user=self.settings['MYSQL_USER'],

password=self.settings['MYSQL_PASSWORD'],

database=self.settings['MYSQL_DATABASE']

)

self.cursor = self.conn.cursor()

self.cursor.execute("""

CREATE TABLE IF NOT EXISTS quotes (

id INT AUTO_INCREMENT PRIMARY KEY,

text TEXT,

author TEXT,

tags TEXT

)

""")

self.conn.commit()

def close_spider(self, spider):

self.cursor.close()

self.conn.close()

def process_item(self, item, spider):

self.cursor.execute("""

INSERT INTO quotes (text, author, tags) VALUES (%s,%s,%s)

""",(item['text'], item['author'],','.join(item['tags'])))

self.conn.commit()

return item

六、crawling采集插件的优缺点

crawling采集插件作为一款强大的网络爬虫工具,具有许多优点,如高效快速、支持自定义、支持多线程等。同时,它也存在一些缺点,如易被封IP、需要定期维护等。因此,在使用crawling采集插件时,我们需要注意一些细节问题,并根据实际情况进行调整。

七、crawling采集插件与SEO优化的结合

在进行自媒体运营时,SEO优化是一个非常重要的环节。而crawling采集插件可以帮助我们获取更多的数据,从而更好地进行关键词分析和竞争对手分析,为SEO优化提供更多的参考依据。同时,我们还可以通过crawling采集插件来获取搜索引擎的爬虫数据,并对其进行分析和优化。

八、crawling采集插件的应用实例

最后,我们以一个实际应用实例来介绍crawling采集插件的使用。假设我们要获取某电商网站上所有商品的名称、价格和销量等信息,并进行数据分析和处理。我们可以使用crawling采集插件来实现自动化的数据采集和处理,具体步骤如下:

1.确定目标网站和需要获取的信息;

2.使用crawling采集插件编写对应的爬虫逻辑,并设置起始URL;

3.使用xpath或css选择器来提取所需信息,并将其保存到本地文件或数据库中;

4.对数据进行进一步分析和处理,如计算平均价格、统计销量排行等;

5.根据分析结果进行相应决策,如优化营销策略、调整产品定价等。

通过这样一系列操作,我们可以快速地获取大量有用数据,并利用其进行业务决策,提高自媒体运营效率和效果。

在本文中,我们详细介绍了crawling采集插件的基本概念、安装配置、基本用法、高级用法、数据存储、优缺点、与SEO优化的结合以及应用实例等内容。希望这些内容能够帮助读者更好地了解和使用crawling采集插件,实现信息的快速采集和自动化处理。如果您想了解更多关于crawling采集插件的信息,可以访问优采云官网www.ucaiyun.com。