自动抓取网页技术:自媒体人必备的利器

优采云 发布时间: 2023-04-19 10:45互联网时代,信息爆炸,如何快速、准确地获取大量有价值的内容成为了自媒体人迫切需要解决的问题。而自动抓取网页技术的出现,为自媒体人提供了一种高效、便捷的获取内容的方式。本文将从多个方面介绍自动抓取网页技术,帮助自媒体人更好地利用这项技术。

一、什么是自动抓取网页

自动抓取网页是指利用程序从互联网上获取所需数据的过程。可以理解为一种“采集”数据的方式。通过程序代码,能够实现对指定网站或页面进行数据的“采集”,并将采集到的数据保存到本地或者其他数据库中。

二、自动抓取网页的应用场景

1.自媒体:在写作过程中,需要引用大量外部信息作为佐证。如果手动搜索并复制粘贴这些信息,将浪费大量时间和精力。利用自动抓取技术,可以轻松地获取所需信息。

2.数据分析:在进行市场调研时,需要收集大量相关数据。利用自动抓取技术,可以快速、准确地获取所需数据。

3.搜索引擎优化(SEO):通过自动抓取技术,可以获取大量网站的内容信息,进行数据分析和研究,为SEO优化提供有力支持。

三、自动抓取网页的工作原理

自动抓取网页的工作原理主要包括以下几个步骤:

1.发送请求:程序向目标网站发送请求,获取需要采集的页面内容。

2.解析HTML:程序对页面进行解析,将需要采集的数据提取出来。

3.存储数据:程序将采集到的数据存储到本地或其他数据库中。

四、常见的自动抓取网页工具

1. Scrapy:Scrapy是一个基于Python语言的开源网络爬虫框架。它可以帮助我们快速、高效地开发出一个完整的爬虫系统。

2. BeautifulSoup:BeautifulSoup是一个Python库,用于从HTML或XML文件中提取数据。它能够解析HTML文件,并提供一些简单而有用的方法来遍历文档树、搜索文档树以及修改文档树中的标签元素等操作。

3. Selenium:Selenium是一个用于Web应用程序测试的工具。它支持多种浏览器,并且可以模拟用户在浏览器中的操作,包括点击、输入、下拉等操作。

五、自动抓取网页的注意事项

1.遵守相关法律法规:在进行自动抓取网页时,需要遵守相关的法律法规。不得盗用他人信息,不得侵犯他人隐私。

2.网站协议:在进行自动抓取网页时,需要遵守目标网站的协议。不得违反目标网站的规定。

3.数据清洗:在进行自动抓取网页时,需要对采集到的数据进行清洗,去除无用数据和垃圾信息。

六、自动抓取网页的优缺点

1.优点:可以高效、快速地获取所需信息;可以大量地获取信息,为自媒体创作者提供更多素材;可以节省大量时间和精力。

2.缺点:需要遵守相关法律法规和网站协议;需要对采集到的数据进行清洗;可能会被目标网站封禁IP地址等限制。

七、如何使用自动抓取网页技术

1.确定采集目标:首先需要确定所需采集的目标。可以根据需求确定采集对象的URL地址。

2.编写程序代码:根据采集目标,编写相应的程序代码。

3.运行程序:将程序代码运行后,即可开始采集所需数据。

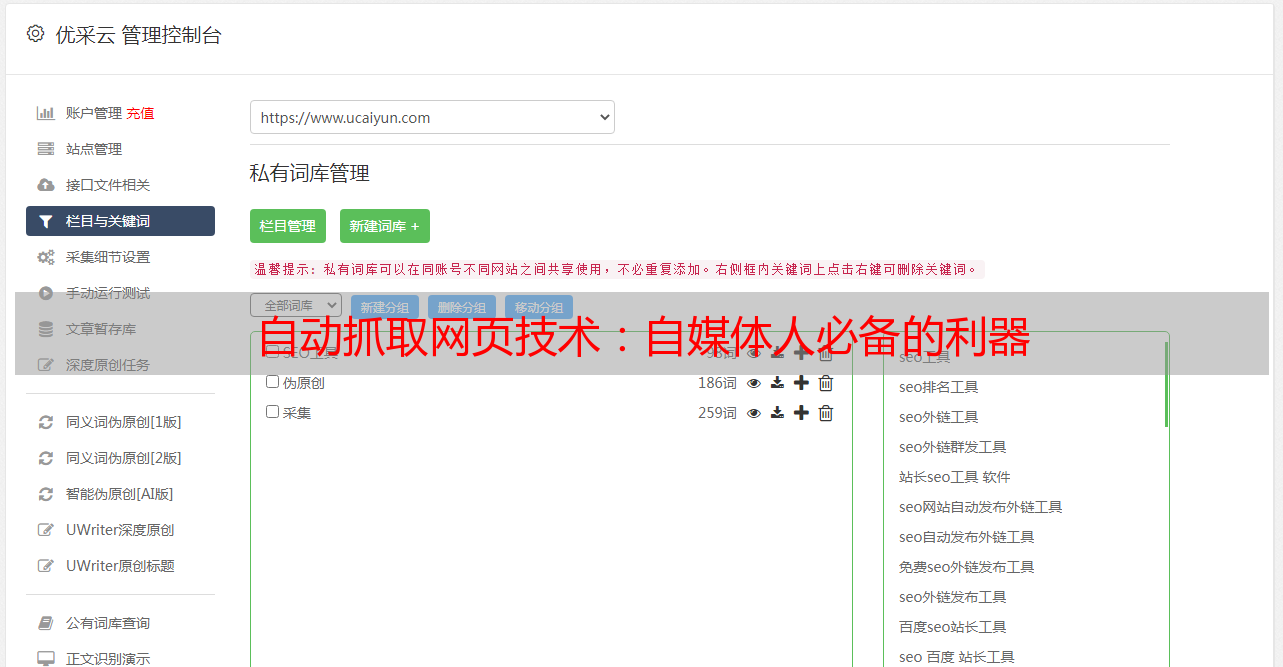

八、优采云为自动抓取网页提供支持

优采云是一家专业的互联网技术服务公司,提供自动抓取网页技术服务。通过优采云的服务,自媒体人可以轻松地获取所需信息,提高工作效率。同时,优采云还为SEO优化提供了有力支持。了解更多,请访问www.ucaiyun.com。

九、结语

自动抓取网页技术为自媒体创作者提供了一种高效、便捷的获取内容的方式。但在使用该技术时,需要遵守相关法律法规和网站协议。同时也需要对采集到的数据进行清洗,去除无用数据和垃圾信息。希望本文能够帮助自媒体人更好地利用自动抓取网页技术。