Java爬虫轻松抓取网页数据!编写简单程序,获取目标数据

优采云 发布时间: 2023-04-18 06:29众所周知,爬虫技术是从互联网中获取数据的一种有效手段。Java语言作为一门广泛应用于Web开发的语言,在爬虫领域也有着广泛的应用。本文将介绍如何使用Java编写一个简单的爬虫程序,来获取目标页面的数据。

一、准备工作

在开始编写爬虫程序之前,我们需要安装一些必要的工具,包括Java开发环境、Maven构建工具和Jsoup库。其中,Maven是一个自动化构建工具,可以管理项目依赖,并生成可执行文件;Jsoup是一个Java HTML解析器,可以方便地从HTML文档中提取数据。

二、连接目标页面

在实现爬虫程序之前,我们需要先连接到目标页面。这里我们以百度新闻首页为例:

java

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

public class Spider {

public static void main(String[] args) throws Exception {

Connection connection = Jsoup.connect("https://www.baidu.com/");

Document document = connection.get();

System.out.println(document);

}

}

上述代码通过Jsoup库中的connect()方法连接到目标页面,并使用get()方法获取HTML文档。最后将HTML文档打印到控制台。

三、解析HTML文档

获取HTML文档后,我们需要使用Jsoup库从中提取数据。下面是一个简单的例子,从HTML文档中提取所有的超链接:

java

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class Spider {

public static void main(String[] args) throws Exception {

Document document = Jsoup.connect("https://www.baidu.com/").get();

Elements links = document.select("a[href]");

for (Element link : links){

System.out.println(link.attr("href"));

}

}

}

上述代码中,select()方法用于选择符合条件的元素。在本例中,我们选择所有带有href属性的a标签,并将它们打印到控制台。

四、获取指定元素内容

除了提取链接外,我们还可以使用Jsoup库获取指定元素的内容。下面是一个例子,从百度新闻首页中获取所有新闻标题:

java

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class Spider {

public static void main(String[] args) throws Exception {

Document document = Jsoup.connect("https://news.baidu.com/").get();

Elements titles = document.select(".c-title");

for (Element title : titles){

System.out.println(title.text());

}

}

}

上述代码中,select()方法选择所有class属性为“c-title”的元素,并将它们打印到控制台。

五、处理异常情况

在编写爬虫程序时,我们需要注意异常情况的处理,例如连接超时、页面不存在等。下面是一个例子,处理连接超时异常:

java

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import java.io.IOException;

public class Spider {

public static void main(String[] args){

try {

Connection connection = Jsoup.connect("https://www.baidu.com/").timeout(3000);

Document document = connection.get();

System.out.println(document);

} catch (IOException e){

e.printStackTrace();

}

}

}

上述代码中,timeout()方法设置连接超时时间为3秒。如果连接超时,将会抛出IOException异常。

六、使用代理服务器

在爬虫程序中,我们经常需要使用代理服务器来隐藏自己的IP地址,防止被封禁。下面是一个例子,使用代理服务器连接目标页面:

java

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

public class Spider {

public static void main(String[] args) throws Exception {

Connection connection = Jsoup.connect("https://www.baidu.com/");

connection.proxy("127.0.0.1", 8888);//设置代理服务器

Document document = connection.get();

System.out.println(document);

}

}

上述代码中,proxy()方法设置代理服务器的IP地址和端口号。

七、使用多线程提高效率

当需要处理大量页面数据时,单线程爬虫效率很低。这时我们可以使用多线程来提高效率。下面是一个例子,使用多线程获取多个页面数据:

java

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class Spider {

public static void main(String[] args){

ExecutorService executorService = Executors.newFixedThreadPool(10);//创建线程池

for (int i =0; i < 10;i++){

final int index =i;

executorService.execute(new Runnable(){

@Override

public void run(){

try {

Connection connection = Jsoup.connect("https://www.baidu.com/");

Document document = connection.get();

System.out.println("Thread "+ index +":"+ document.title());

} catch (Exception e){

e.printStackTrace();

}

}

});

}

executorService.shutdown();//关闭线程池

}

}

上述代码中,使用线程池创建10个线程,每个线程连接到目标页面,并打印页面标题。

八、遵守爬虫规范

在进行爬虫活动时,我们需要遵守爬虫规范,不得过度频繁地访问目标网站,以免对网站造成负担。下面是一个例子,使用延时策略来遵守爬虫规范:

java

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

public class Spider {

public static void main(String[] args) throws Exception {

Connection connection = Jsoup.connect("https://www.baidu.com/");

connection.userAgent("Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3");

connection.ignoreHttpErrors(true);

connection.ignoreContentType(true);

Document document = connection.get();

System.out.println(document);

Thread.sleep(1000);//延时1秒

}

}

上述代码中,使用userAgent()方法设置User-Agent头信息,使用ignoreHttpErrors()方法和ignoreContentType()方法忽略HTTP错误和ContentType错误。最后使用Thread.sleep()方法延时1秒。

九、总结

通过本文的介绍,我们了解了Java爬虫程序的基本实现方式,并学习了如何连接目标页面、解析HTML文档、获取指定元素内容、处理异常情况、使用代理服务器、使用多线程提高效率、遵守爬虫规范等知识点。希望读者能够根据本文的介绍,编写出自己的Java爬虫程序。

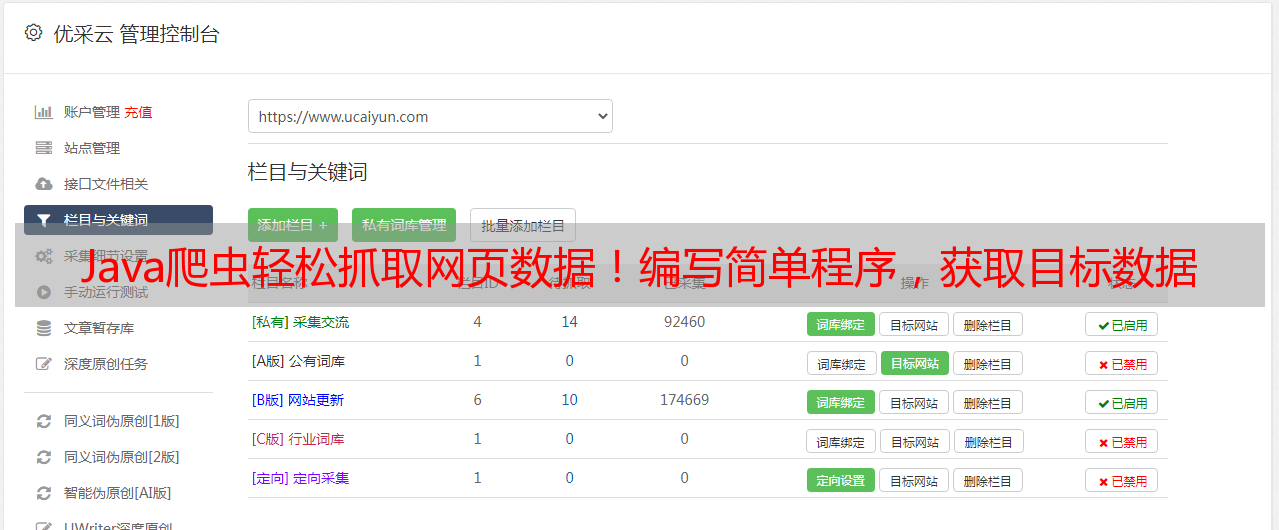

本文由优采云提供技术支持,优采云是一家专业的SEO优化服务提供商,致力于为企业客户提供高质量的SEO优化服务,更多详情请访问www.ucaiyun.com。