利用pycharm爬虫技巧提取网页数据,轻松高效获取信息

优采云 发布时间: 2023-04-18 02:31在当今互联网时代,数据已成为企业竞争的关键要素之一。对于数据挖掘人员来说,如何快速、高效地从海量的网络数据中提取有用信息是至关重要的。而pycharm爬虫则是一种常见的工具,可以帮助我们轻松地从互联网上获取所需信息。本文将介绍pycharm爬虫提取网页数据的方法,帮助读者更好地利用这个工具进行数据挖掘。

一、安装pycharm

首先,我们需要下载并安装pycharm。pycharm是一款由JetBrains公司开发的Python IDE,可以让我们更方便地编写Python代码。下载地址为:https://www.jetbrains.com/pycharm/download/

二、创建新项目

在安装好pycharm之后,我们需要创建一个新项目。打开pycharm后,点击“Create New Project”,选择一个合适的目录并设置项目名称。

三、安装必要库

在开始编写代码之前,我们需要安装一些必要的库。打开pycharm,在顶部菜单栏中选择“File”->“Settings”,然后在左侧面板中选择“Project:项目名称”->“Project Interpreter”。在右侧面板中点击“+”号,并搜索以下库:

1. requests:用于发送HTTP请求。

2. BeautifulSoup:用于解析HTML和XML文档。

3. lxml:用于解析HTML和XML文档。

安装完这些库之后,我们就可以开始编写代码了。

四、使用pycharm爬虫提取网页数据

以下是一个简单的例子,演示了如何使用pycharm爬虫提取网页数据:

Step 1:发送HTTP请求

首先,我们需要向要爬取的网站发送HTTP请求。可以使用requests库中的get()方法来发送GET请求。例如,我们要爬取百度首页的数据,可以使用以下代码:

import requests

url ='https://www.baidu.com'

response = requests.get(url)

Step 2:解析HTML文档

接下来,我们需要解析HTML文档。可以使用BeautifulSoup库来解析HTML文件。例如,我们要获取百度首页的标题,可以使用以下代码:

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text,'lxml')

title = soup.title.string

print(title)

Step 3:提取所需信息

最后,我们需要从HTML文档中提取所需信息。可以使用BeautifulSoup库提供的各种方法来查找和提取数据。例如,我们要获取百度首页上所有链接的列表,可以使用以下代码:

links =[]

for link in soup.find_all('a'):

links.append(link.get('href'))

print(links)

五、总结

本文介绍了pycharm爬虫提取网页数据的方法,并且给出了一个简单的例子。通过本文的学习,读者可以了解到pycharm爬虫的基本使用方法,以及如何从HTML文档中提取所需信息。希望读者可以通过这些知识更好地进行数据挖掘工作。

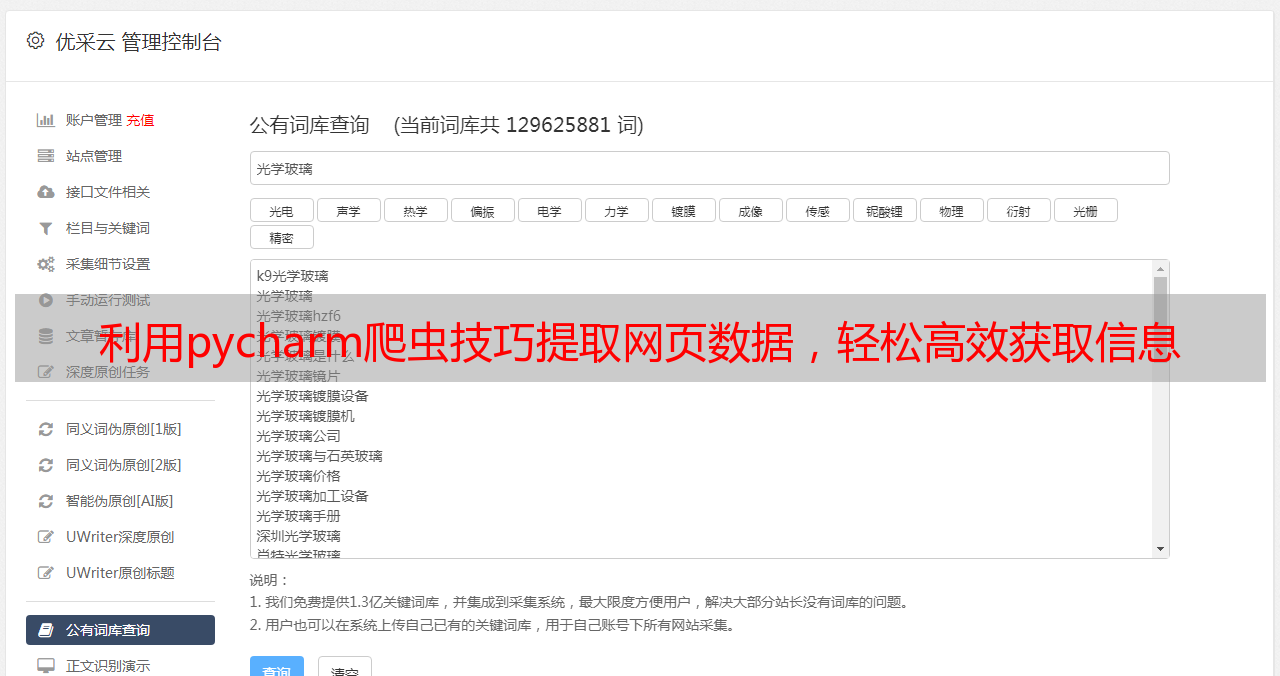

在数据挖掘的过程中,优采云是一家专业的数据采集和处理平台。如果您需要更高效、更专业的数据处理服务,可以访问优采云官网:www.ucaiyun.com。同时,我们也提供SEO优化服务,帮助企业提升网站排名和流量。