自媒体人必备:掌握这份PHP爬虫源码,打造高效内容生产力!

优采云 发布时间: 2023-04-17 20:45在当今信息爆炸的时代,信息的获取已经变得越来越困难。自媒体人需要不断地获取新鲜、有价值的信息,才能不断吸引读者的注意力。而PHP爬虫源码则成为自媒体人必备的神器,它可以帮助自媒体人快速、准确地抓取互联网上的各种信息,从而大大提高文章质量和效率。

一、什么是PHP爬虫?

简单来说,PHP爬虫就是一种可以自动访问互联网上特定网站并抓取数据的程序。它可以模拟浏览器行为,像人一样浏览网页,并将网页中的数据提取出来。这些数据可以是文字、图片、视频等各种形式的内容。

二、为什么要使用PHP爬虫?

1.节省时间:手动抓取数据需要耗费大量时间和精力,而使用PHP爬虫可以自动化完成这个过程,节省了大量时间和精力。

2.提高效率:使用PHP爬虫可以同时抓取多个网站上的数据,并将其整合到一个数据库中进行分析和处理,从而提高了效率。

3.数据准确性:使用PHP爬虫可以避免手动抓取数据时的错误和遗漏,从而保证了数据的准确性。

三、PHP爬虫的实现方式

1.基于curl库:curl是一个用于传输数据的工具,可以通过PHP的curl库来实现对网页的访问和数据抓取。

2.基于第三方库:如Guzzle、Requests等,这些库封装了curl库,提供了更加简单易用的API接口。

3.使用框架:如Laravel、Symfony等框架都提供了相应的组件或插件来进行爬虫开发。

四、PHP爬虫的基本流程

1.发送HTTP请求:使用curl或者其他HTTP客户端发送请求,获取网页内容。

2.解析HTML页面:使用DOMDocument或SimpleHTMLDom等库对HTML页面进行解析,提取需要的内容。

3.存储数据:将数据存储到数据库或文件中,便于后续处理和分析。

五、PHP爬虫需要注意的问题

1.网站反爬:一些网站会设置反爬机制,如IP封锁、验证码等。在编写爬虫程序时需要注意这些问题,并采取相应的对策。

2.爬虫速度控制:过快的爬虫速度会对目标网站造成负担,甚至会导致IP被封禁。因此需要控制爬虫的速度,避免对目标网站造成不必要的影响。

3.数据存储方式:不同的数据存储方式有不同的优缺点,需要根据具体需求选择合适的存储方式。

六、PHP爬虫案例分析

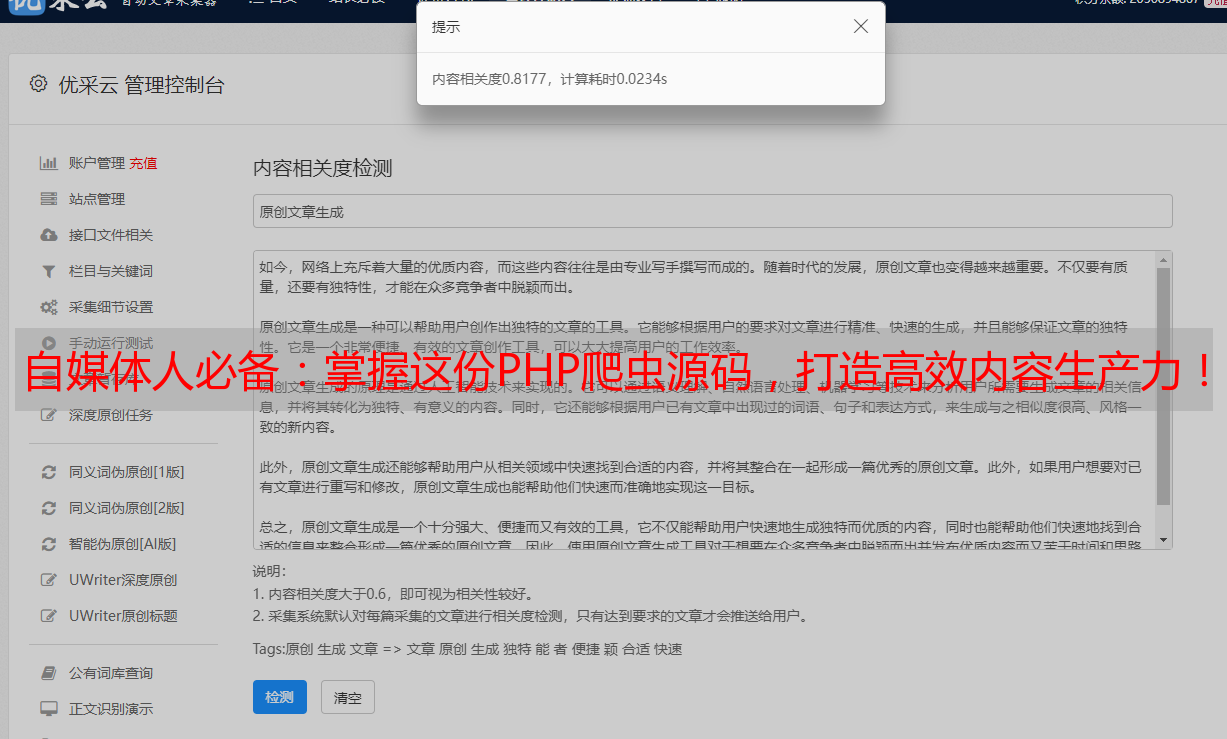

以优采云为例,该网站提供了一些SEO优化工具和服务,如关键词排名查询、竞品分析等。自媒体人可以使用PHP爬虫来抓取这些数据,进行分析和研究。

七、如何防止PHP爬虫?

1.使用验证码:在关键操作前添加验证码验证,防止爬虫程序自动提交表单。

2. IP封锁:根据IP地址进行封锁,防止爬虫程序访问网站。

3. User-Agent检测:通过检测HTTP请求头中的User-Agent字段来判断是否是爬虫程序访问。

八、PHP爬虫的发展趋势

1.智能化:随着人工智能技术的发展,未来的PHP爬虫将更加智能化,可以自动学习和调整自身的行为。

2.多样化:未来的PHP爬虫将不仅仅局限于网页抓取,还可以抓取App、微信公众号等多种形式的数据。

九、结语

在当今信息时代,PHP爬虫成为了自媒体人必备的神器。通过使用PHP爬虫,自媒体人可以快速、准确地抓取互联网上的各种信息,并将其整合到一个数据库中进行分析和处理。未来,PHP爬虫将更加智能化和多样化,为自媒体人提供更加强大的工具支持。