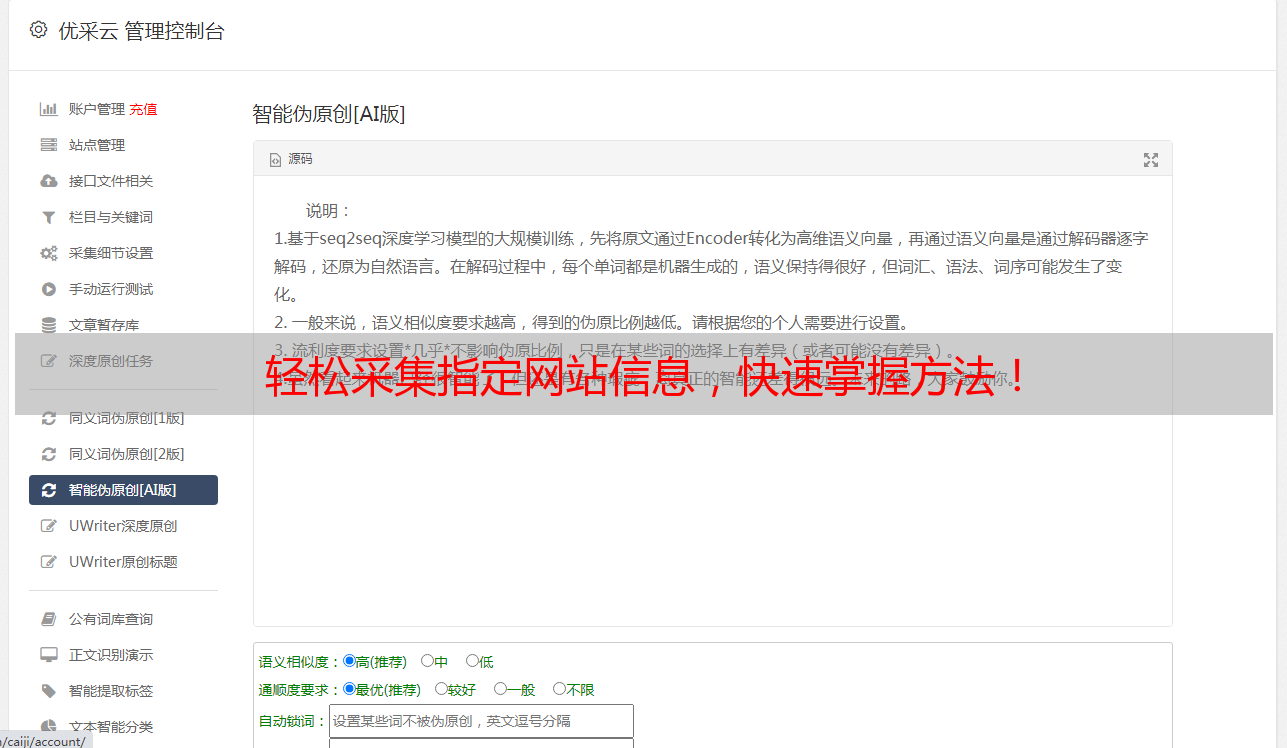

轻松采集指定网站信息,快速掌握方法!

优采云 发布时间: 2023-04-16 05:51在互联网时代,信息获取已经变得异常方便。然而,如果你需要采集某个特定网站的信息,该怎么办呢?这时候,我们就需要一些专业的技巧和工具来帮助我们。本文将从八个方面详细介绍如何采集指定网站,并给出相应的案例分析。

第一步:确定采集目标

首先,我们需要明确自己想要获取哪些信息。比如说,我们想要采集某个电商网站上所有商品的名称、价格、销量等信息。在确定了采集目标之后,我们需要分析该网站的结构和数据来源。

案例分析:假设我们想要采集优采云(www.ucaiyun.com)上所有SEO优化相关的文章。首先,我们可以通过浏览器开发者工具查看文章列表页的HTML代码结构,找到文章标题、链接、发布时间等关键信息所在的位置。

第二步:选择合适的采集工具

根据采集目标和数据来源结构,我们可以选择不同的采集工具。常用的有Python爬虫框架Scrapy、Node.js爬虫框架Puppeteer、可视化采集工具Octoparse等。根据自己的需求和技术水平选择合适的工具。

案例分析:由于我们需要采集的是一个网站上的文章信息,因此我们可以使用Scrapy框架来实现。Scrapy是一个高效、可扩展的Python爬虫框架,可以帮助我们快速采集数据。

第三步:编写爬虫代码

在选择了采集工具之后,我们需要编写相应的爬虫代码。这部分工作需要一定的编程基础和对HTML、CSS、JavaScript等前端技术有一定的了解。

案例分析:在Scrapy框架中,我们需要先定义要采集的数据结构,比如文章标题、链接、发布时间等。然后,在Spider模块中编写相应的解析规则,从HTML代码中提取出所需信息。最后,在Pipeline模块中将采集到的数据保存到本地文件或数据库中。

第四步:设置请求头和代理IP

为了避免被目标网站识别为爬虫并禁止访问,我们需要设置请求头和使用代理IP进行访问。请求头应该包含User-Agent等信息,并尽量模拟人类操作行为;代理IP可以通过第三方服务商购买或自己搭建。

案例分析:在Scrapy框架中,我们可以在settings.py文件中设置请求头和代理IP。比如,设置User-Agent为Mozilla/5.0(Windows NT 10.0; Win64; x64)等;使用第三方代理IP服务商提供的API进行IP代理访问。

第五步:处理反爬机制

很多网站会设置反爬机制,比如验证码、IP封禁等。我们需要通过一些技巧来绕过这些机制,保证正常采集。

案例分析:在采集优采云文章时,我们发现该网站会对频繁访问的IP进行封禁。因此,我们可以使用代理IP轮换访问的方式来规避这个问题。

第六步:数据清洗和去重

在采集到大量数据后,我们需要对其进行清洗和去重。这部分工作主要包括数据格式转换、缺失值处理、重复数据删除等。

案例分析:在采集到优采云的SEO文章后,我们需要对其进行去重。可以通过文章标题或链接进行判断,并将重复数据删除。

第七步:定期更新和监控

随着网站内容的不断更新和变化,我们需要定期更新并监控目标网站。可以使用定时任务或Webhook等方式实现自动更新和监控。

案例分析:在采集优采云文章后,我们可以设置定时任务,每天自动更新最新的SEO文章。同时,可以通过Webhook技术实现异常情况的实时监控和报警。

第八步:数据可视化和分析

最后,我们需要将采集到的数据进行可视化和分析,以便更好地理解和利用这些数据。可以使用Python的Matplotlib、Seaborn等库进行数据可视化;使用Pandas、Numpy等库进行数据分析和挖掘。

案例分析:在采集到优采云的SEO文章后,我们可以使用Matplotlib库绘制文章发布时间的趋势图,并使用Pandas库进行关键词提取和频率统计。

以上是关于如何采集指定网站的详细介绍和案例分析。通过本文的学习,相信大家已经掌握了一些基本的采集技巧和工具,并可以根据自己的需求进行相应的操作。如果你还有其他问题或疑问,欢迎联系优采云(www.ucaiyun.com)获取更多信息!