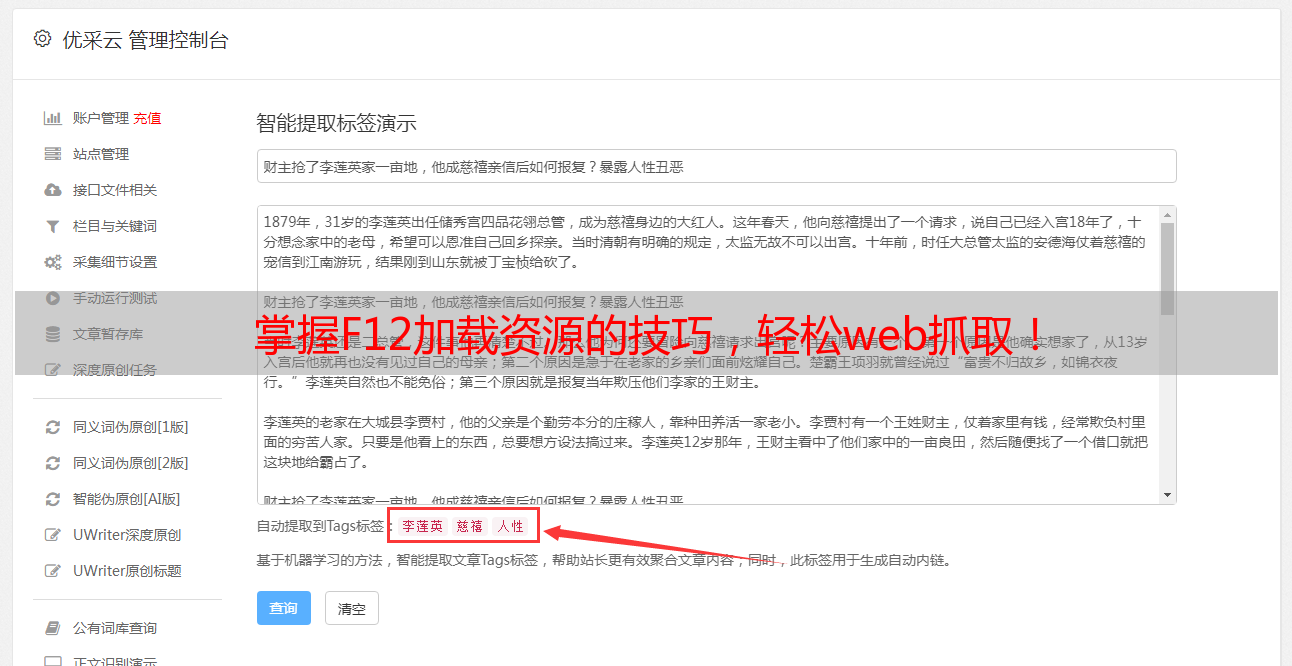

掌握F12加载资源的技巧,轻松web抓取!

优采云 发布时间: 2023-04-15 00:39在网站开发和SEO优化过程中,我们经常需要对网站进行分析和优化。而对于网站上F12加载的资源,我们可以通过web抓取的方式来获取相关数据。本文将从以下9个方面详细介绍web抓取F12加载的资源的方法和技巧。

一、什么是web抓取?

Web抓取又称网络爬虫、网络蜘蛛、网络机器人等,它是一种自动化程序,可以模拟浏览器行为,访问网页并获取相关信息。Web抓取通常用于数据采集、搜索引擎优化、竞品分析等领域。

二、为什么需要web抓取?

通过Web抓取可以获取到网站上所有可见或不可见的资源,包括HTML、CSS、JavaScript、图片、音频、视频等。这些资源对于网站分析和SEO优化非常重要,可以帮助我们了解网站结构、性能瓶颈以及用户行为等信息。

三、如何进行web抓取?

进行web抓取有多种方式,包括手动复制粘贴、使用浏览器插件、使用第三方工具或编写自己的爬虫脚本等。其中,使用浏览器插件是最简单的方法之一,比如Chrome浏览器中的Network、Elements、Console等开发者工具。

四、如何分析F12加载的资源?

在Chrome浏览器中,我们可以通过Network选项卡来查看网站上所有加载的资源,包括HTML、CSS、JavaScript、图片、音频、视频等。通过筛选和排序功能,我们可以快速找到需要的资源,并进行相关分析和优化。

五、如何获取网页源代码?

在Chrome浏览器中,我们可以通过右键菜单或快捷键(Ctrl+U)来查看网页源代码。如果需要获取整个网站的源代码,则需要使用第三方工具或编写自己的爬虫脚本。

六、如何下载网站上的图片和视频?

在Chrome浏览器中,我们可以通过鼠标右键或快捷键(Ctrl+S)来下载网站上的图片和视频。如果需要批量下载,则需要使用第三方工具或编写自己的爬虫脚本。

七、如何模拟登录并获取数据?

对于一些需要登录才能访问的网站,我们可以使用第三方工具或编写自己的爬虫脚本来模拟登录并获取数据。其中,常见的登录方式包括表单提交、Cookies登录、OAuth2.0认证等。

八、如何避免被反爬虫机制封禁?

为了避免被反爬虫机制封禁,我们需要注意以下几点:模拟人类行为、设置抓取频率、使用代理IP、使用随机User-Agent等。同时,我们还需要遵守网站的robots.txt协议,不要过度抓取或爬取敏感信息。

九、如何保护个人隐私和知识产权?

在进行web抓取过程中,我们需要注意保护个人隐私和知识产权。在抓取敏感信息或涉及版权问题的数据时,应该尊重相关法律法规和道德规范,并且遵守网站的robots.txt协议。同时,我们还需要注意数据安全和保密性,不要将敏感信息泄露给第三方。

总之,通过web抓取F12加载的资源,我们可以轻松获取网站数据,并进行相关分析和优化。但是,在进行web抓取过程中,我们需要注意保护个人隐私和知识产权,并且遵守相关法律法规和道德规范。如果您需要更多关于web抓取的技巧和工具,请访问优采云(www.ucaiyun.com)获取更多信息。