掌握页面抓取测试,10个方面逐步分析!

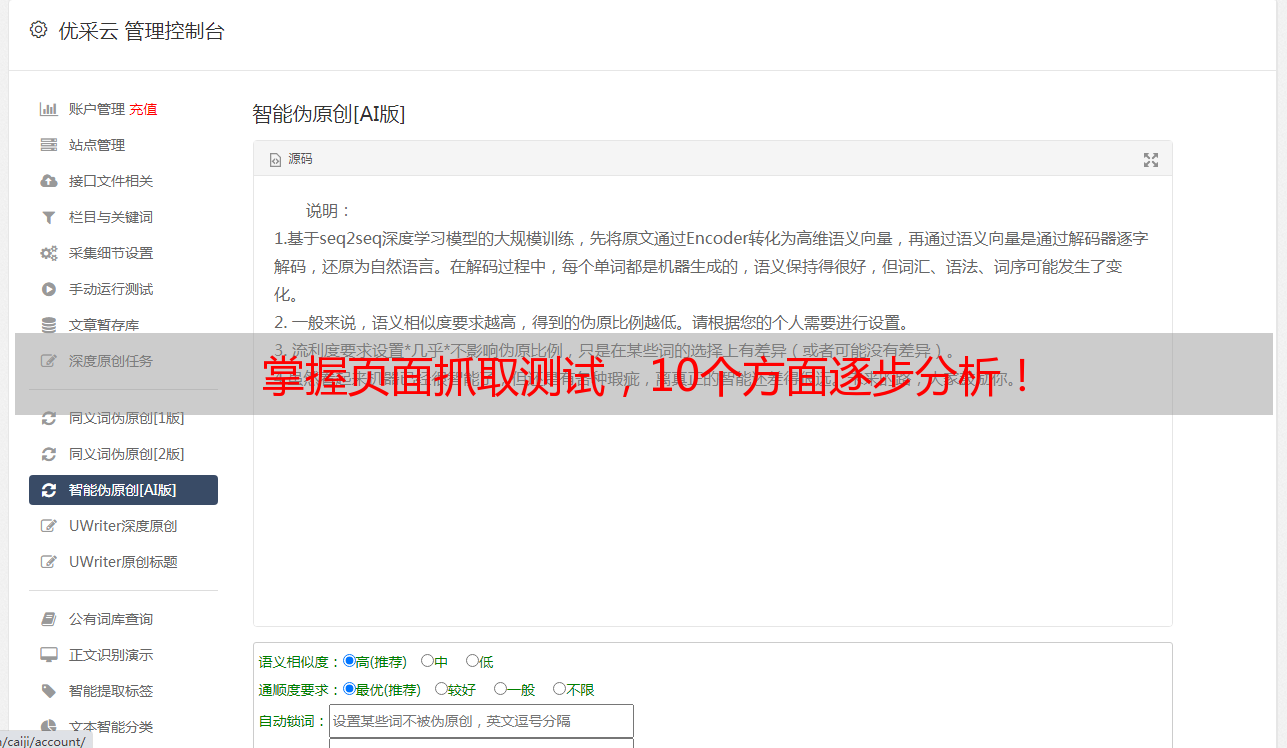

优采云 发布时间: 2023-04-13 12:38页面抓取是指通过程序获取互联网上的数据并存储到本地,是数据采集的一种方式。测试页面抓取能力是为了保证网站爬虫正常运行,提高数据采集效率。下面将从10个方面逐步分析页面抓取测试。

1.页面结构分析

在进行页面抓取测试之前,需要先对要抓取的页面进行结构分析。通过分析页面结构,可以确定需要采集的数据位置和方法。

例如,我们要从某电商网站上获取商品信息,可以通过分析商品列表页和商品详情页的HTML代码,确定需要采集的数据字段和标签,并编写相应的程序进行抓取。

2.接口测试

有些网站会提供API接口供开发者使用,通过调用接口可以获取到需要的数据。在进行页面抓取测试时,也可以先对接口进行测试。

接口测试需要注意接口地址、请求参数和返回值等细节。如果接口返回的数据格式不符合要求,需要及时调整程序代码。

3.爬虫速度测试

页面抓取需要耗费一定的时间和资源,因此爬虫速度是一个重要指标。在进行页面抓取测试时,需要对爬虫速度进行测试。

可以通过模拟多个线程并发抓取页面,测试爬虫的速度和稳定性。如果发现爬虫速度过慢或者出现异常情况,需要及时优化程序代码。

4.爬虫容错测试

在进行页面抓取时,有时会遇到一些异常情况,例如页面不存在、网络异常等。为了保证爬虫的稳定性,需要进行容错测试。

可以通过模拟不同的异常情况,测试程序的容错能力。如果发现程序无法处理某些异常情况,需要进行相应的优化和调整。

5.数据去重测试

在进行页面抓取时,有可能会出现重复数据的情况。为了保证数据的准确性和完整性,需要进行去重测试。

可以通过对已抓取的数据进行去重操作,并检查去重后数据的准确性。如果发现去重有误或者漏掉了部分数据,需要及时调整程序代码。

6.数据存储测试

在进行页面抓取后,需要将抓取到的数据存储到本地或者数据库中。为了保证数据存储的正确性和完整性,需要进行数据存储测试。

可以通过对存储后的数据进行检查和查询操作,检验数据存储是否正确。如果发现存储有误或者丢失了部分数据,需要及时调整程序代码。

7.用户代理测试

为了防止被网站屏蔽或者封禁,需要设置合适的用户代理。在进行页面抓取测试时,需要对用户代理进行测试。

可以通过模拟不同的用户代理进行抓取,并检查是否被网站屏蔽或者封禁。如果发现被屏蔽或者封禁,需要及时更换用户代理。

8.爬虫规则测试

在进行页面抓取时,需要遵循一定的爬虫规则,例如不频繁抓取同一页面、不过度占用对方服务器资源等。为了保证爬虫规则的正确性和有效性,需要进行规则测试。

可以通过模拟不同的爬虫规则进行抓取,并检查是否符合要求。如果发现违反了某些规则,需要及时调整程序代码。

9.反爬虫测试

为了防止被对方网站屏蔽或者封禁,有些网站会设置反爬虫机制。在进行页面抓取时,需要对反爬虫机制进行测试。

可以通过模拟不同的反爬虫机制进行抓取,并检查是否被网站屏蔽或者封禁。如果发现遭到了反爬虫机制的限制,需要及时优化程序代码。

10.结果分析测试

在进行页面抓取后,需要对抓取到的数据进行分析和处理。为了保证结果分析的正确性和有效性,需要进行结果分析测试。

可以通过对抓取到的数据进行统计、分类和比对等操作,检验结果分析是否正确。如果发现结果分析有误或者漏掉了部分数据,需要及时调整程序代码。

总结

页面抓取测试是保证网站爬虫正常运行的重要步骤,需要对多个方面进行逐步分析和测试。优采云提供专业的数据采集、处理和存储服务,还可进行SEO优化,更多详情请登录www.ucaiyun.com了解。