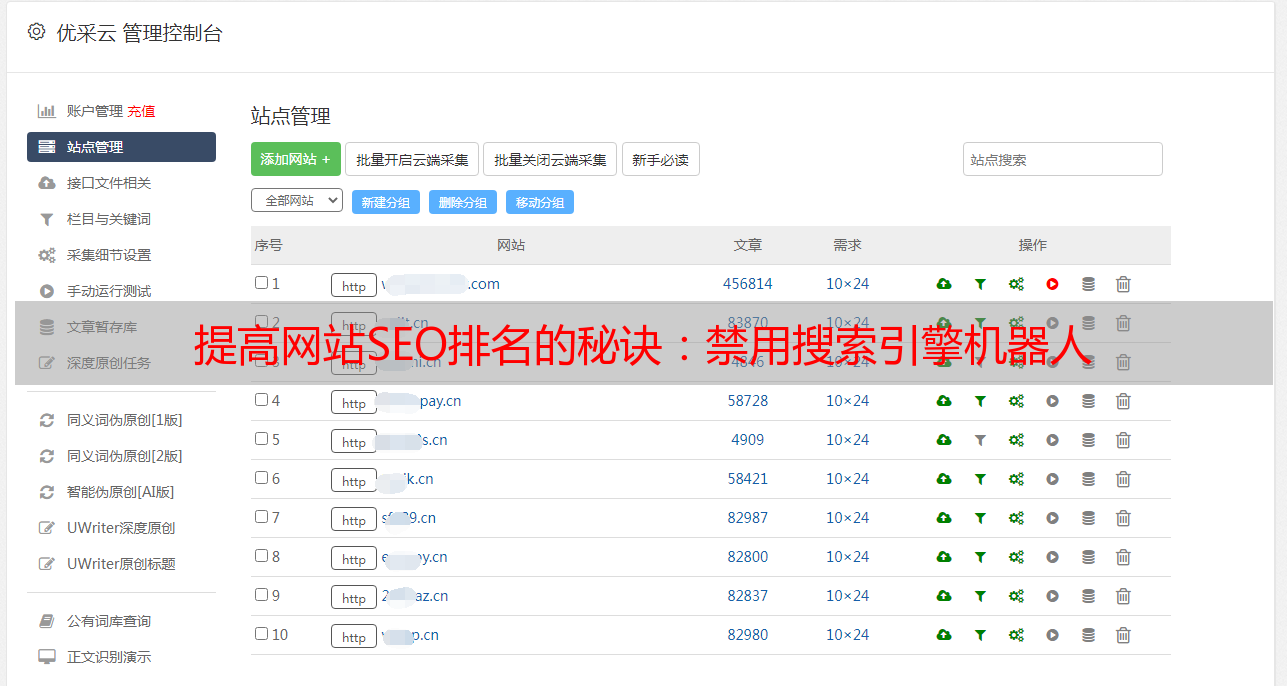

提高网站SEO排名的秘诀:禁用搜索引擎机器人

优采云 发布时间: 2023-04-12 15:49在SEO优化中,禁用搜索引擎机器人可能是一个非常有争议的话题。但是,这个决定对于你的网站是否被搜索引擎收录和排名至关重要。本篇文章将深入探讨禁用搜索引擎机器人的原因和方法。

一、什么是搜索引擎机器人?

搜索引擎机器人(也称为“爬虫”或“蜘蛛”)是一种自动程序,它们会定期访问网站并收集信息。这些信息包括网站页面的内容、关键字、链接等等。当用户使用搜索引擎输入关键词时,搜索引擎会根据这些信息来确定哪些页面最符合用户的需求。

二、为什么要禁用搜索引擎机器人?

尽管搜索引擎机器人在帮助网站被收录和排名方面起着重要作用,但在某些情况下,禁用它们可能更有益处。

1.防止敏感信息被泄露

如果你的网站包含敏感信息(如银行账号、社会安全号码等),那么你可能不希望这些信息被搜索引擎机器人收集和显示在搜索结果中。禁用搜索引擎机器人可以帮助你保护这些信息。

2.防止重复内容被惩罚

搜索引擎算法通常会惩罚重复内容。如果你的网站有大量重复内容,那么你可能会被搜索引擎降权或排名下降。禁用搜索引擎机器人可以防止这种情况发生。

3.防止爬虫占用带宽

当搜索引擎机器人访问你的网站时,它们会占用一定的带宽。如果你的网站流量很大,那么这可能会对网站性能造成影响。禁用搜索引擎机器人可以减少这种影响。

三、如何禁用搜索引擎机器人?

禁用搜索引擎机器人的方法有多种。以下是其中的两种:

1.使用robots.txt文件

robots.txt文件是一种文本文件,用于告诉搜索引擎机器人哪些页面可以访问,哪些页面不能访问。要禁用所有搜索引擎机器人,只需在robots.txt文件中添加以下代码:

User-agent:*

Disallow:/

2.使用标签

标签是一种HTML标记,可以告诉搜索引擎机器人哪些页面可以访问,哪些页面不能访问。要禁用所有搜索引擎机器人,只需在每个页面的标签中添加以下代码:

四、禁用搜索引擎机器人的注意事项

1.不要禁用所有搜索引擎机器人

虽然禁用所有搜索引擎机器人可能会解决某些问题,但这也会导致你的网站无法被收录和排名。只有在必要时才禁用搜索引擎机器人。

2.不要使用robots.txt文件来隐藏敏感信息

robots.txt文件只是告诉搜索引擎机器人哪些页面可以访问,哪些页面不能访问。它并不能防止黑客通过其他方式获取敏感信息。

3.不要将禁用搜索引擎机器人作为SEO技巧

一些SEO从业者可能会建议禁用搜索引擎机器人来提高排名。这是一种错误的做法,因为它只会让你的网站被排除在外。

五、结论

尽管禁用搜索引擎机器人在某些情况下可能很有益处,但它也可能对你的网站造成负面影响。在决定是否禁用搜索引擎机器人时,你应该仔细考虑其优缺点,并根据你的网站需求做出决定。

如果你需要更多关于SEO优化的信息,请访问优采云(www.ucaiyun.com)。作为一家专业的SEO代理公司,我们可以提供各种SEO服务,帮助你提高网站排名和流量。