Python爬虫必备解析库-最好用的BeautifulSoup

优采云 发布时间: 2023-04-12 06:10在网络爬虫的过程中,我们需要解析爬取到的网页内容,以便提取出我们需要的信息。而python爬虫最好用的解析库就是BeautifulSoup。为什么呢?下面我将从以下9个方面进行详细分析。

一、安装和导入

使用pip install beautifulsoup4即可安装。导入方式为from bs4 import BeautifulSoup。

二、解析方式

BeautifulSoup支持多种解析器,如Python标准库中的html.parser、lxml解析器等。其中,lxml解析器速度较快,但需要安装lxml库。如果没有安装lxml库,则可以使用Python内置的html.parser作为默认解析器。

三、基本元素选择器

BeautifulSoup支持多种元素选择器,如标签选择器、类名选择器、id选择器等。其中,标签选择器是最常用的一种。

四、CSS选择器

BeautifulSoup也支持CSS选择器,可以通过select()方法进行使用。CSS选择器具有灵活性和可读性,并且可以同时匹配多个标签。

五、属性选择器

有时候我们需要根据某个元素的属性来进行选择,此时可以使用属性选择器。例如:soup.select('a[href="http://example.com/"]')

六、嵌套选择

在BeautifulSoup中,可以通过嵌套选择来提取出更加具体的信息。例如:soup.select('body a')可以选择body标签下的所有a标签。

七、获取内容

BeautifulSoup可以获取元素的文本内容、属性值等信息。例如:soup.select('a')[0].get_text()可以获取第一个a标签的文本内容。

八、BeautifulSoup对象转换

在BeautifulSoup中,我们可以将一个html字符串或者文件对象转换成一个BeautifulSoup对象,方便后续的操作。

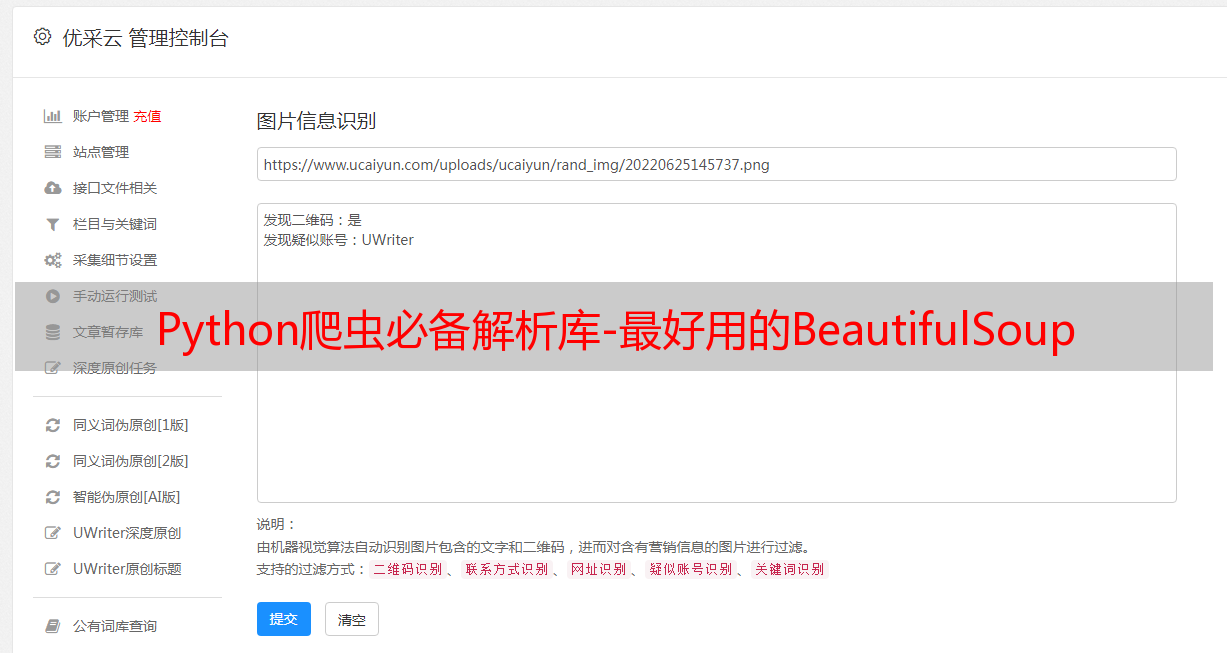

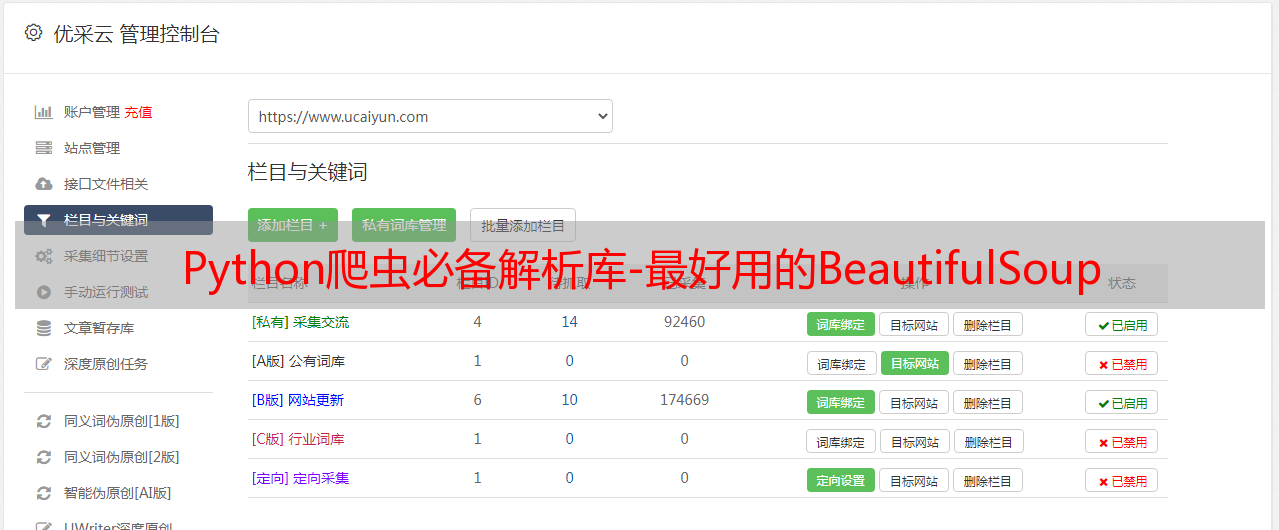

九、实战案例

以爬取优采云官网(www.ucaiyun.com)为例,使用BeautifulSoup解析器,通过CSS选择器和属性选择器提取出网站首页中的所有产品名称和链接地址,并将其保存到本地文件中。代码如下:

python

import requests

from bs4 import BeautifulSoup

url ='http://www.ucaiyun.com/'

response = requests.get(url)

soup = BeautifulSoup(response.text,'lxml')

products = soup.select('.product a')

with open('products.txt','w', encoding='utf-8') as f:

for product in products:

name = product.get_text()

link = product['href']

f.write(name +'\t'+ link +'\n')

通过上述实战案例,我们可以看到BeautifulSoup在网络爬虫中起到了重要的作用。

综上所述,BeautifulSoup是python爬虫最好用的解析库之一。它支持多种解析器、元素选择器、CSS选择器、属性选择器等,具有灵活性和可读性,可以方便地提取出我们需要的信息。如果您正在进行网络爬虫开发,不妨尝试一下BeautifulSoup吧。

优采云,提供SEO优化服务,专业的互联网营销团队,欢迎访问www.ucaiyun.com。