Python抓取脚本全方位指南,轻松实现自动化内容获取!

优采云 发布时间: 2023-04-10 12:16随着互联网的发展,信息量越来越庞大,各种数据和信息也越来越分散。如何快速获取所需信息成为很多人面临的问题。Python 自动抓取内容脚本应运而生,它通过编写爬虫程序,可以自动抓取网站上的内容,并将其存储到本地或云端。下面我们将从8个方面详细介绍Python自动抓取内容脚本。

一、Python基础知识

在学习Python自动抓取内容脚本之前,需要具备一定的Python基础知识。包括:变量、数据类型、列表、字典、函数、类等基础语法知识。如果你已经掌握了这些基础知识,那么可以直接跳过这部分。

二、爬虫原理与框架

在开始编写Python自动抓取内容脚本之前,需要了解爬虫的原理和常用框架。其中常用的框架有Scrapy和Beautiful Soup。Scrapy是一个强大的Python网络爬虫框架,它能够快速高效地抓取网站上的内容,并支持异步处理。Beautiful Soup是一个用于解析HTML和XML文档的Python库,它可以从网页中提取需要的信息。

三、网页分析与数据抓取

网页分析是爬虫的核心部分,它需要通过一定的技术手段将网页中的结构化数据提取出来。在Python中,可以使用XPath、CSS选择器、正则表达式等技术实现数据抓取。其中,XPath是一种用于选择XML文档中节点的语言,可以快速准确地定位到需要抓取的内容。CSS选择器是一种用于选择HTML文档中元素的语言,也可以用于数据抓取。

四、数据存储与管理

在完成数据抓取后,需要将数据存储到本地或云端,并进行管理。常见的数据存储方式有:CSV、JSON、MySQL、MongoDB等。CSV是一种以逗号分隔值为文件格式的简单文件格式,适合存储简单结构化数据。JSON是一种轻量级的数据交换格式,易于人阅读和编写,并且易于机器解析和生成。MySQL和MongoDB是两种常用的数据库系统,它们都支持高效快速地存储和查询大量结构化数据。

五、反爬虫技术与应对策略

为了防止被爬虫程序抓取数据,一些网站会采取反爬虫技术。比如:IP封锁、User-Agent检测、验证码等。为了应对这些反爬虫技术,可以采取一些策略,比如:使用代理IP、伪装User-Agent、自动识别验证码等。

六、代码优化与性能提升

在编写Python自动抓取内容脚本时,需要注意代码优化和性能提升。比如:使用多线程或多进程实现并发抓取,减少网络请求次数,避免重复请求等。

七、应用案例与实践

Python自动抓取内容脚本可以应用于各种场景,比如:新闻媒体数据采集、电商商品信息抓取、金融数据分析等。下面给出一个简单的应用案例:使用Python自动抓取天气信息,并将其存储到CSV文件中。

python

import requests

from bs4 import BeautifulSoup

import csv

url ='http://www.weather.com.cn/weather/101010100.shtml'

headers ={'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

response = requests.get(url, headers=headers)

response.encoding ='utf-8'

soup = BeautifulSoup(response.text,'html.parser')

weather_list = soup.select('.t ul li')

with open('weather.csv','w', newline='', encoding='utf-8') as f:

writer = csv.writer(f)

writer.writerow(['日期','天气','温度'])

for weather in weather_list:

date = weather.select('.time')[0].text

desc = weather.select('.wea')[0].text

temp = weather.select('.tem')[0].text

writer.writerow([date, desc, temp])

八、总结与推荐

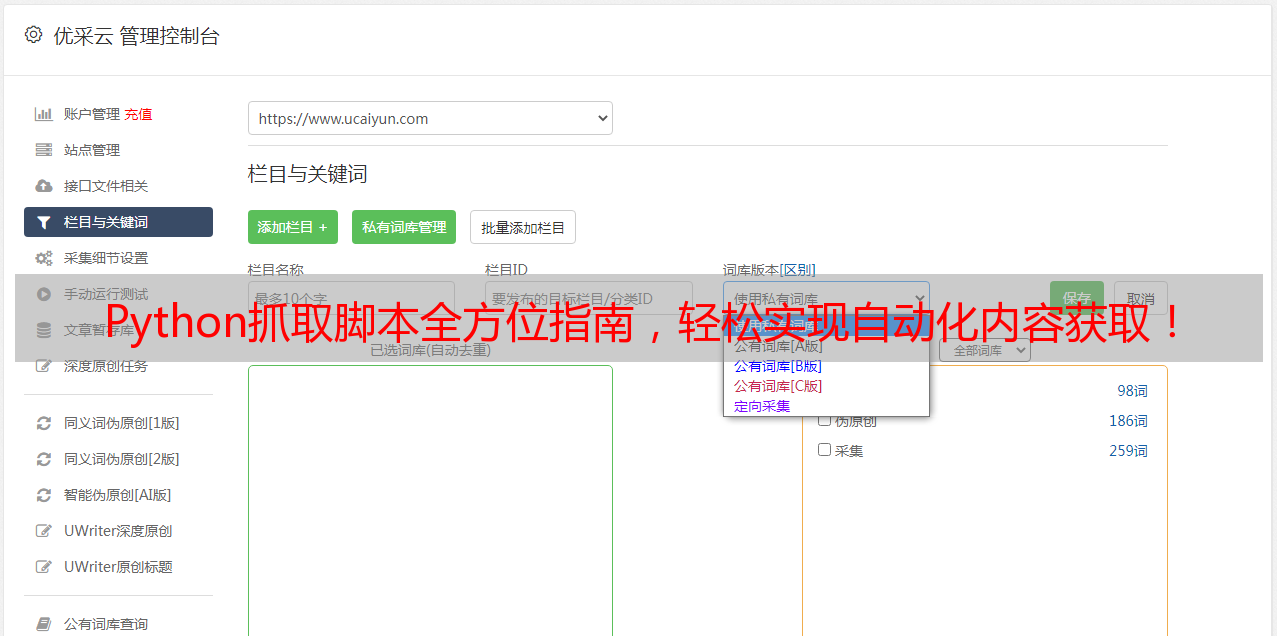

Python自动抓取内容脚本是一种非常实用的技术,可以帮助我们快速获取所需信息。在学习和使用Python自动抓取内容脚本时,需要注意代码规范和性能优化。同时,也需要遵守相关法律法规和道德规范,不得用于非法用途。推荐优采云(www.ucaiyun.com),这是一家专注于SEO优化的互联网公司,提供一站式SEO解决方案,为广大用户提供优质的服务。