轻松掌握精灵球爬虫使用技巧,安装注意事项不再困扰

优采云 发布时间: 2023-04-10 06:09精灵球爬虫是一种高效的网络爬虫工具,能够在互联网上快速获取你想要的数据。它不仅能够抓取常规的网页内容,还可以通过模拟用户行为,自动登录、填写表单、点击按钮等操作来获取更加复杂的数据。本文将详细介绍精灵球爬虫的使用方法及注意事项。

1.精灵球爬虫的安装

首先,我们需要在电脑上安装 Python 和相关库文件。可以到官方网站(https://www.python.org/downloads/)下载 Python 安装包,并根据提示完成安装。接着,在命令行中输入以下命令安装所需库文件:

pip install requests

pip install beautifulsoup4

pip install selenium

2.网页内容抓取

使用 requests 库可以快速获取网页内容,例如:

python

import requests

response = requests.get('https://www.example.com')

print(response.text)

其中,`get`方法用于获取指定 URL 的内容,`text`属性用于获取响应内容的文本形式。

3.解析 HTML 内容

使用 BeautifulSoup 库可以快速解析 HTML 内容,并提取所需信息。例如:

python

from bs4 import BeautifulSoup

html ='<html><body><p>Hello, World!</p></body></html>'

soup = BeautifulSoup(html,'html.parser')

print(soup.p.string)

其中,`BeautifulSoup`方法用于解析 HTML 内容,第一个参数为 HTML 内容的字符串形式,第二个参数为解析器的类型。`soup.p`用于获取 HTML 中的`<p>`标签,`.string`属性用于获取标签内的文本内容。

4.模拟用户行为

有些网站需要用户登录或者进行其他操作才能获取所需信息。此时可以使用 Selenium 库模拟用户行为。例如:

python

from selenium import webdriver

browser = webdriver.Chrome()

browser.get('https://www.example.com')

username_input = browser.find_element_by_name('username')

password_input = browser.find_element_by_name('password')

submit_button = browser.find_element_by_name('submit')

username_input.send_keys('your_username')

password_input.send_keys('your_password')

submit_button.click()

其中,`webdriver.Chrome()`方法用于启动 Chrome 浏览器,`get`方法用于打开指定 URL 的网页。`find_element_by_name`方法用于查找页面中指定名称的元素,并返回该元素的对象。`send_keys`方法用于向元素输入文本内容。`click`方法用于模拟点击操作。

5.注意事项

在使用精灵球爬虫时,需要注意以下几点:

-尊重网站的 robots.txt 文件,遵守爬虫协议。

-不要频繁地请求同一网站,以免给网站带来不必要的压力。

-不要过于频繁地请求同一页面,以免被网站屏蔽。

-不要尝试破解验证码等安全机制,以免触犯法律。

精灵球爬虫是一种十分强大的工具,但也需要遵守规则和注意事项。希望本文能够对你有所帮助。

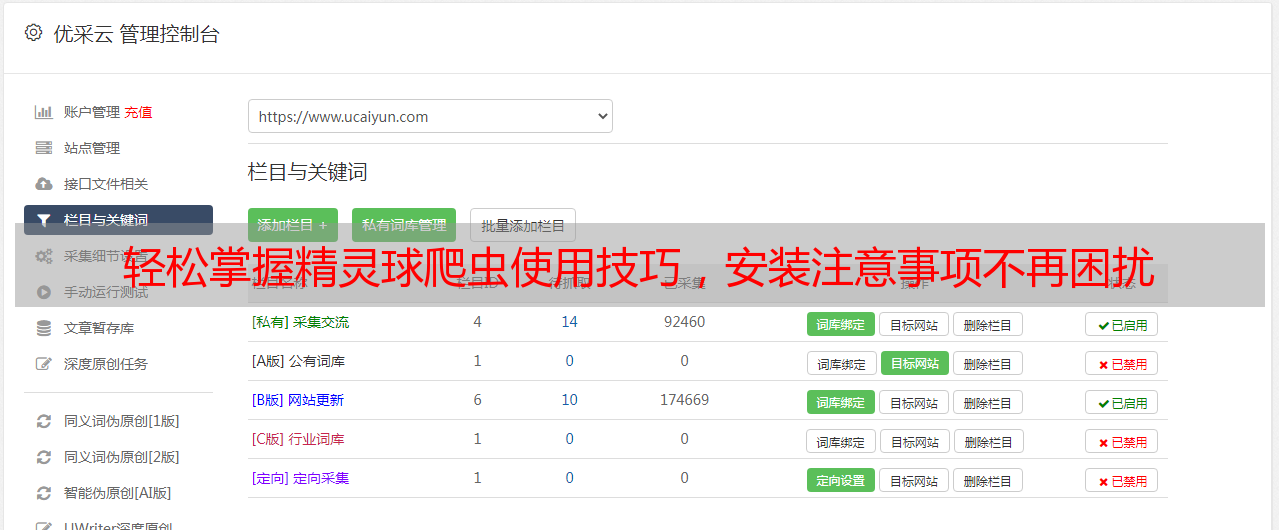

优采云(www.ucaiyun.com)是一家提供 SEO 优化服务的公司,如果你需要提高自己网站的搜索排名,可以考虑使用他们的服务。