Java编写高效网页爬虫程序,基础知识与实战技巧

优采云 发布时间: 2023-04-10 02:10近年来,随着互联网的高速发展,人们对于信息获取的需求越来越大。而在众多信息获取方式中,网页爬虫已经成为了一种非常流行的方式。本文将为您介绍如何使用 Java 编写高效的网页爬虫程序,并帮助您打造一个独具优势、让您事半功倍的信息采集利器。

第一部分:爬虫基础知识

在进行 Java 网页爬虫开发之前,我们需要了解一些基础知识。首先,什么是网页爬虫?简单来说,网页爬虫就是一种自动化程序,能够模拟浏览器行为,从互联网上抓取数据并进行处理。其次,我们需要了解 HTTP 协议和 HTML 语言的基础知识。HTTP 协议是 Web 服务器和客户端进行通信的规则,而 HTML 是 Web 页面的标准语言。

第二部分:Java 爬虫框架介绍

Java 爬虫框架是指用 Java 编写的一些用于网页爬取和数据处理的组件和工具集合。这些框架大大简化了网页爬虫的开发和维护,提高了爬虫程序的效率和稳定性。目前,比较流行的 Java 爬虫框架有 Jsoup、WebMagic、HttpClient 等。

第三部分:爬虫程序设计思路

在进行 Java 网页爬虫开发之前,我们需要确定好程序的设计思路。这包括确定要爬取的网站、确定要爬取的数据类型、确定数据存储方式等。在确定了这些基本信息后,我们就可以开始编写 Java 爬虫程序了。

第四部分:Java 爬虫实战操作1——抓取静态网页

在实际开发中,我们需要从网页中获取数据,并进行处理。首先,我们来看如何抓取静态网页。静态网页是指页面内容不会变化的页面,通常使用 HTTP GET 请求获取页面内容。在 Java 中,我们可以使用 HttpClient 或 URLConnection 类进行请求,并使用 Jsoup 进行解析。

第五部分:Java 爬虫实战操作2——抓取动态网页

与静态网页不同,动态网页需要通过 JavaScript 或 Ajax 技术才能加载出完整的页面内容。在 Java 中,我们可以使用 Selenium WebDriver 进行模拟浏览器操作,并使用 Jsoup 进行解析。

第六部分:Java 爬虫实战操作3——数据存储

在完成网页数据的抓取后,我们还需要将数据进行存储。常见的数据存储方式有文本文件、数据库、Excel 等。在 Java 中,我们可以使用 File、JDBC、Apache POI 等工具进行数据存储。

第七部分:Java 爬虫反爬技巧

在进行网页爬取时,我们需要注意反爬机制。为了防止爬虫程序对网站造成过大的访问压力,很多网站都设置了反爬机制。常见的反爬机制有验证码、IP 封禁、请求频率限制等。在 Java 爬虫开发中,我们可以使用代理 IP、随机 User-Agent、延时请求等技巧来规避反爬机制。

第八部分:Java 爬虫优化技巧

为了提高网页爬取效率和稳定性,我们还需要进行一系列的优化工作。其中包括多线程并发处理、使用缓存技术、合理设置请求头等。

第九部分:Java 爬虫应用场景

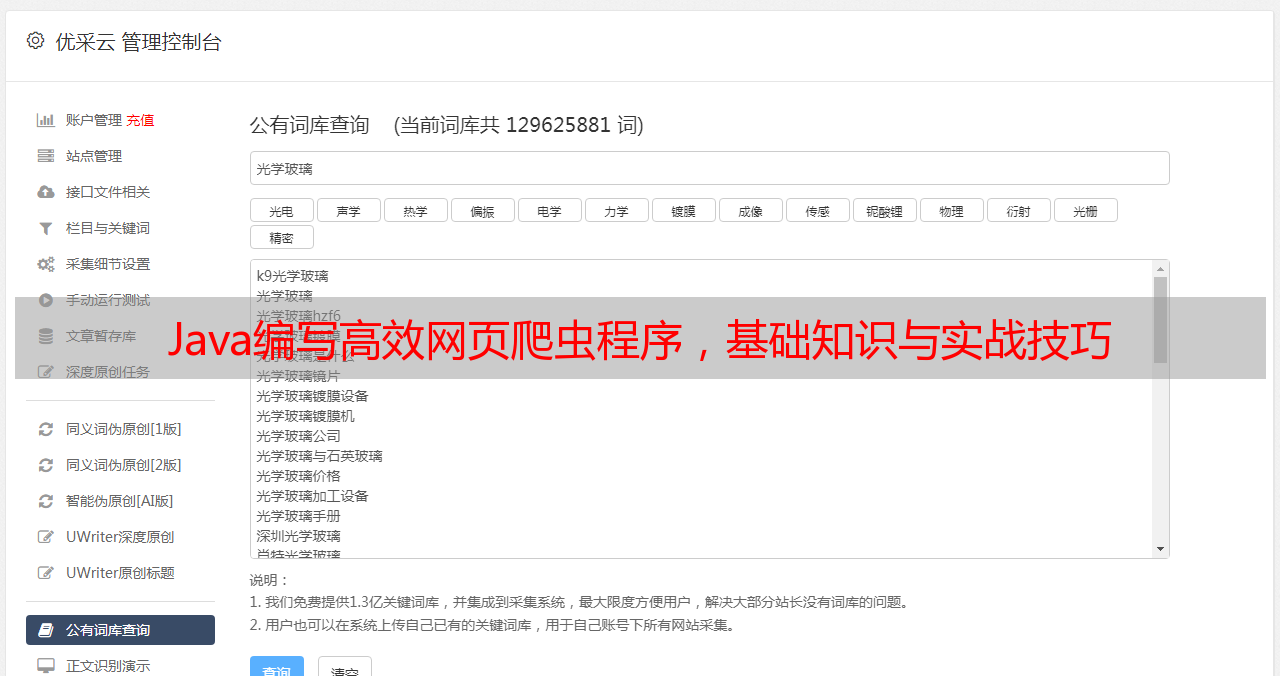

最后,让我们来看一下 Java 网页爬虫的应用场景。Java 网页爬虫可以广泛应用于各种领域,如舆情监测、商品价格比较、搜索引擎优化(SEO)等。在 SEO 优化方面,我们可以使用 Java 爬虫程序来获取竞争对手的关键词排名、网站访问量等信息,以便更好地进行 SEO 优化。

综上所述,Java 网页爬虫是一种非常实用的信息采集利器。通过本文的介绍,相信大家已经掌握了 Java 网页爬虫的基础知识和开发技巧。如果您需要更多相关信息,可以关注优采云官网(www.ucaiyun.com),了解更多关于 Java 网页爬虫的实战案例和技术分享。