揭秘爬虫背后的秘密:js源代码全揭露!

优采云 发布时间: 2023-04-07 16:25在网络世界里,信息获取和分析是非常重要的,而爬虫技术则是信息获取的重要手段之一。但你知道吗?爬虫源代码,竟然都是js!今天就让我们来一探究竟。

一、什么是爬虫?

想必大家对“爬虫”这个词并不陌生,简单来说,爬虫就是一种自动化程序,能够模拟人类在网络上的行为,按照一定的规则抓取网页上的数据,并存储下来。通过对这些数据进行分析和处理,我们可以得到所需的信息。

二、为什么爬虫源代码都是js?

既然爬虫是一种自动化程序,那么它的实现方式无非就是使用某种编程语言编写。而在这些编程语言中,为什么js成为了爬虫源代码的主角呢?

1. js本身易学易用

与其他编程语言相比,js语法简洁明了、易于理解和学习,所以即使没有编程基础的人也可以快速上手。

2. js适合处理异步请求

在网页中,很多数据需要通过异步请求才能获取到。而js作为前端开发的主要语言,天生适合处理异步请求,因此在爬虫中也得到了广泛应用。

3. js可以直接操作DOM

在网页中,数据往往是以HTML文档的形式呈现的。而js可以直接操作DOM(文档对象模型),可以轻松地获取和处理HTML页面上的数据。

三、爬虫实现方式有哪些?

实现一个爬虫程序,一般需要以下几个步骤:

1.发送HTTP请求获取网页内容;

2.解析网页内容,提取所需信息;

3.存储所需信息。

而根据不同的实现方式,我们可以将爬虫分为以下几类:

1.基于HTTP库的爬虫

这种爬虫一般使用Python或Java等编程语言,通过HTTP库发送请求获取网页内容,并使用正则表达式或BeautifulSoup等工具进行解析。

2.基于浏览器引擎的爬虫

这种爬虫一般使用Selenium或PhantomJS等工具模拟浏览器行为,获取完整的渲染后的网页内容,并使用js解析和提取所需信息。

四、如何防止被反爬?

在使用爬虫时,往往会遇到反爬机制。为了避免被反爬,我们可以采取以下措施:

1.使用代理IP

通过使用代理IP,可以让我们的请求看起来像是来自不同的IP地址,从而降低被封杀的风险。

2.限制请求频率

在爬取数据时,我们可以限制请求频率,避免过于频繁地发送请求,从而避免被封杀。

3.使用随机User-Agent

在发送HTTP请求时,我们可以使用随机的User-Agent,避免使用相同的User-Agent被识别为爬虫。

五、爬虫的应用场景有哪些?

爬虫技术在很多领域都得到了广泛应用:

1.搜索引擎

搜索引擎需要通过爬虫程序抓取互联网上的页面,并进行分析和索引,以提供更好的搜索结果。

2.数据挖掘和分析

通过爬虫获取大量数据,并对这些数据进行分析和挖掘,可以帮助企业做出更好的商业决策。

3.网络安全

通过爬虫程序抓取网络上的漏洞信息,并对其进行分析和处理,可以帮助企业加强网络安全防范。

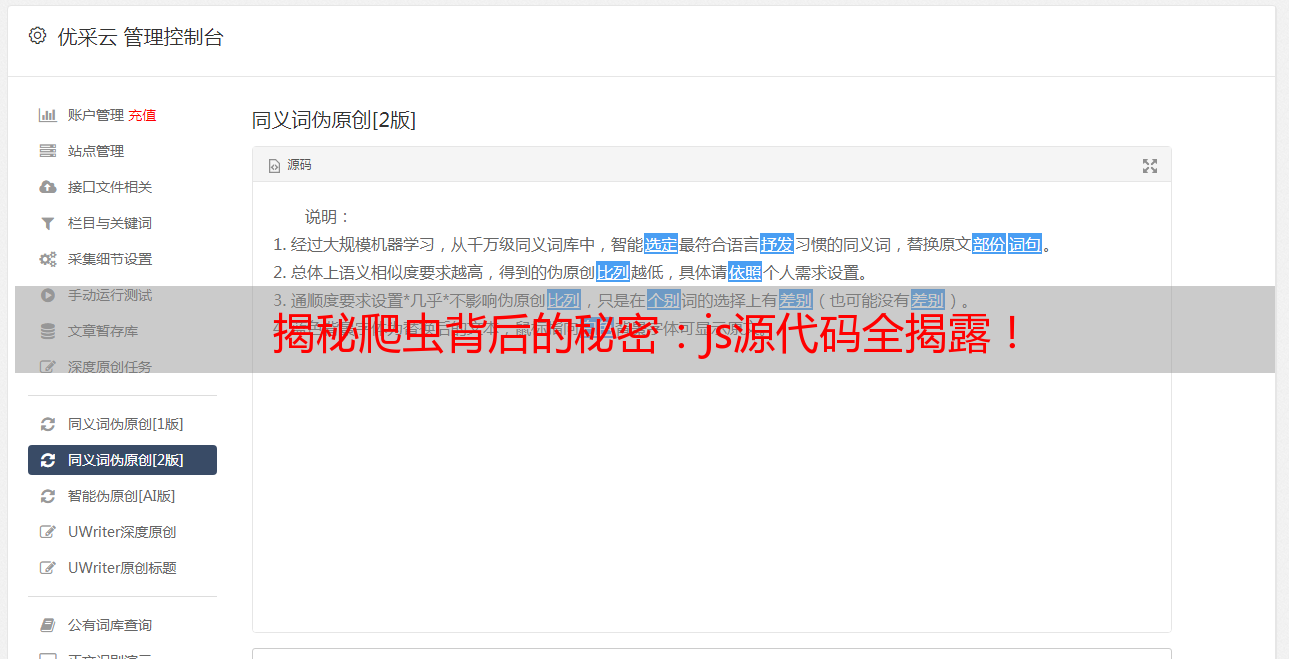

六、优采云能够提供哪些帮助?

作为一家专注于SEO优化的企业,优采云可以为爬虫程序提供以下帮助:

1.提供稳定的代理IP

通过优采云提供的代理IP,可以避免被封杀的风险,保证爬虫程序的稳定性。

2.提供SEO优化服务

通过优采云提供的SEO优化服务,可以帮助企业在搜索引擎中获得更好的排名和曝光度。

七、结语

爬虫技术在今天的信息时代中得到了广泛应用,而js作为一种简单易用、适合处理异步请求、可以直接操作DOM的编程语言,则成为了实现爬虫程序的重要工具。在使用爬虫技术时,我们需要注意防范反爬机制,并在必要时寻求专业服务商的帮助。