ThinkPHP实现网站自动采集的技巧与方法

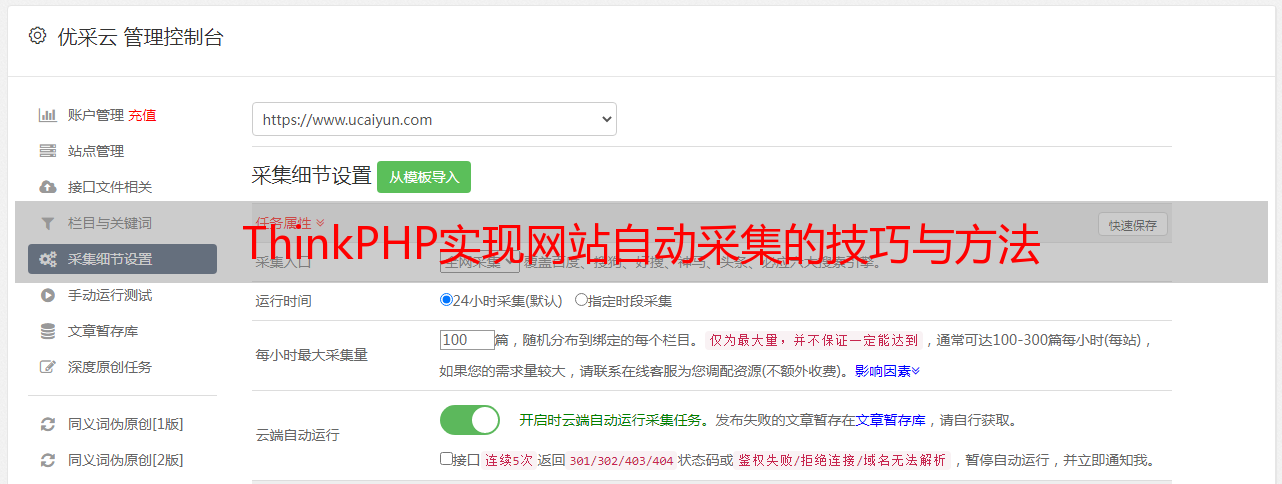

优采云 发布时间: 2023-04-07 13:17随着互联网的发展,网站已经成为了人们获取信息和交流的主要渠道之一。但是,如果你是一个拥有大量内容的网站管理员,每天都需要手动添加新的内容,那么这将会是一项非常耗时且繁琐的工作。因此,采用自动化采集技术将会是一个不错的选择。本文将会介绍如何使用 ThinkPHP 实现自动化采集,并帮助你让你的网站内容自动更新。

一、ThinkPHP 网站自动采集基础

ThinkPHP 是一个基于 PHP 的开源 Web 应用框架,它可以帮助我们快速地开发高质量、可维护的 Web 应用程序。在本节中,我们将会简单介绍 ThinkPHP 的基础知识。

1. ThinkPHP 控制器

控制器是 MVC 模式中负责处理用户请求并返回响应结果的部分。在 ThinkPHP 中,控制器通常存放在 application 目录下,并以类文件的形式存在。例如,我们可以创建一个名为 Index 的控制器:

php

namespace app\index\controller;

class Index

{

public function index()

{

return 'Hello, world!';

}

}

上述代码定义了一个名为 Index 的控制器,并在其中定义了一个名为 index 的方法,该方法将会在用户访问/index/index 路径时被调用,返回一个字符串"Hello, world!"。

2. ThinkPHP 模型

模型是 MVC 模式中负责处理业务逻辑和数据存取的部分。在 ThinkPHP 中,模型通常存放在 application 目录下的 model 子目录中。例如,我们可以创建一个名为 Article 的模型:

php

namespace app\index\model;

use think\Model;

class Article extends Model

{

protected $table ='articles';

}

上述代码定义了一个名为 Article 的模型,并继承了 ThinkPHP 自带的 Model 类。我们还指定了该模型对应的数据库表名为 articles。

3. ThinkPHP 视图

视图是 MVC 模式中负责呈现数据和界面的部分。在 ThinkPHP 中,视图通常存放在 application 目录下的 view 子目录中,并以文件的形式存在。例如,我们可以创建一个名为 index.html 的视图文件:

html

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title>{$title}</title>

</head>

<body>

<h1>{$title}</h1>

<ul>

{volist name="articles" id="article"}

<li><a href="{$article.url}">{$article.title}</a></li>

{/volist}

</ul>

</body>

</html>

上述代码定义了一个简单的 HTML 页面,并使用了 ThinkPHP 的模板引擎语法。我们可以在控制器中通过 assign 方法将变量传递给视图:

php

namespace app\index\controller;

use app\index\model\Article;

use think\Controller;

class Index extends Controller

{

public function index()

{

$articles = Article::all();

$this->assign('title','文章列表');

$this->assign('articles',$articles);

return $this->fetch();

}

}

上述代码定义了一个名为 index 的方法,并在其中查询了所有文章,并将结果传递给了视图。

二、ThinkPHP 网站自动采集实现

现在,我们已经了解了 ThinkPHP 的基础知识,接下来将会介绍如何使用 ThinkPHP 实现网站自动采集。

1.安装扩展

ThinkPHP 提供了一个名为 crawler 的扩展,可以帮助我们实现网站自动采集的功能。我们可以使用 Composer 来安装该扩展:

composer require topthink/think-crawler

2.创建任务

我们需要创建一个任务,用于定时执行网站自动采集的操作。在 ThinkPHP 中,我们可以使用命令行工具来创建任务:

php think make:command Crawler

上述命令将会在 application/command 目录下创建一个名为 Crawler 的命令行任务。我们可以在该任务中编写自动采集的代码。例如,以下代码实现了对博客园首页进行采集:

php

namespace app\command;

use think\console\Command;

use think\console\Input;

use think\console\Output;

use QL\QueryList;

class Crawler extends Command

{

protected function configure()

{

$this->setName('crawler')->setDescription('网站自动采集');

}

protected function execute(Input $input, Output $output)

{

$url ='https://www.cnblogs.com/';

$rules =[

'title'=>['.post-title-link','text'],

'url'=>['.post-title-link','href'],

'date'=>['.post-meta','text']

];

$data = QueryList::get($url)->rules($rules)->queryData();

foreach ($data as $item){

//保存到数据库中

}

$output->writeln('采集完成');

}

}

上述代码定义了一个名为 Crawler 的命令行任务,并在其中使用 QueryList 库对博客园首页进行了采集,将结果保存到了数据库中。

3.配置定时任务

我们需要配置一个定时任务,用于定时执行网站自动采集的任务。在 ThinkPHP 中,我们可以使用命令行工具来创建定时任务:

php think make:cron Crawler

上述命令将会在 application/cron 目录下创建一个名为 Crawler 的定时任务。我们可以在该任务中调用之前创建的命令行任务,并设置执行时间。例如,以下代码将会每天凌晨 1 点执行一次自动采集的操作:

php

namespace app\cron;

use think\console\Command;

use think\console\Input;

use think\console\Output;

class Crawler extends Command

{

protected function configure()

{

$this->setName('crawler')->setDescription('网站自动采集');

}

protected function execute(Input $input, Output $output)

{

$command ='php '. ROOT_PATH .'think crawler';

shell_exec($command);

$output->writeln('采集完成');

}

protected function isActive()

{

return true;

}

protected function getSchedule()

{

return '0 1 ***';

}

}

上述代码定义了一个名为 Crawler 的定时任务,并在其中调用了之前创建的命令行任务。我们还设置了该任务每天凌晨 1 点执行一次。

三、ThinkPHP 网站自动采集总结

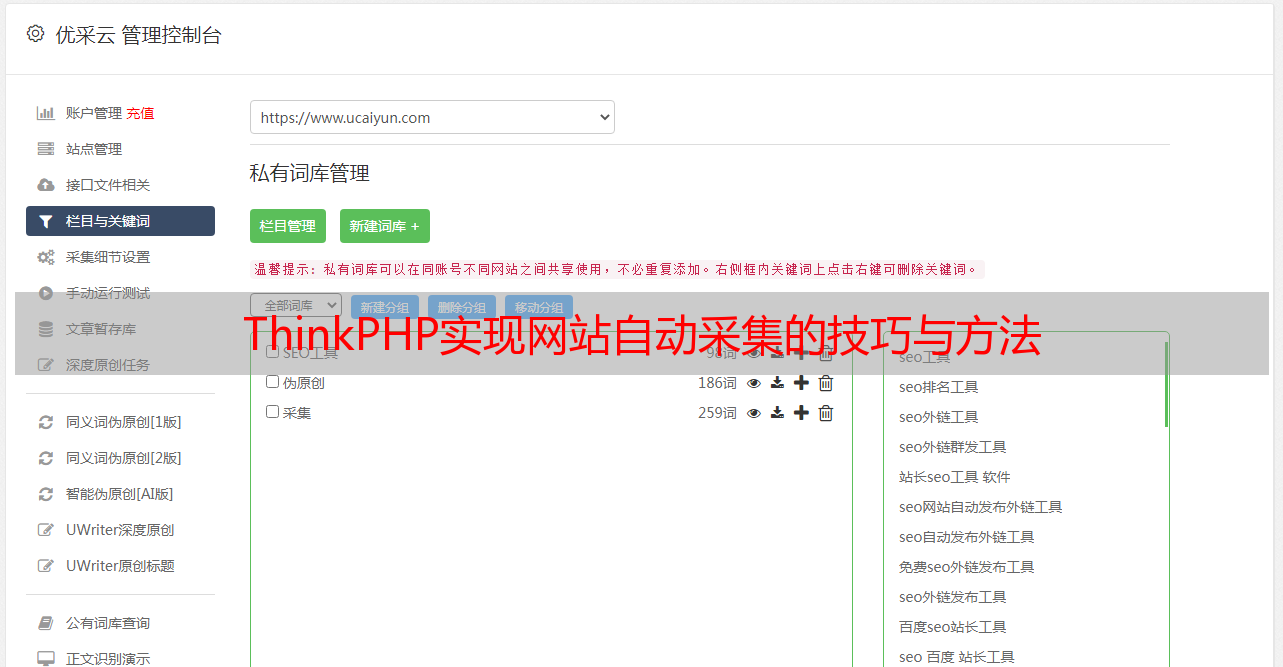

通过本文的介绍,我们已经了解了如何使用 ThinkPHP 实现网站自动采集的功能。在实际应用中,我们还可以通过一些技巧来提高采集效率和稳定性,例如使用代理 IP、设置 User-Agent 等。希望本文对你有所帮助,如果你想进一步了解如何优化网站内容,请访问优采云官网:www.ucaiyun.com。