Scrapy免费插件助你轻松构建、部署爬虫

优采云 发布时间: 2023-04-07 05:08在当前大数据时代,数据获取已成为各行业竞争的重要环节。如果你需要获取特定网站的数据,那么爬虫就是一个非常好的选择。但是对于大多数人来说,编写一个可靠、高效的爬虫程序并不容易。因此,今天我们将向大家介绍一款免费爬虫插件——Scrapy,它可以帮助你轻松地构建和部署爬虫。

1. Scrapy简介

Scrapy是一个快速、高效、可扩展的Python Web爬虫框架。它最初由Pablo Hoffman在2008年创建,并且在GitHub上开源发布。Scrapy提供了一种简单而强大的方式来从网站上抓取结构化数据,并可以自动地将这些数据存储到本地或者数据库中。

2. Scrapy的安装

在使用Scrapy之前,我们需要先安装它。Scrapy支持Windows、Linux和Mac OS X等操作系统,并且可以通过pip来进行安装。

在命令行中输入以下命令:

pip install scrapy

如果你想在Python 3中使用Scrapy,则应该执行以下命令:

pip3 install scrapy

3.创建Scrapy项目

在安装Scrapy之后,我们就可以创建一个新的Scrapy项目。在命令行中执行以下命令:

scrapy startproject projectname

其中,projectname是你想要创建的项目名称。执行该命令后,Scrapy将会创建一个名为projectname的文件夹,并且在该文件夹下创建一些默认文件和目录。

4.编写爬虫

接下来,我们需要编写一个爬虫来抓取网站数据。在Scrapy中,每个爬虫都是一个独立的Python类,该类定义了如何访问网站、如何解析网页并提取数据等操作。

例如,以下是一个简单的爬虫代码示例:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =[

'http://www.example.com/page1.html',

'http://www.example.com/page2.html',

'http://www.example.com/page3.html',

]

def parse(self, response):

#解析网页并提取数据

pass

在以上代码中,我们定义了一个名为MySpider的爬虫类,并指定了要抓取的网站URL列表。parse方法则用于解析网页并提取数据。

5.运行爬虫

完成编写爬虫之后,我们就可以运行它来抓取网站数据了。在命令行中执行以下命令:

scrapy crawl myspider

其中,myspider是我们在爬虫类中定义的名称。执行该命令后,Scrapy将会自动地访问我们指定的URL列表,并抓取网站数据。

6. Scrapy的优势

相比于其他爬虫工具,Scrapy具有以下几个优势:

1.高效:Scrapy使用Twisted异步网络框架,可以同时处理多个请求和响应,从而实现高效率的数据抓取。

2.可扩展:Scrapy提供了许多插件和扩展机制,可以轻松地扩展其功能和性能。

3.易于使用:Scrapy提供了简单易用的API和文档,使得开发人员可以轻松地编写和调试爬虫程序。

7. Scrapy的应用场景

Scrapy可以应用于各种数据获取场景,如:

1.搜索引擎数据抓取:可以使用Scrapy来抓取Google、Bing等搜索引擎上的数据。

2.电商数据抓取:可以使用Scrapy来抓取Amazon、eBay等电商网站上的商品信息。

3.新闻数据抓取:可以使用Scrapy来抓取各大新闻网站上的新闻内容。

8. Scrapy的局限性

虽然Scrapy具有很多优点,但是它也存在一些局限性:

1.无法处理JavaScript:Scrapy不能处理动态加载的JavaScript内容,因此无法抓取使用JavaScript动态生成的网页。

2.网站反爬虫机制:一些网站会采取反爬虫机制来阻止爬虫程序,这可能会使得Scrapy无法正常工作。

9.总结

通过本文的介绍,相信大家已经了解了Scrapy这款免费爬虫插件的基本使用方法和优势。如果你需要从网站上获取结构化数据,那么Scrapy是一个非常好的选择。同时,我们也应该注意到Scrapy存在一些局限性,需要在实际使用中加以注意。

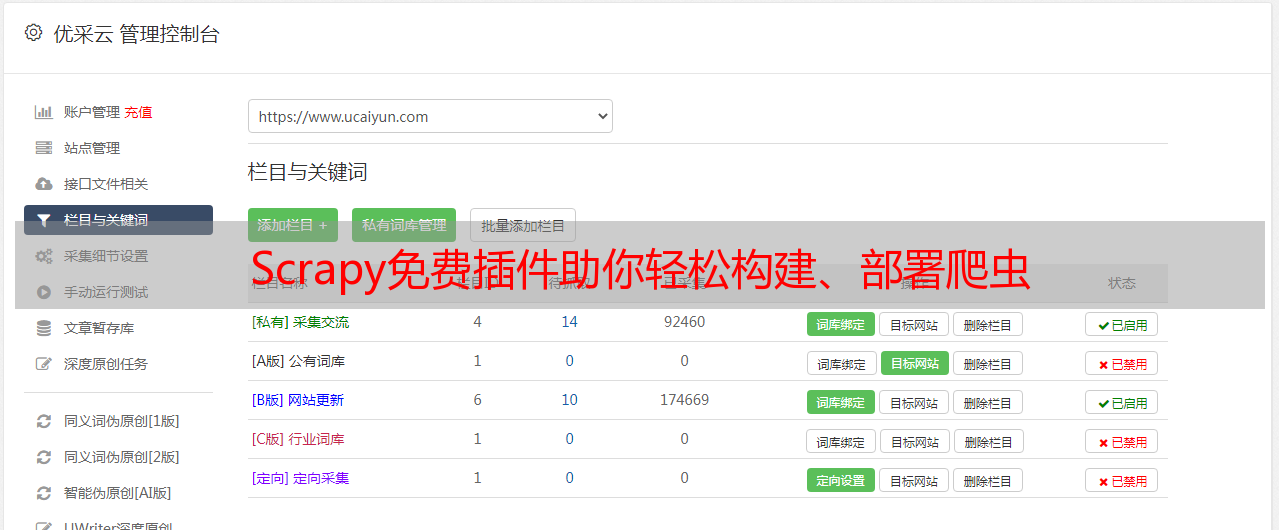

最后推荐一个专业的SEO优化工具——优采云(www.ucaiyun.com),它可以帮助你更好地进行网站SEO优化,提高搜索引擎排名。