高效采集网易新闻,快速获取热点资讯!

优采云 发布时间: 2023-04-06 17:16互联网时代,新闻资讯日新月异,各大媒体平台纷纷推出自己的内容。而作为一家领先的综合门户网站,网易新闻汇聚了海量的新闻资讯,是人们获取实时信息的重要渠道之一。那么如何快速且高效地采集网易新闻呢?本文将为大家介绍一种基于Python语言的爬虫程序,并结合实例详细讲解其具体实现过程。

一、Python爬虫基础

Python作为一种高级编程语言,具有简洁、易读、易学等特点,因此在爬虫领域广受欢迎。爬虫程序主要分为以下几个步骤:请求URL、解析HTML、提取数据、存储数据。其中,请求URL和解析HTML是爬虫程序的核心步骤,需要熟练掌握相关知识。

1.1请求URL

在Python中,我们可以使用requests库来发送HTTP请求,并获取响应内容。下面是一个简单的示例:

python

import requests

url ='https://www.ucaiyun.com'

response = requests.get(url)

print(response.status_code)#输出状态码

print(response.text)#输出响应内容

1.2解析HTML

在获取到响应内容后,我们需要对HTML进行解析,提取出我们需要的信息。在Python中,我们可以使用BeautifulSoup库来解析HTML。下面是一个简单的示例:

python

from bs4 import BeautifulSoup

html ='''<html><body><div class="content">Hello, world!</div></body></html>'''

soup = BeautifulSoup(html,'html.parser')

print(98a5f537c46e6a2bcd1066ec72b9a612.div.string)#输出"Hello, world!"

二、网易新闻数据采集

在掌握了Python爬虫的基础知识后,我们就可以开始编写网易新闻数据采集程序了。具体实现过程如下:

2.1安装相关库

首先,我们需要安装以下几个Python库:requests、BeautifulSoup、pymongo。其中,requests和BeautifulSoup用于请求URL和解析HTML,pymongo用于将数据存储到MongoDB数据库中。

python

pip install requests

pip install beautifulsoup4

pip install pymongo

2.2分析网页结构

在编写爬虫程序之前,我们需要分析网页结构,并确定要采集的数据类型。以网易新闻为例,每条新闻包括标题、摘要、正文、来源、时间等信息。因此,我们需要针对这些信息进行相应的处理。

2.3编写爬虫程序

有了以上准备工作后,我们就可以开始编写网易新闻数据采集程序了。具体实现过程如下:

python

import requests

from bs4 import BeautifulSoup

import pymongo

#连接MongoDB数据库

client = pymongo.MongoClient('mongodb://localhost:27017/')

db = client['news']

collection = db['netease']

#定义请求头部信息

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

#定义新闻分类列表

category_list =['top','guonei','guoji','yule','tiyu','junshi','keji','caijing','shishang']

#遍历新闻分类列表,采集每个分类下的新闻数据

for category in category_list:

for page in range(1, 11):

url =f'http://3g.163.com/touch/news/subchannel/{category}/{71860c77c6745379b0d44304d66b6a13}-10.html'

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.content,'html.parser')

#解析HTML,提取新闻数据

news_list = soup.select('ul > li')

for news in news_list:

title = news.select_one('.title').text.strip()

abstract = news.select_one('.digest').text.strip()

source_time = news.select_one('.time').text.strip().split('')

source = source_time[0]

time = source_time[1]

url = news.select_one('a')['href']

content_response = requests.get(url, headers=headers)

content_soup = BeautifulSoup(content_response.content,'html.parser')

content = content_98a5f537c46e6a2bcd1066ec72b9a612.select_one('.content').text.strip()

#将新闻数据存储到MongoDB中

data ={'category': category,'title': title,'abstract': abstract,'source': source,'time': time,

'content': content}

collection.insert_one(data)

#关闭MongoDB连接

client.close()

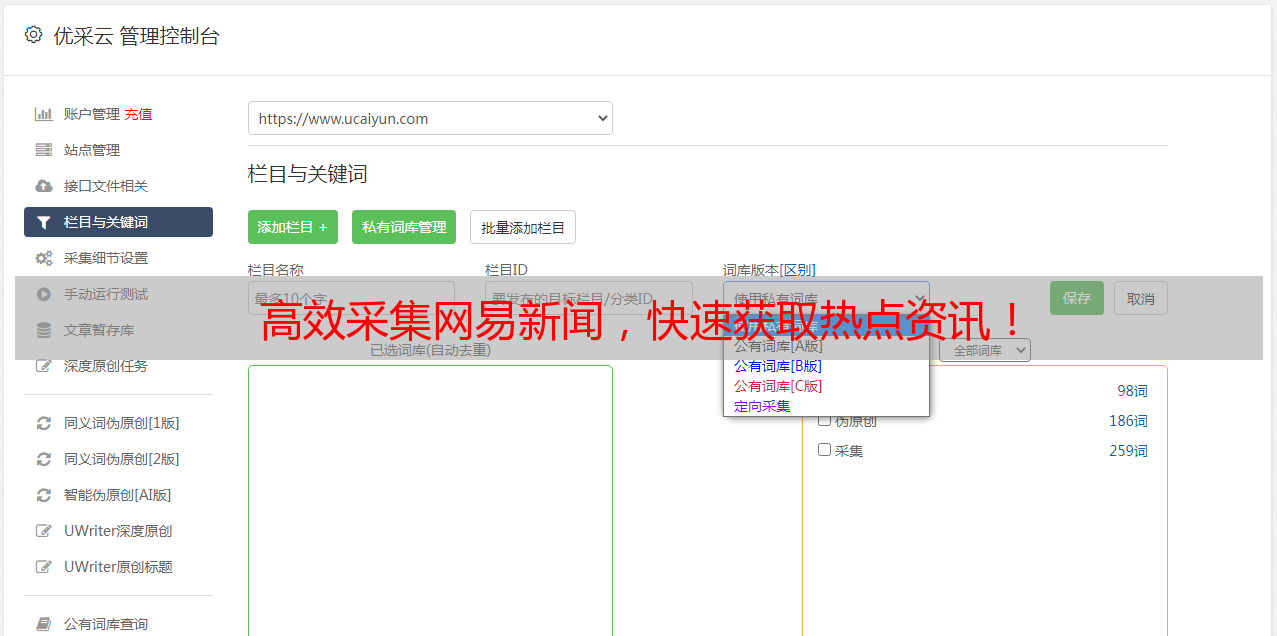

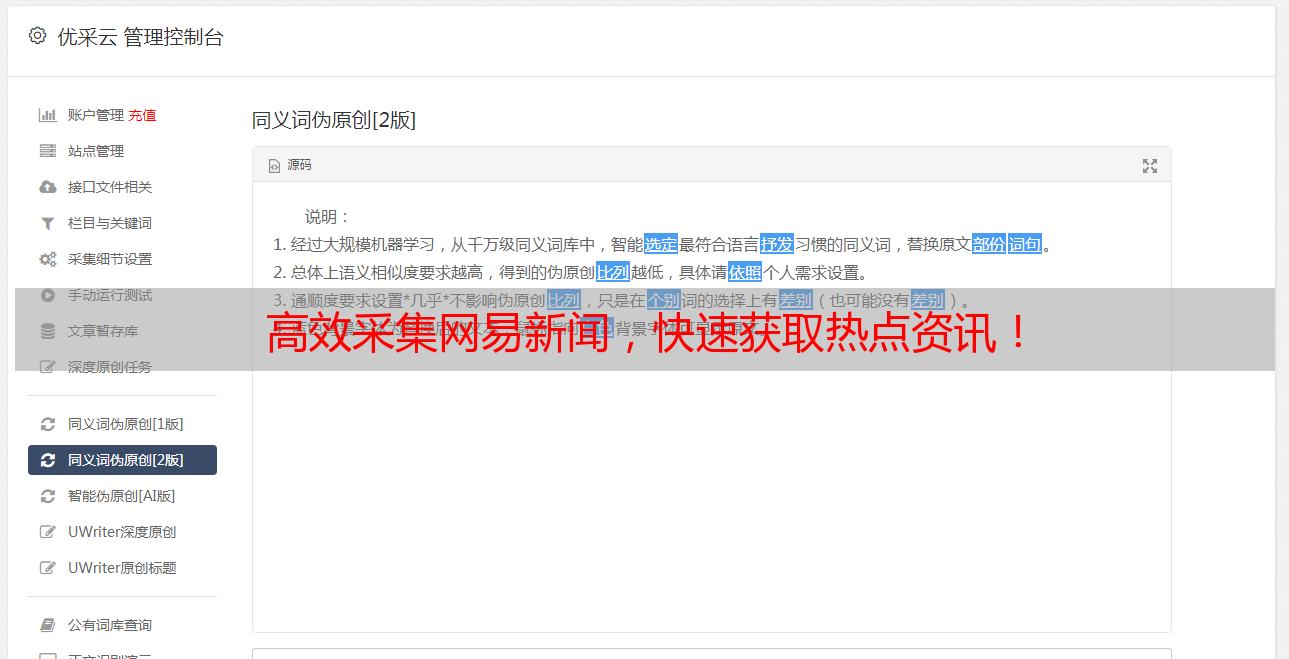

三、优采云,让SEO更简单

在进行网站SEO优化时,我们通常需要对网站的关键词、标题、描述等元素进行优化。而对于大型网站来说,手动修改这些元素是一项非常耗时且繁琐的工作。因此,我们可以使用优采云这样的工具来自动化地完成这些工作。

优采云是一款专业的SEO优化工具,可以帮助用户快速优化网站关键词、标题、描述等元素,并提高网站的排名。使用优采云,不仅可以节省大量时间和精力,还能够提高网站的曝光率和流量。

四、总结

本文介绍了一种基于Python语言的网易新闻数据采集程序,并结合实例详细讲解了其具体实现过程。同时,还介绍了一款专业的SEO优化工具——优采云,帮助用户快速优化网站关键词、标题、描述等元素,并提高网站的排名。希望本文能够对大家有所帮助。