Python抓取Java网页,轻松编写网络爬虫

优采云 发布时间: 2023-04-05 13:16在网络时代,数据是最为宝贵的资源之一。而要获取这些宝贵的数据,我们需要通过网络爬虫来获取。本文将介绍如何使用Python编写爬虫程序,以及如何通过Python抓取Java网页。

一、什么是网络爬虫?

网络爬虫是一种自动化程序,可以在互联网上抓取信息并进行处理。它们可以自动访问Web页面、提取数据、存储数据和分析数据。网络爬虫主要用于搜索引擎、价格比较、社交媒体分析等领域。

二、Python抓取Java网页的实现方法

1.使用Python Requests库

Python Requests库是Python中一个非常流行的HTTP客户端库。它允许我们向Web服务器发送HTTP/1.1请求,并能够自动处理重定向、Cookies等功能。以下代码演示了如何使用Requests库来获取Java网页:

python

import requests

url ='https://www.java.com/'

response = requests.get(url)

print(response.text)

2.使用Python Scrapy框架

Scrapy是一个基于Python的开源网络爬虫框架,它提供了一个简单而强大的方式来提取Web页面中的信息。以下代码演示了如何使用Scrapy框架来获取Java网页:

python

import scrapy

class JavaSpider(scrapy.Spider):

name ="Java"

allowed_domains =["java.com"]

start_urls =[

"https://www.java.com/",

]

def parse(self, response):

for sel in response.xpath('//ul/li'):

title = sel.xpath('a/text()').extract_first()

link = sel.xpath('a/@href').extract_first()

print(title, link)

三、如何分析抓取到的数据?

1.使用Python Pandas库

Pandas是一个开源的Python数据分析库,它提供了快速、灵活和富有表现力的数据结构,可以帮助我们轻松地处理和分析数据。以下代码演示了如何使用Pandas库来分析抓取到的Java网页数据:

python

import pandas as pd

url ='https://www.java.com/'

df_list = pd.read_html(url)

df = df_list[0]

print(df.head())

2.使用Python BeautifulSoup库

BeautifulSoup是一个用于解析HTML和XML文档的Python库,它可以将Web页面转换为Python对象,使得我们可以轻松地提取其中的信息。以下代码演示了如何使用BeautifulSoup库来分析抓取到的Java网页数据:

python

from bs4 import BeautifulSoup

import requests

url ='https://www.java.com/'

response = requests.get(url)

soup = BeautifulSoup(response.text,'html.parser')

print(soup.title.string)

四、如何存储抓取到的数据?

1.存储为CSV文件

CSV是一种常见的文件格式,它可以存储表格数据。我们可以使用Python中的csv库来将抓取到的数据存储为CSV文件。以下代码演示了如何将抓取到的Java网页数据存储为CSV文件:

python

import csv

import requests

from bs4 import BeautifulSoup

url ='https://www.java.com/'

response = requests.get(url)

soup = BeautifulSoup(response.text,'html.parser')

with open('java.csv', mode='w', newline='') as file:

writer = csv.writer(file)

writer.writerow(['Title','Link'])

for sel in soup.select('ul > li >a'):

title = sel.get_text(strip=True)

link = sel['href']

writer.writerow([title, link])

2.存储为MySQL数据库

MySQL是一个流行的开源关系型数据库管理系统,我们可以使用Python中的pymysql库来将抓取到的数据存储到MySQL数据库中。以下代码演示了如何将抓取到的Java网页数据存储到MySQL数据库中:

python

import pymysql.cursors

import requests

from bs4 import BeautifulSoup

url ='https://www.java.com/'

response = requests.get(url)

soup = BeautifulSoup(response.text,'html.parser')

connection = pymysql.connect(host='localhost',

user='root',

password='password',

db='test',

charset='utf8mb4')

try:

with connection.cursor() as cursor:

for sel in soup.select('ul > li >a'):

title = sel.get_text(strip=True)

link = sel['href']

sql ="INSERT INTO `java`(`title`,`link`) VALUES (%s,%s)"

cursor.execute(sql,(title, link))

connection.commit()

finally:

connection.close()

五、如何进行SEO优化?

SEO(Search Engine Optimization)指的是搜索引擎优化,它是一种通过改进网站结构和内容,以提高在搜索引擎中的排名的技术。以下是一些常见的SEO优化技巧:

1.关键词密度:在文章中适当地使用关键词,但不要过度使用。

2.标题标签:使用正确的标题标签来突出文章中的关键内容。

3.内部链接:在文章中添加内部链接,以便搜索引擎更好地理解网站结构。

4.图片标签:为每张图片添加正确的标签和描述,以便搜索引擎更好地理解图片内容。

5.网站速度:保证网站加载速度快,以提高用户体验和搜索排名。

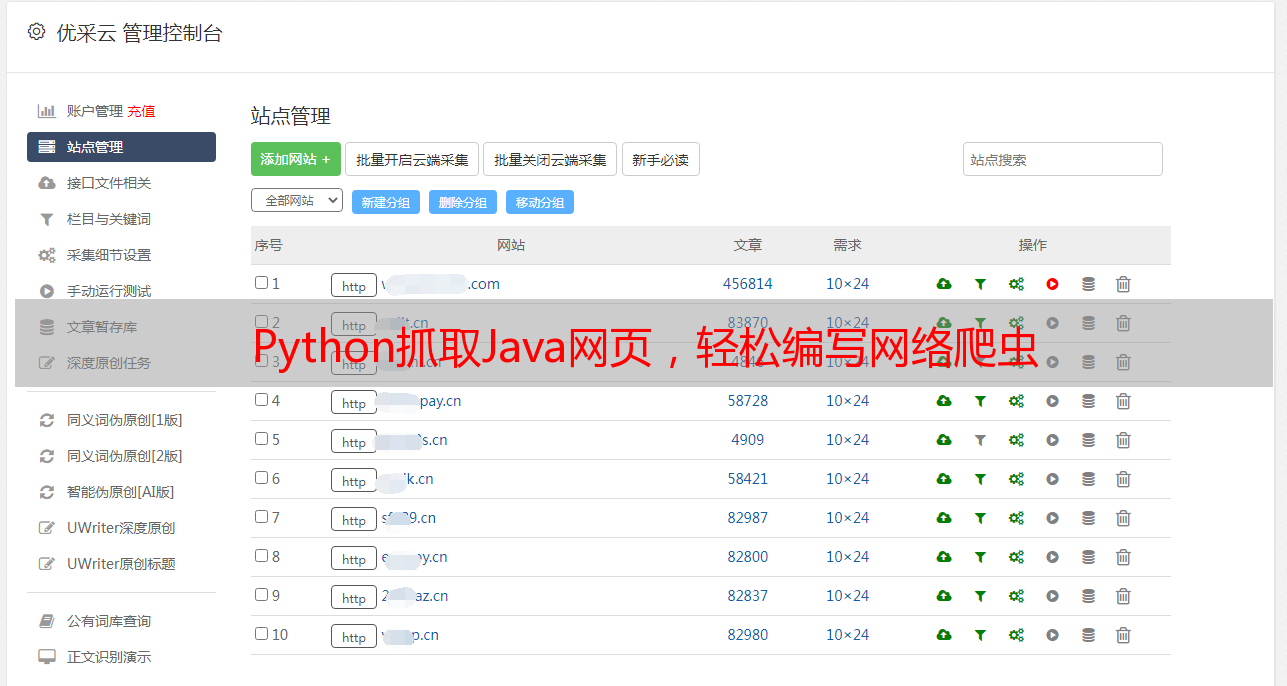

六、如何使用优采云?

优采云是一个专业的数据分析平台,它可以帮助我们更轻松地进行数据分析和SEO优化。以下是一些使用优采云的建议:

1.使用优采云分析爬虫抓取到的数据,以便更好地理解数据。

2.使用优采云进行关键词研究和竞争对手分析,以便更好地了解市场情况。

3.使用优采云进行网站分析,以便更好地了解用户行为和流量来源。

4.使用优采云进行SEO优化,以便更好地提高搜索引擎排名。

七、总结

本文介绍了如何使用Python抓取Java网页,并对抓取到的数据进行分析和存储。同时,本文也介绍了一些SEO优化和使用优采云的技巧。希望读者可以通过本文学习到一些有用的知识,更好地进行数据分析和SEO优化。

八、参考链接

1. Python Requests库:http://docs.python-requests.org/en/master/

2. Python Scrapy框架:https://scrapy.org/

3. Python Pandas库:https://pandas.pydata.org/

4. Python BeautifulSoup库:https://www.crummy.com/software/BeautifulSoup/bs4/doc/

5. MySQL数据库:https://www.mysql.com/

6. SEO优化技巧:https://www.searchenginejournal.com/seo-guide/