Python自动抓取网页数据:原理、注意事项与内容解析

优采云 发布时间: 2023-04-05 13:15Python作为一种高效、易用的编程语言,最近在数据采集领域越来越受欢迎。Python自动抓取网页数据,是一种基于Python编程语言的数据采集方法,不仅能够快速、高效地获取网页上的信息,还可以将获取到的数据进行处理和分析。本文将详细介绍Python自动抓取网页数据的基本原理、实现方法、注意事项等方面的内容。

一、Python自动抓取网页数据概述

Python自动抓取网页数据是指利用Python编程语言实现对特定网站的自动访问,并获取该网站中特定信息的过程。这种技术通常被应用于*敏*感*词*的数据采集和处理任务中,比如互联网搜索引擎、电商平台等。

二、Python自动抓取网页数据实现方法

1.网络请求库:Python中最为流行的网络请求库是requests,它提供了简单易用的API接口,可以轻松地发送HTTP请求,并获取响应结果。

2.数据解析库:对于获取到的HTML文档进行解析是必不可少的一步。在Python中比较常用的解析库有BeautifulSoup、lxml等。

3.数据存储:获取到的数据需要进行存储。可以选择将数据存储到本地文件或者数据库中,比如MySQL、MongoDB等。

三、Python自动抓取网页数据注意事项

1.网站的反爬虫机制:为了防止恶意爬虫对网站造成过大的负载压力,很多网站都会采取一些反爬虫机制,比如IP封禁、验证码等。因此在进行数据采集时需要注意这些机制,并且要遵守网站的访问规则。

2.数据处理和清洗:获取到的数据可能包含一些垃圾信息或者重复信息,需要进行清洗和处理。比如去除HTML标签、去除空格和换行符等。

3.数据可视化:获取到的数据可以通过可视化工具进行展示,比如matplotlib、seaborn等。

四、Python自动抓取网页数据实战案例

以下是一个简单的Python自动抓取网页数据实战案例:

python

import requests

from bs4 import BeautifulSoup

url ='https://www.ucaiyun.com'

response = requests.get(url)

soup = BeautifulSoup(response.text,'lxml')

title = soup.title.string

print(title)

上述代码使用requests库发送HTTP请求,并使用BeautifulSoup解析HTML文档。最终输出了该网站的标题。

五、总结

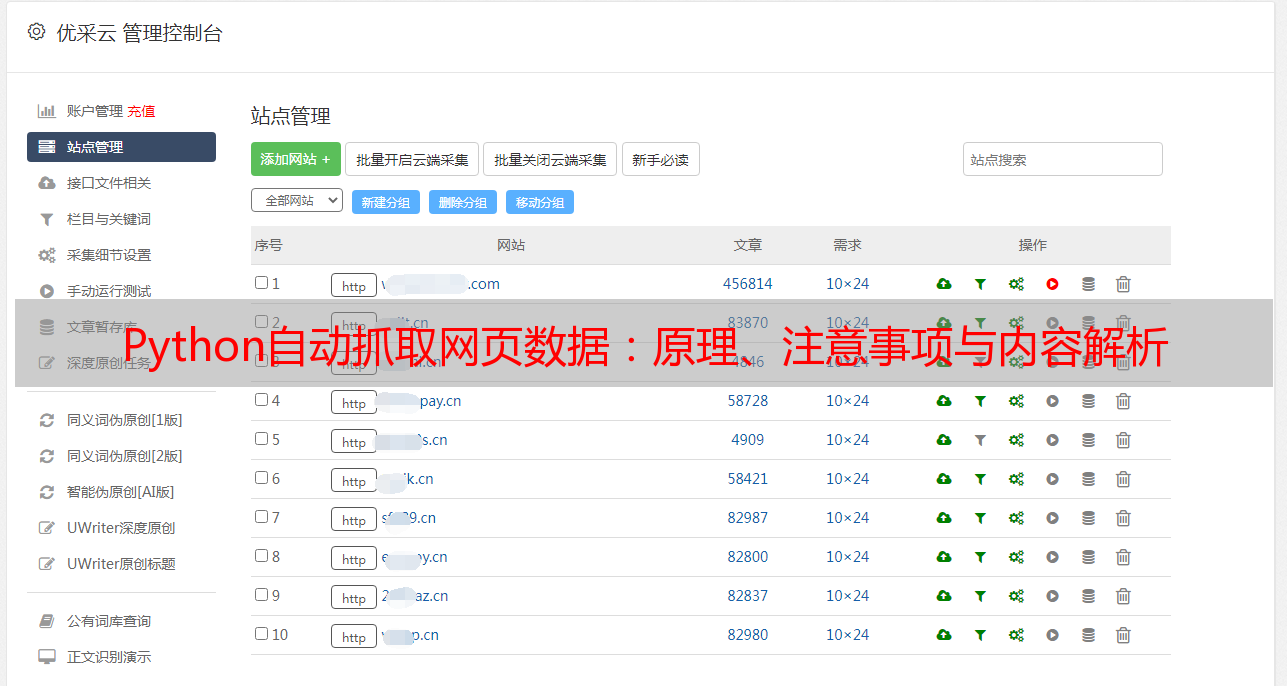

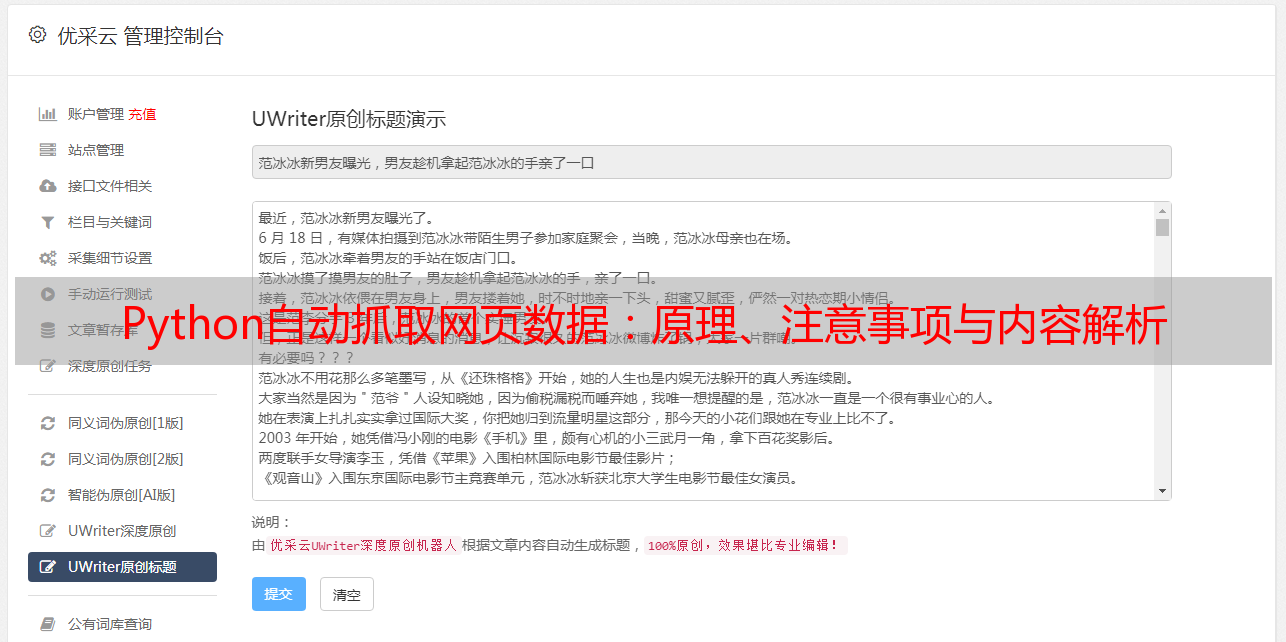

Python自动抓取网页数据是一种高效、易用的数据采集方法,可以轻松实现对特定网站的自动访问,并获取该网站中特定信息的过程。在实际应用中需要注意反爬虫机制、数据处理和清洗、数据可视化等方面的问题。优采云提供SEO优化服务,可帮助企业提高网站排名,欢迎访问www.ucaiyun.com了解更多详情。