高效采集知乎数据,Python自动化爬虫程序实现!

优采云 发布时间: 2023-04-05 08:15在当今信息时代,获取数据已经成为了互联网行业的必备技能。而知乎作为一个集合了海量优质知识的平台,更是成为了各类数据分析和挖掘的重要来源之一。然而,手动采集这些数据无论从效率还是准确性上都无法满足需求。因此,在本文中,我们将介绍如何使用Python编写自动化爬虫程序,实现对知乎数据的高效采集。

1.爬虫基础

在开始编写爬虫程序前,我们需要先了解一些基础概念和技术。例如HTTP协议、HTML语言、XPath语法、正则表达式等等。同时,在使用Python进行爬虫开发前,需要安装相应的第三方库,如requests、beautifulsoup4、lxml等。这些库可以大大简化我们的代码编写过程,并提供了许多便利的功能。

2.爬虫流程

一个基本的爬虫流程包括以下几个步骤:发送请求、解析内容、存储数据。其中,发送请求指向目标网站发送HTTP请求,并获取到相应的HTML文档;解析内容则是对HTML文档进行解析和提取有用信息;存储数据则是将提取的数据保存到本地或数据库中。在实际开发中,这三个步骤通常会多次循环执行,直到所有需要采集的数据都被获取到。

3.爬虫注意事项

在进行爬虫开发时,我们需要注意一些法律和道德问题。例如不得侵犯他人隐私、不得对目标网站进行攻击、不得进行商业用途等等。同时,在爬取网站之前,我们也需要了解其反爬虫策略,并采取相应的措施避免被封禁。

4. Py采集知乎实例

下面我们以Py采集知乎为例,介绍如何使用Python编写自动化爬虫程序。首先,我们需要确定需要采集的目标信息和网页结构。例如,我们可以选择采集某个话题下的所有问题及其回答。然后,我们可以通过发送HTTP请求获取到该话题下的HTML文档,并使用XPath或beautifulsoup4对文档进行解析和提取信息。最后,我们可以将提取出来的数据保存到本地或数据库中。

python

import requests

from lxml import etree

url ='https://www.zhihu.com/topic/19552832/hot'

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

response = requests.get(url, headers=headers)

html = etree.HTML(response.text)

questions = html.xpath('//div[@class="List-item"]')

for question in questions:

title = question.xpath('.//h2[@class="ContentItem-title"]/a/text()')[0]

answer_num = question.xpath('.//div[@class="ContentItem-statusItem"]/text()')[1]

print(title, answer_num)

5.结语

通过本文的介绍,相信大家已经对如何使用Python编写自动化爬虫程序有了一定的了解。当然,爬虫开发并不是一件简单的事情,需要我们具备一定的编程基础和实践经验。同时,在进行爬虫开发时,我们也需要遵守相关法律法规和道德准则,以免造成不必要的麻烦。最后,希望大家能够在合法、合规、合理的前提下,充分利用爬虫技术,获取到更多有用的数据信息。

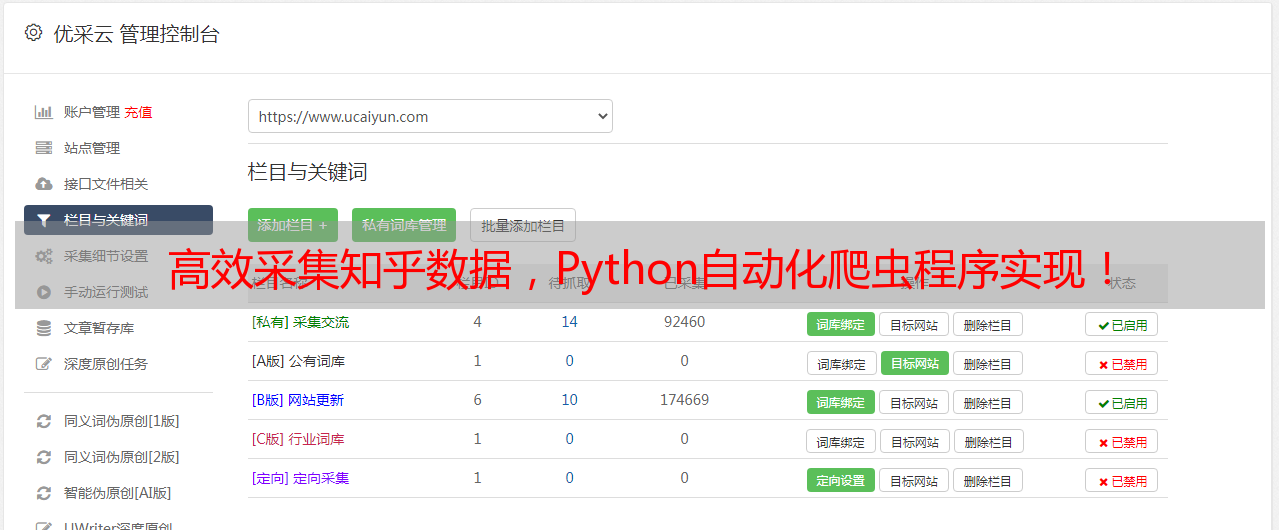

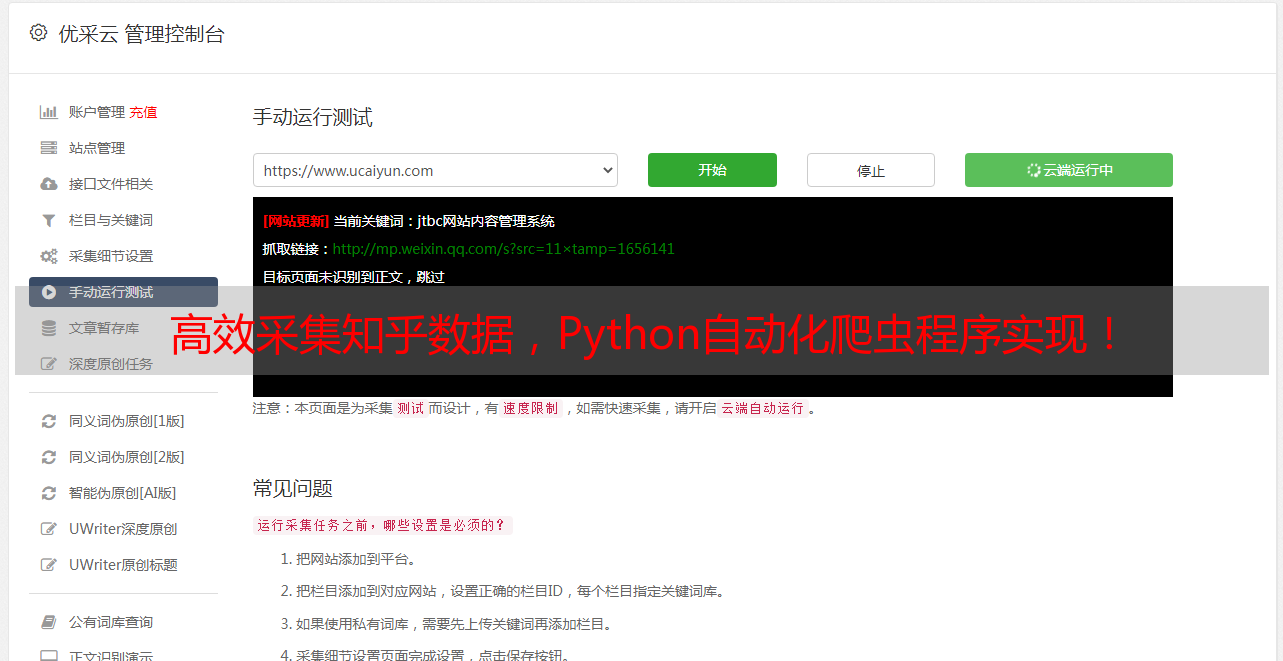

优采云,专业的数据采集与处理平台,致力于为用户提供高效、精准、安全的数据服务。我们提供全球海量数据源和多种数据采集方式,并结合先进的AI算法和人工审核机制,保证数据质量和安全性。同时,我们还提供SEO优化和网站建设等服务,助力用户实现数字化转型。了解更多优采云,请访问我们的官网:www.ucaiyun.com。