Scrapy轻松实现豆瓣翻页抓取攻略

优采云 发布时间: 2023-04-04 16:19众所周知,Scrapy是一个Python的爬虫框架,可以用来抓取各种网站的数据。在爬取豆瓣网站时,经常需要翻页才能获取更多的信息。那么,在使用Scrapy抓取豆瓣时,如何实现翻页呢?本文将详细介绍。

1.确定起始URL和解析规则

在使用Scrapy抓取豆瓣网站时,首先要确定起始URL和解析规则。例如,我们要抓取电影分类下的所有电影信息,可以以https://movie.douban.com/subject_search?search_text=电影&cat=1002为起始URL,并使用XPath或CSS选择器解析页面内容。

2.获取下一页链接

在解析页面内容时,可以通过XPath或CSS选择器获取下一页链接。例如,在豆瓣电影分类页面中,下一页链接的XPath表达式为'//span[@class="next"]/a/@href',可以使用response.xpath()方法获取。

3.构造Request对象

获取到下一页链接后,需要构造Request对象并返回给Scrapy引擎。可以使用yield关键字将Request对象返回给引擎。例如,在Spider中编写代码:

python

def parse(self, response):

#解析页面内容

#获取下一页链接

next_url = response.xpath('//span[@class="next"]/a/@href').extract_first()

if next_url:

#构造Request对象

next_url = response.urljoin(next_url)

yield scrapy.Request(next_url, callback=self.parse)

4.设置下载延迟

在使用Scrapy抓取豆瓣时,需要设置下载延迟,以避免被封IP。可以在settings.py文件中设置DOWNLOAD_DELAY参数。例如:

python

DOWNLOAD_DELAY = 2

5.使用代理IP

如果需要大量抓取豆瓣网站的数据,建议使用代理IP,以避免被封IP。可以在middlewares.py文件中编写ProxyMiddleware中间件,并在settings.py文件中启用该中间件。例如:

python

class ProxyMiddleware(object):

def process_request(self, request, spider):

proxy = get_proxy()#获取代理IP

request.meta['proxy']="http://"+ proxy['ip_port']

def process_response(self, request, response, spider):

if response.status != 200:

proxy = get_proxy()#获取代理IP

request.meta['proxy']="http://"+ proxy['ip_port']

return request.replace(url=request.url)

return response

def process_exception(self, request, exception, spider):

proxy = get_proxy()#获取代理IP

request.meta['proxy']="http://"+ proxy['ip_port']

return request

6.控制并发数和重试次数

在抓取豆瓣网站时,需要控制并发数和重试次数,以提高抓取效率和稳定性。可以在settings.py文件中设置CONCURRENT_REQUESTS和RETRY_TIMES参数。例如:

python

CONCURRENT_REQUESTS = 16

RETRY_TIMES = 3

7.使用Scrapy-Redis分布式爬虫框架

如果需要*敏*感*词*抓取豆瓣网站的数据,建议使用Scrapy-Redis分布式爬虫框架,以提高抓取效率和稳定性。可以在middlewares.py文件中编写RedisMiddleware中间件,并在settings.py文件中启用该中间件。例如:

python

class RedisMiddleware(object):

def __init__(self, redis_host, redis_port, redis_password):

self.redis_host = redis_host

self.redis_port = redis_port

self.redis_password = redis_password

@classmethod

def from_crawler(cls, crawler):

return cls(

redis_host=crawler.settings.get('REDIS_HOST'),

redis_port=crawler.settings.get('REDIS_PORT'),

redis_password=crawler.settings.get('REDIS_PASSWORD')

)

def process_request(self, request, spider):

if not request.meta.get('redis_key'):

return None

url = request.url

if isinstance(url, bytes):

url = url.decode('utf-8')

rconn = redis.Redis(host=self.redis_host,

port=self.redis_port,

password=self.redis_password)

if rconn.sismember(request.meta['redis_key'], url):

raise IgnoreRequest("Duplicate request:%s"% url)

else:

rconn.sadd(request.meta['redis_key'], url)

def process_response(self, request, response, spider):

return response

def process_exception(self, request, exception, spider):

return None

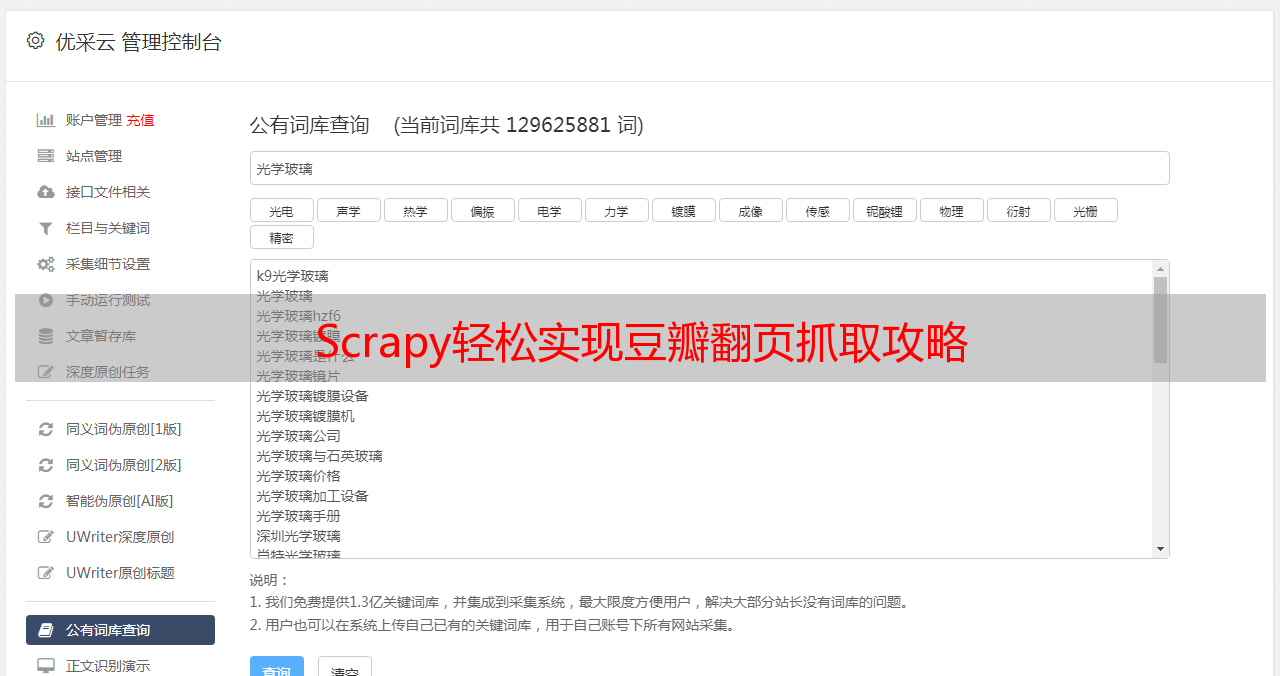

8.结合优采云进行SEO优化

在写作和发布文章时,建议结合优采云进行SEO优化,以提高文章的曝光率和阅读量。可以在优采云平台上进行关键词研究、标题优化、内容分析、内链外链等操作,以提高文章的质量和排名。如果需要了解更多信息,请访问www.ucaiyun.com。

通过上述8个方面的讲解,相信大家已经掌握了Scrapy抓取豆瓣如何翻页的技巧。希望本文对大家有所帮助。