PHP采集网页代码的技巧:详解方法与步骤

优采云 发布时间: 2023-04-04 06:09在如今信息爆炸的时代,获取并处理海量数据已经成为了一种趋势。而网络爬虫技术则是实现这种趋势的重要手段之一。PHP作为一门流行的Web编程语言,自然也有其方便快捷地获取网络数据的方法。本文将详细讲解PHP如何采集网页代码。

一、什么是网页采集

所谓网页采集,简单来说就是通过程序模拟浏览器请求访问目标页面,并从中提取所需数据的过程。而PHP可以通过CURL扩展、file_get_contents()函数等多种方式实现网页采集。

二、使用CURL扩展进行网页采集

CURL扩展是一个可以用来向服务器请求资源并以各种方式传输数据的库。下面我们以一个简单的例子来说明如何使用CURL扩展进行网页采集:

<?php

//初始化一个CURL对象

$curl = curl_init();

//设置需要采集的页面地址

curl_setopt($curl, CURLOPT_URL,"https://www.ucaiyun.com/");

//设置请求头信息,以便模拟浏览器行为(可选)

curl_setopt($curl, CURLOPT_USERAGENT,'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36');

//执行请求并获取响应

$response = curl_exec($curl);

//关闭CURL对象

curl_close($curl);

//输出响应内容

echo $response;

?>

通过上述代码,我们可以成功采集到https://www.ucaiyun.com/的网页代码。

三、使用file_get_contents()函数进行网页采集

除了CURL扩展,PHP还提供了一个方便快捷的函数file_get_contents()来获取网络资源。下面我们来看一下如何使用file_get_contents()函数进行网页采集:

<?php

//设置需要采集的页面地址

$url ="https://www.ucaiyun.com/";

//通过file_get_contents()函数获取响应内容

$response = file_get_contents($url);

//输出响应内容

echo $response;

?>

四、如何解决采集过程中遇到的问题

在进行网页采集时,可能会遇到许多问题,例如:目标网站反爬虫、目标网站需要登录等。下面我们将针对这些问题进行分析:

1、目标网站反爬虫

为了防止自己的数据被网站爬虫抓取,许多网站都会对爬虫进行限制。这时,我们可以通过设置请求头信息或者使用代理IP等方式来绕过反爬虫机制。

2、目标网站需要登录

如果目标网站需要登录后才能访问某些页面,我们可以使用模拟登录的方式来获取所需数据。具体实现方式可以参考一些开源的模拟登录库,例如GuzzleHttp等。

五、如何进行数据处理

采集到网页代码后,我们还需要对其进行数据处理。这时,我们可以使用PHP中的字符串函数、正则表达式、DOM解析器等工具来提取出所需数据。

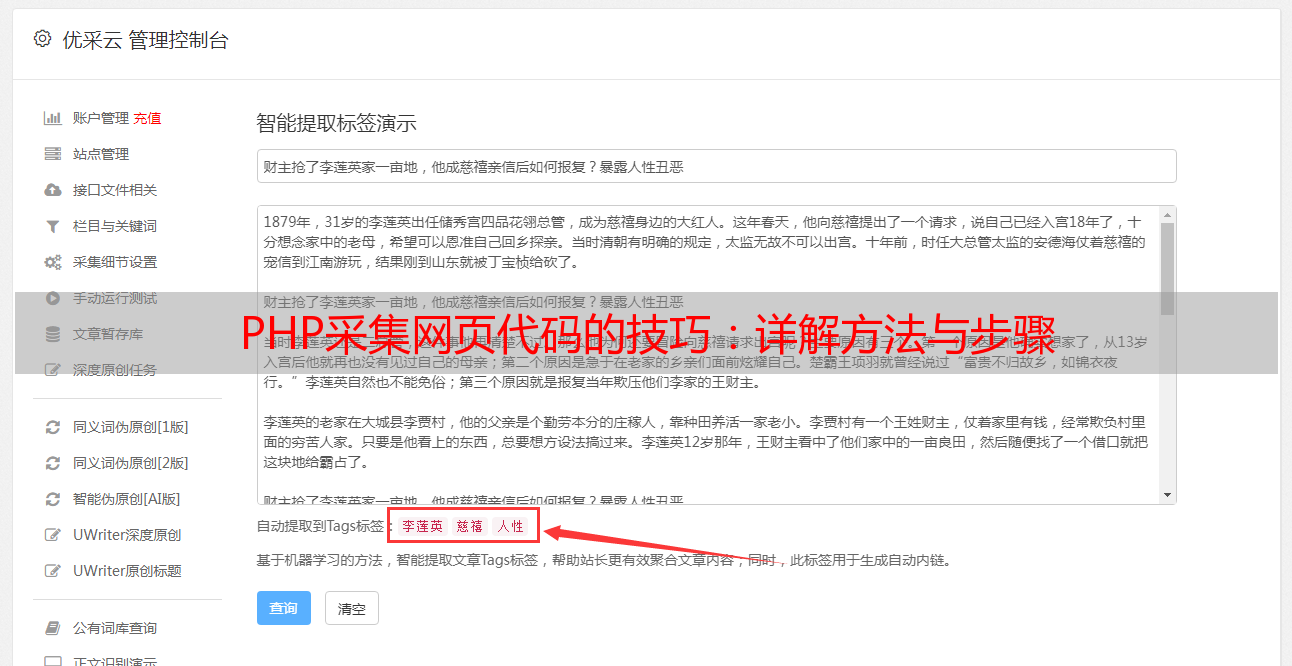

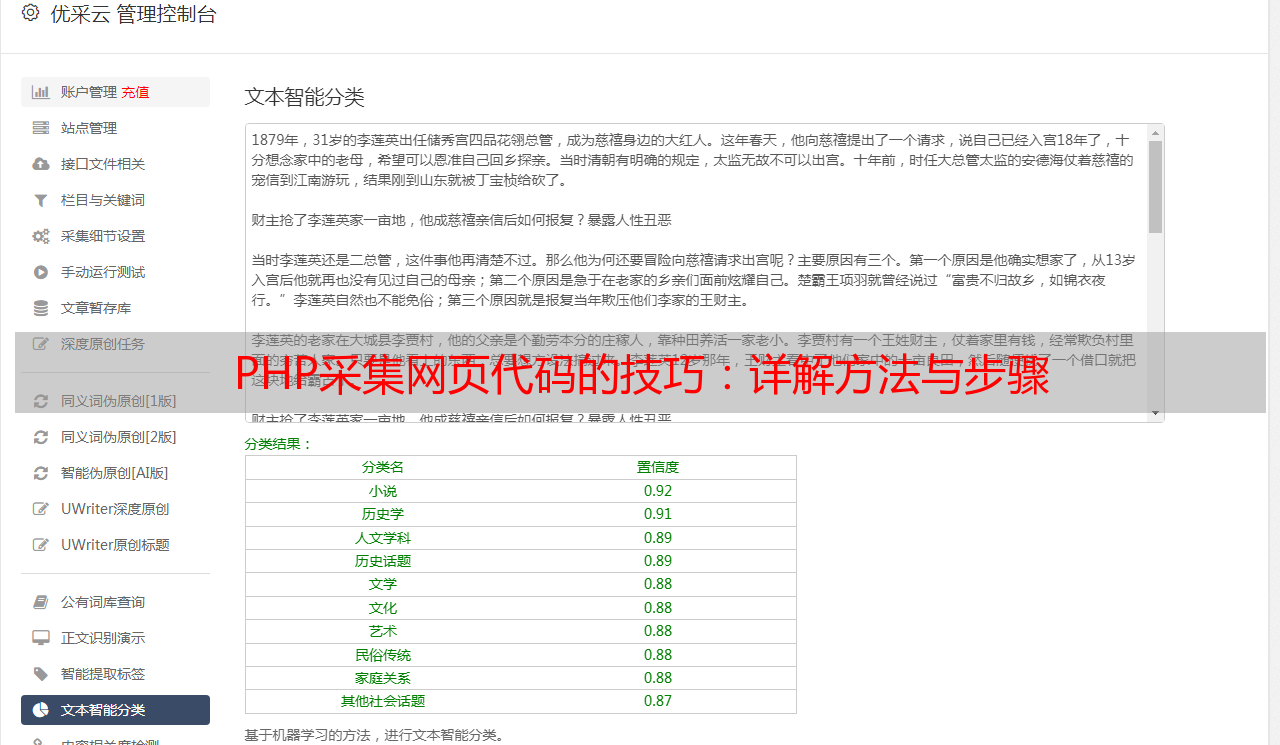

六、优采云

在进行网页采集时,如果遇到了一些问题无法解决,可以考虑使用第三方采集工具。优采云是一款功能强大、易于操作的网页采集工具,可以帮助用户轻松地完成网页采集任务。同时,优采云还提供了SEO优化等服务,可以帮助用户更好地推广自己的网站。想要了解更多信息,请访问www.ucaiyun.com。

七、总结

本文详细讲解了PHP如何采集网页代码,并针对常见问题进行了分析和解决。希望读者能够掌握这些技能,并在实际应用中发挥出更大的作用。

八、参考资料

1. PHP官方手册:https://www.php.net/manual/zh/

2. CURL官方文档:https://curl.se/docs/

3. GuzzleHttp官方文档:https://docs.guzzlephp.org/en/stable/