轻松学会数据采集:打造专属.conf文件

优采云 发布时间: 2023-04-03 16:18近年来,随着互联网的普及和数据信息化的加速,数据采集越来越成为了企业和个人获取信息的重要手段。而如何进行高效、精准的数据采集,是每个数据从业者必须掌握的技能。本文将从九个方面详细介绍如何通过编写.conf文件实现数据采集,并结合实际案例进行分析。希望对大家有所帮助。

第一步:确定采集目标

在进行数据采集前,首先需要明确自己要采集哪些数据,比如需要采集哪些网站、目标网站的页面结构、需要爬取哪些字段等。只有明确了要采集哪些内容,才能更好地制定后续的采集计划。

第二步:选择合适的爬虫框架

选择合适的爬虫框架可以大大提高数据采集效率。市面上常用的爬虫框架有Scrapy、BeautifulSoup等,各有特点。例如,Scrapy是一个基于Python语言的高级网络爬虫框架,具有快速高效、支持多线程等优点;BeautifulSoup则是一个解析HTML和XML文档的Python库,适合简单易用的数据采集任务。

第三步:编写.conf文件

.conf文件是爬虫框架中的一个配置文件,用于指定爬虫的一些参数和规则。在编写.conf文件时,需要注意以下几个方面:

1.指定爬虫名称:可以在该配置文件中指定爬虫的名称,方便后续调用。

2.指定起始URL:在该配置文件中,需要指定爬取的起始URL地址。

3.指定请求头:在发送请求时,需要设置请求头,以便网站服务器能够正确识别请求信息。可以通过在配置文件中设置USER_AGENT、REFERER等参数来模拟浏览器发送请求。

4.指定页面解析规则:在该配置文件中,需要指定页面解析规则,以便正确解析所需数据。可以通过XPath、CSS Selector等方式来提取目标数据。

5.指定数据输出格式:在该配置文件中,可以指定输出数据的格式,如JSON、CSV等。

6.设置请求间隔时间和重试次数:为了防止被封IP或者对目标网站造成过大的负载压力,在设置爬虫参数时需要设置请求间隔时间和重试次数等参数。

第四步:执行爬虫程序

完成以上三个步骤后,即可执行编写好的爬虫程序。可以通过命令行或者IDE等方式启动爬虫程序,程序会按照.conf文件中设置的规则进行数据采集。

第五步:数据清洗和处理

在完成数据采集后,需要对采集到的数据进行清洗和处理,以便更好地进行分析和应用。可以通过Python中的pandas、numpy等库来进行数据清洗和处理。

第六步:数据存储

在完成数据清洗和处理后,需要将采集到的数据存储起来。常见的数据存储方式有MySQL、MongoDB、Redis等。可以根据自己的需求选择合适的数据存储方式。

第七步:SEO优化

为了让自己的网站或者产品更好地被搜索引擎收录,需要进行SEO优化。可以通过关键词优化、页面结构优化、内容优化等方式来提高网站的排名。

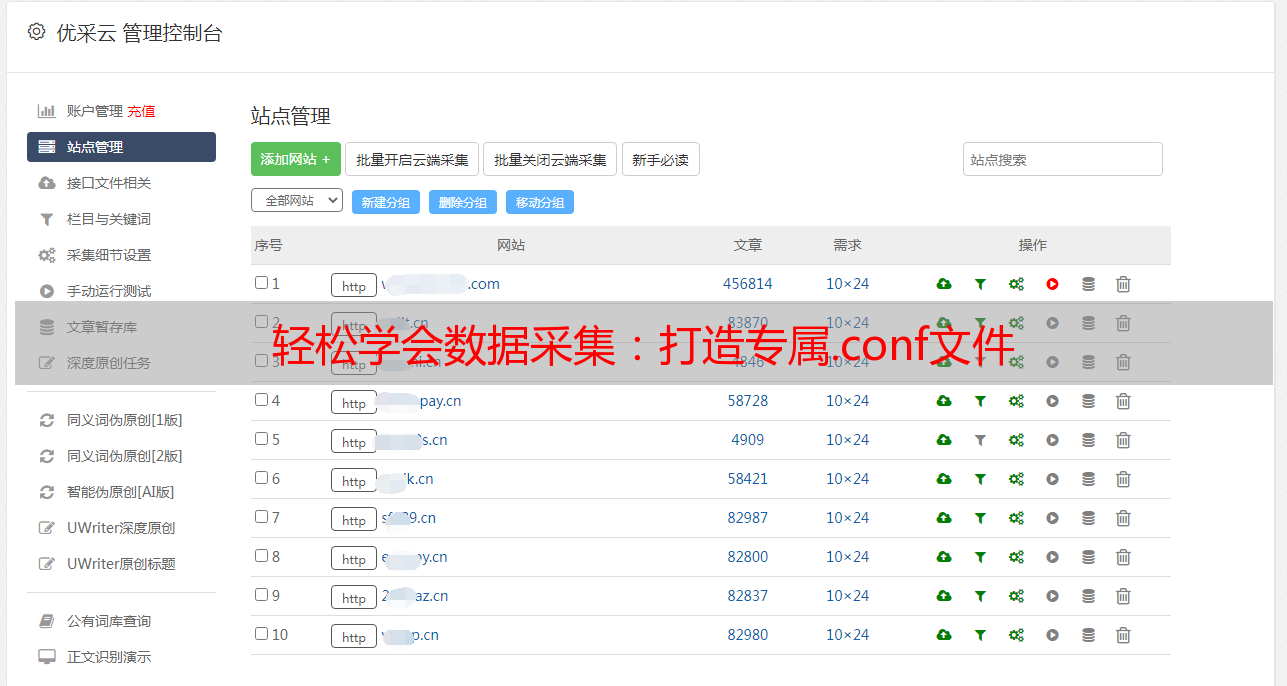

第八步:使用优采云加速数据采集

为了提高数据采集效率,可以通过使用优采云来加速数据采集。优采云是一款专业的数据采集工具,可以快速高效地获取所需数据,同时支持多种输出格式和多线程模式。

第九步:总结与展望

通过本文的介绍,相信大家已经掌握了如何通过编写.conf文件实现高效精准的数据采集。但是,随着互联网信息化的不断发展,数据采集技术也在不断更新和发展。因此,我们需要不断学习和掌握新的数据采集技术,以适应市场需求的变化。

本文介绍了数据采集写出.conf文件的基本步骤,包括确定采集目标、选择合适的爬虫框架、编写.conf文件、执行爬虫程序、数据清洗和处理、数据存储、SEO优化、使用优采云加速数据采集以及总结与展望等方面。希望对大家有所帮助。更多优秀文章尽在优采云(www.ucaiyun.com)。