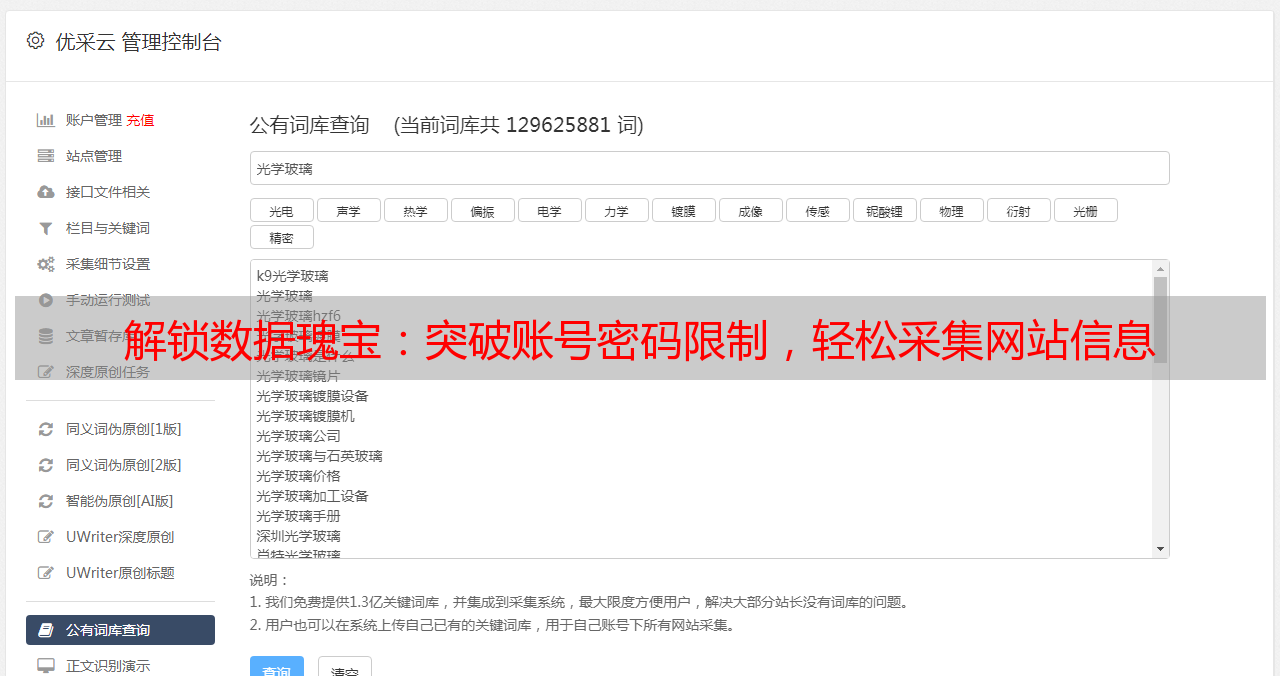

解锁数据瑰宝:突破账号密码限制,轻松采集网站信息

优采云 发布时间: 2023-04-03 13:13在今天的互联网时代,数据已经成为了一种极其珍贵的资源。而获取这些数据的方法,就是采集。然而,很多需要账号密码才能访问的网站,给采集带来了极大的困难。本文将从入门到精通,逐步介绍如何采集这些需要账号密码才能访问的网站上的数据。

一、了解目标网站

在开始采集之前,首先要了解目标网站。这包括目标网站的页面结构、数据格式、登录方式等等。同时,还需要了解目标网站对于爬虫的限制和反爬虫策略。

二、模拟登录

模拟登录是采集需要账号密码才能访问的网站数据的关键步骤。常用的登录方式有表单登录和Cookies登录。表单登录通过POST请求提交表单数据进行登录;Cookies登录则通过携带正确的Cookies信息进行模拟登录。

以下代码为Python语言实现Cookies登录:

bba304f6368537fd24b43c5f89cc680d#构造session对象

s = requests.Session()

#设置请求头

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

#构造登录数据

login_data ={

'username':'your_username',

'password':'your_password'

}

#发送登录请求

s.post('http://www.example.com/login', data=login_data, headers=headers)

#获取登录后的页面信息

response =s.get('http://www.example.com/data', headers=headers)

print(response.text)

三、解析网页

通过解析网页,可以提取出需要的数据。常用的解析方式有正则表达式、BeautifulSoup和XPath等。

以下代码为Python语言实现使用XPath解析网页:

python

from lxml import etree

#构造HTML对象

html = etree.HTML(response.text)

#使用XPath获取数据

data = html.xpath('//div[@class="data"]/text()')

print(data)

四、反反爬策略

为了防止爬虫对其网站造成影响,很多网站都会采取反爬策略。如IP封禁、验证码、JS加密等等。为了避免这些反爬策略,可以采用代理IP、打码平台和自动化浏览器等方式进行反反爬。

五、数据存储

在采集到需要的数据后,需要将其存储起来。常用的存储方式有文本文件、CSV文件、数据库等。

六、分布式爬虫

对于*敏*感*词*的数据采集任务,单机爬虫已经无法满足需求。这时候,分布式爬虫就显得尤为重要。分布式爬虫可以将任务分配给多台机器并行执行,提高采集效率。

七、反作弊策略

为了防止被对方网站封禁IP或账号,需要采取反作弊策略。如设置访问频率、随机User-Agent等等。

八、SEO优化

在采集数据的同时,也需要考虑SEO优化。如合理使用关键词、构建良好的网站结构等等。

九、总结

以上就是从入门到精通采集需要账号密码的网站数据所需掌握的技能和注意事项。通过不断实践和尝试,相信你一定能够成为一名优秀的数据采集工程师。

本文由优采云提供技术支持,欢迎访问www.ucaiyun.com获取更多相关信息。