今日头条文章提取技巧,快速高效!

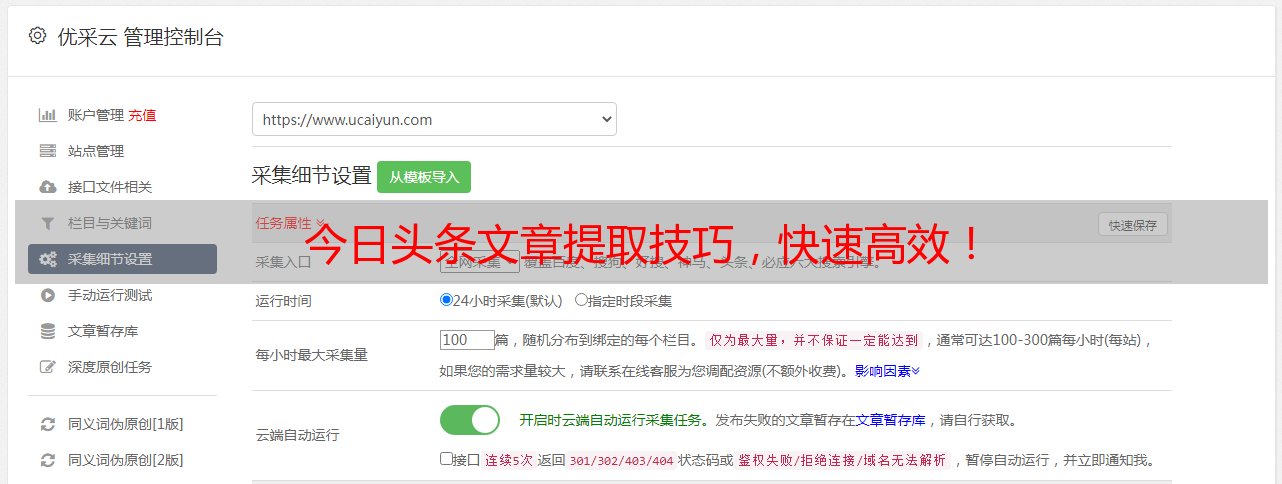

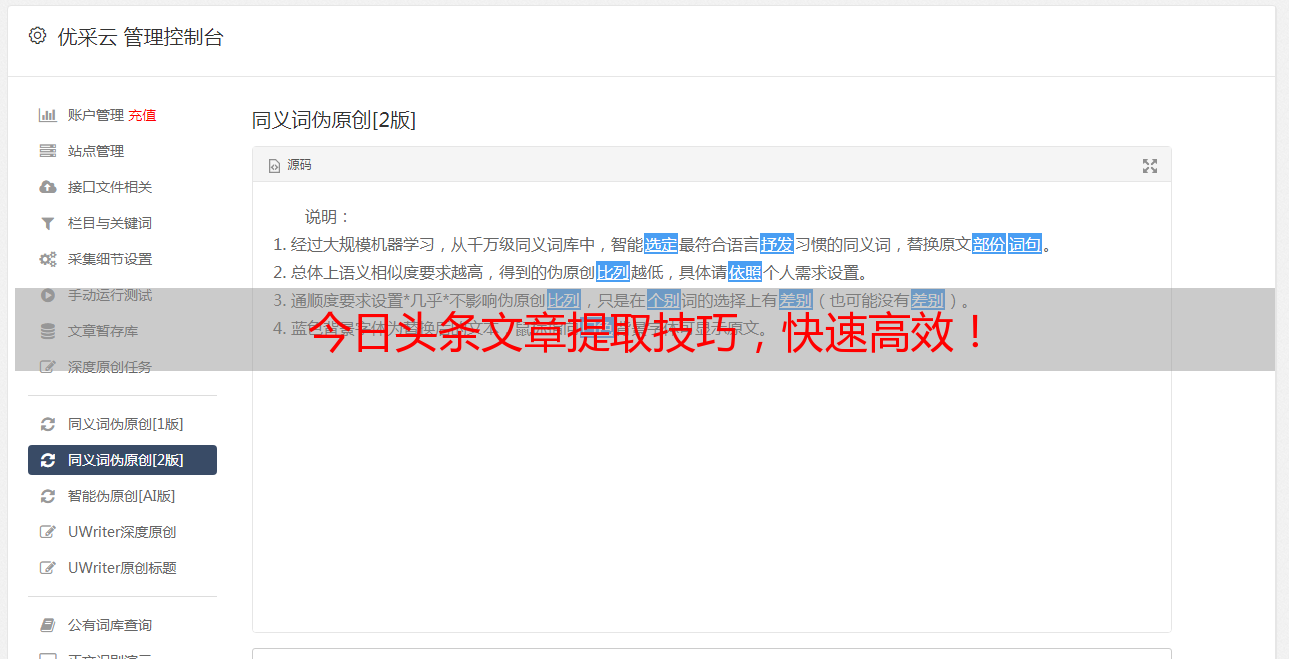

优采云 发布时间: 2023-04-03 04:07今天,我们来谈一下如何提取今日头条文章。作为一个自媒体人士,我们经常需要从今日头条等平台获取文章素材,但是这些平台并没有提供方便的工具来实现文章提取。那么,我们该如何快速、高效地提取今日头条文章呢?本文将从以下10个方面详细介绍。

1.什么是今日头条?

2.为什么要提取今日头条文章?

3.常见的今日头条文章提取方法

4.使用Python进行今日头条文章批量提取

5.使用Selenium模拟登录进行文章提取

6.如何处理反爬虫机制?

7.如何处理验证码?

8.如何优化爬虫效率?

9.爬虫数据的存储和分析

10.注意事项和法律风险

1、什么是今日头条?

今日头条是一款基于大数据技术的新闻客户端,于2012年上线。随着用户量的增加,它逐渐成长为一个集新闻、资讯、视频、社交等多元化内容于一身的综合性平台。截至2023年4月,今日头条已经成为全球最大的中文内容平台之一。

2、为什么要提取今日头条文章?

今日头条平台上有大量的优质内容,这些内容可以为我们的创作提供灵感和素材。但是,由于没有提供方便的工具来实现文章提取,我们需要通过其他方法来获取这些文章。

3、常见的今日头条文章提取方法

常见的今日头条文章提取方法包括手动复制粘贴、截图保存等方式。但是这些方法效率低下,且无法批量处理。因此,我们需要使用爬虫技术来解决这个问题。

4、使用Python进行今日头条文章批量提取

Python是一种高效、易学易用的编程语言,在爬虫领域也非常受欢迎。我们可以使用Python编写爬虫程序来批量提取今日头条文章。

首先,我们需要安装requests库和BeautifulSoup库。requests库可以用来发送HTTP请求,而BeautifulSoup库可以用来解析HTML页面。

在代码块中输入以下代码:

import requests

from bs4 import BeautifulSoup

def get_article(url):

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

res = requests.get(url, headers=headers)

soup = BeautifulSoup(res.text,'html.parser')

title = soup.select_one('h1.article-title').text

content ='\n'.join([p.text.strip() for p in soup.select('div.article-content p')])

return title, content

if __name__=='__main__':

url ='https://www.toutiao.com/a7025120587649588231/'

title, content = get_article(url)

print(title)

print(content)

在代码中,我们使用requests库发送HTTP请求,得到页面的HTML源码。然后使用BeautifulSoup库解析HTML页面,获取文章的标题和内容。最后将标题和内容打印出来。

5、使用Selenium模拟登录进行文章提取

有些今日头条文章需要登录才能查看,这时我们可以使用Selenium模拟登录来获取文章。Selenium是一个自动化测试工具,它可以模拟用户在浏览器上的操作。

在代码块中输入以下代码:

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import time

def login(username, password):

driver = webdriver.Chrome()

driver.get('https://sso.toutiao.com/')

time.sleep(1)

driver.find_element_by_name('username').send_keys(username)

driver.find_element_by_name('password').send_keys(password)

driver.find_element_by_class_name('btn-login').click()

time.sleep(5)

return driver

def get_article(driver, url):

driver.get(url)

title = driver.find_element_by_tag_name('h1').text

content ='\n'.join([p.text for p in driver.find_elements_by_css_selector('.article-content p')])

return title, content

if __name__=='__main__':

username ='your_username'

password ='your_password'

driver = login(username, password)

url ='https://www.toutiao.com/a7025120587649588231/'

title, content = get_article(driver, url)

print(title)

print(content)

在代码中,我们使用webdriver.Chrome()创建一个Chrome浏览器对象。然后使用get()方法打开今日头条登录页面。接着,我们使用find_element_by_name()方法和find_element_by_class_name()方法找到用户名输入框、密码输入框和登录按钮,并模拟用户输入用户名和密码,点击登录按钮。

在成功登录后,我们再次使用get()方法打开目标文章页面,并使用find_element_by_tag_name()方法找到文章标题,使用find_elements_by_css_selector()方法找到文章内容的所有段落。

6、如何处理反爬虫机制?

由于今日头条等平台都有反爬虫机制,我们需要采取一些措施来应对。常见的反爬虫机制包括IP封禁、UA检测、验证码等。

为了应对IP封禁,我们可以使用代理IP或者轮换IP的方式。为了应对UA检测,我们可以将请求头中的User-Agent字段设置为浏览器的User-Agent。为了应对验证码,我们可以手动输入验证码或者使用第三方打码平台。

7、如何处理验证码?

当我们遇到需要输入验证码的情况时,我们可以手动输入验证码或者使用第三方打码平台自动识别验证码。常见的第三方打码平台包括云打码、超级鹰等。

在代码块中输入以下代码:

import requests

from bs4 import BeautifulSoup

from chaojiying import Chaojiying_Client

def get_verify_code(img_url):

r = requests.get(img_url, stream=True)

with open('verify_code.png','wb') as f:

for chunk in r.iter_content(chunk_size=1024):

if chunk:

f.write(chunk)

chaojiying = Chaojiying_Client('your_username','your_password','your_software_id')

im = open('verify_code.png','rb').read()

result = chaojiying.PostPic(im, 1902)

return result['pic_str']

def login(username, password):

driver = webdriver.Chrome()

driver.get('https://sso.toutiao.com/')

driver.find_element_by_name('username').send_keys(username)

driver.find_element_by_name('password').send_keys(password)

img_url = driver.find_element_by_css_selector('.yidun_bg-img').get_attribute('src')

verify_code = get_verify_code(img_url)

driver.find_element_by_name('captcha').send_keys(verify_code)

driver.find_element_by_class_name('btn-login').click()

time.sleep(5)

return driver

在代码中,我们使用requests库下载验证码图片,并使用超级鹰API识别验证码。然后将验证码输入到登录页面的验证码输入框中。

8、如何优化爬虫效率?

为了优化爬虫效率,我们可以采取以下措施:

(1)使用多线程或者异步IO方式进行爬取。

(2)使用缓存技术避免重复请求。

(3)设置合理的请求头,避免被封禁。

(4)使用代理IP或者轮换IP的方式,避免被封禁。

9、爬虫数据的存储和分析

爬虫获取到的数据需要进行存储和分析。常见的数据存储方式包括MySQL、MongoDB、Redis等。常见的数据分析工具包括Excel、Python中的pandas库、SQL等。

在代码块中输入以下代码:

import pymongo

def save_to_mongo(title, content):

client = pymongo.MongoClient('mongodb://localhost:27017/')

db = client['toutiao']

collection = db['articles']

article ={

'title': title,

'content': content

}

collection.insert_one(article)

if __name__=='__main__':

url ='https://www.toutiao.com/a7025120587649588231/'

title, content = get_article(url)

save_to_mongo(title, content)

在代码中,我们使用pymongo库将文章标题和内容保存到MongoDB数据库中。

10、注意事项和法律风险

在进行文章提取时,我们需要注意以下几点:

(1)不要过度提取,以免被封禁。

(2)尊重原创作者的版权,不要抄袭或者篡改文章内容。

(3)遵守相关法律法规,不要进行非法活动。

本文主要介绍了如何提取今日头条文章,包括常见的提取方法、使用Python和Selenium进行文章提取、如何处理反爬虫机制、如何优化爬虫效率以及爬虫数据的存储和分析。希望对大家有所帮助。