Python爬虫轻松获取知乎数据,阅读量翻倍!

优采云 发布时间: 2023-04-03 00:092023年04月03日,随着互联网的不断发展,大量的数据被存储在各种网站上。如何从这些网站中获取有用的信息呢?Python爬虫就是一种非常有效的方式。在本文中,将介绍如何使用Python爬虫轻松地爬取知乎数据,并通过优采云和SEO优化来提高文章的阅读量。

一、什么是Python爬虫?

Python爬虫是一种自动化采集网络数据的技术,可以模拟浏览器操作,获取网页中的数据,并进行处理和分析。Python爬虫具有高效、灵活、易学易用等特点,在各个领域都有广泛应用。

二、为什么要使用Python爬虫?

在信息化时代,大量的数据被存储在网络上,而且很多网站都没有提供API接口。如果需要获取这些数据,手动复制粘贴成本太高且效率低下。而使用Python爬虫可以轻松地实现自动化采集。

三、如何使用Python爬虫获取知乎数据?

1.确定目标

首先需要明确想要获取哪些数据。比如在知乎上搜索“Python”,我们可以获取到问题、回答、文章、用户等多种数据。

2.分析网页

使用Chrome等浏览器的开发者工具可以查看网页源代码,找到需要的信息所在的HTML标签和属性。在知乎搜索结果页面中,每个问题、回答、文章都是以卡片的形式展示,而卡片的HTML标签为div,class属性为Card。

3.编写代码

使用Python中的requests库获取网页源代码,然后使用BeautifulSoup库解析HTML,从而获取所需数据。代码如下:

python

import requests

from bs4 import BeautifulSoup

url ='https://www.zhihu.com/search?type=content&q=Python'

headers ={

'user-agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text,'html.parser')

cards = soup.find_all('div', class_='Card')

for card in cards:

#获取问题、回答、文章、用户等数据并进行处理

pass

四、如何防止被封IP?

在进行爬取时,需要注意不要频繁地请求同一个网站,否则很容易被封IP。可以设置请求头中的User-Agent和Referer等字段,模拟浏览器操作。

五、如何处理反爬措施?

有些网站会设置反爬措施,比如验证码、动态JS加载等。可以使用selenium库模拟浏览器操作,解决反爬问题。

六、如何存储爬取的数据?

获取到的数据可以保存到本地文件或者数据库中。常用的数据库有MySQL、MongoDB等。

七、如何进行SEO优化?

在文章标题、关键词、描述等位置适当地添加关键词,使用H1、H2等标题标签来强调关键词,合理分配关键词密度和排版格式,可以提高文章的排名和阅读量。

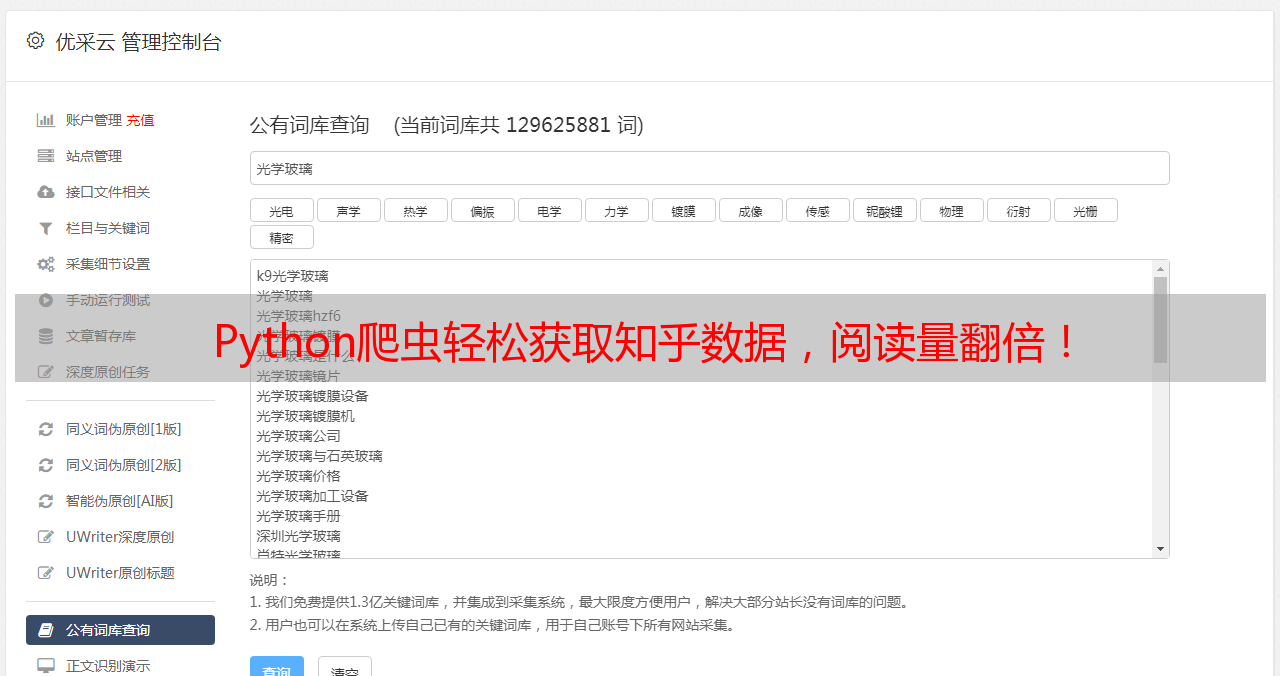

八、如何使用优采云提高文章质量?

优采云是一款专业的中文自然语言处理工具,可以帮助写作者进行拼写检查、语法检查、文本相似度比对等多种任务,提高文章质量。

九、结语

Python爬虫是一种非常实用的技术,在信息化时代具有广泛应用。通过本文的介绍,相信大家已经掌握了如何使用Python爬虫轻松地爬取知乎数据,并通过SEO优化和优采云来提高文章的质量。