Java爬虫模拟人操作,轻松爬取网页数据

优采云 发布时间: 2023-04-02 16:17在互联网时代,数据已经成为了一种非常宝贵的资源,而网络爬虫正是获取这些数据的重要途径。但是,许多网站都设置了反爬虫机制,对于简单的爬虫程序进行屏蔽,因此需要使用一些高级技术来模拟人类操作。本文将介绍如何使用Java语言开发爬虫程序,并通过模拟人类操作来实现数据的快速采集与处理。

一、Java语言开发爬虫程序

Java语言是一种功能强大的编程语言,具有良好的跨平台性和可移植性,在网络爬虫开发中也得到了广泛应用。我们可以使用Java语言编写一个简单的网络爬虫程序,首先需要导入相关的包:

import java.io.IOException;

import java.net.URL;

import java.util.Scanner;

然后,我们可以通过URL类来打开一个网页,并读取其中的内容:

public static String readUrl(String urlString) throws IOException {

String content = new Scanner(new URL(urlString).openStream(),"UTF-8").useDelimiter("\A").next();

return content;

}

二、模拟人类操作

对于简单的爬虫程序,很容易被网站屏蔽。因此,在进行网络爬虫开发时,需要模拟人类操作,使爬虫程序更加“智能化”。

1.模拟登录

有些网站需要用户登录才能访问某些页面,因此我们需要模拟用户登录。在Java中,我们可以使用HttpClient库来实现模拟登录:

import org.apache.http.HttpEntity;

import org.apache.http.HttpResponse;

import org.apache.http.NameValuePair;

import org.apache.http.client.HttpClient;

import org.apache.http.client.entity.UrlEncodedFormEntity;

import org.apache.http.client.methods.HttpPost;

import org.apache.http.impl.client.DefaultHttpClient;

import org.apache.http.message.BasicNameValuePair;

import java.util.ArrayList;

import java.util.List;

public static void login(String username, String password) throws Exception {

HttpClient httpClient = new DefaultHttpClient();

HttpPost httpPost = new HttpPost("http://www.example.com/login");

List<NameValuePair> nameValuePairs = new ArrayList<NameValuePair>();

nameValuePairs.add(new BasicNameValuePair("username", username));

nameValuePairs.add(new BasicNameValuePair("password", password));

httpPost.setEntity(new UrlEncodedFormEntity(nameValuePairs));

HttpResponse httpResponse = httpClient.execute(httpPost);

HttpEntity httpEntity = httpResponse.getEntity();

}

2.模拟鼠标点击与键盘输入

有些网站的交互界面采用了JavaScript技术,需要通过模拟鼠标点击与键盘输入来实现页面操作。在Java中,我们可以使用Selenium库来实现:

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.chrome.ChromeDriver;

public static void simulateMouseClick(){

WebDriver driver = new ChromeDriver();

driver.get("http://www.example.com");

WebElement element = driver.findElement(By.id("button"));

element.click();

}

3.模拟滚动操作

有些网站的数据需要进行滚动才能全部加载出来,因此我们需要模拟滚动操作。在Java中,我们可以使用JavaScriptExecutor接口来实现:

import org.openqa.selenium.JavascriptExecutor;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.chrome.ChromeDriver;

public static void simulateScroll(){

WebDriver driver = new ChromeDriver();

driver.get("http://www.example.com");

JavascriptExecutor js =(JavascriptExecutor) driver;

js.executeScript("window.scrollBy(0,1000)");

}

三、数据采集与处理

通过模拟人类操作,我们可以更加智能地获取网站数据。在获取到数据后,我们需要对其进行处理。

1.数据存储

我们可以将爬取到的数据存储到本地文件或数据库中。在Java中,我们可以使用JDBC接口来实现数据库存储:

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

public static void saveDataToDatabase(String data) throws SQLException {

Connection conn = DriverManager.getConnection("jdbc:mysql://localhost:3306/test","root","123456");

PreparedStatement pstmt = conn.prepareStatement("INSERT INTO data (content) VALUES (?)");

pstmt.setString(1, data);

pstmt.executeUpdate();

}

2.数据分析

对于大量的数据,我们需要进行数据分析,以便更好地挖掘其中的价值。在Java中,我们可以使用开源的数据分析库,如Apache Spark:

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

public static void analyzeData(){

SparkConf conf = new SparkConf().setAppName("Data Analysis").setMaster("local");

JavaSparkContext sc = new JavaSparkContext(conf);

JavaRDD<String> data = sc.textFile("/path/to/data");

long count = data.count();

}

综上所述,通过Java语言开发爬虫程序,并通过模拟人类操作来实现数据的快速采集与处理。在实际应用中,我们需要根据具体情况选择合适的技术方案,并注意遵守相关法律法规。

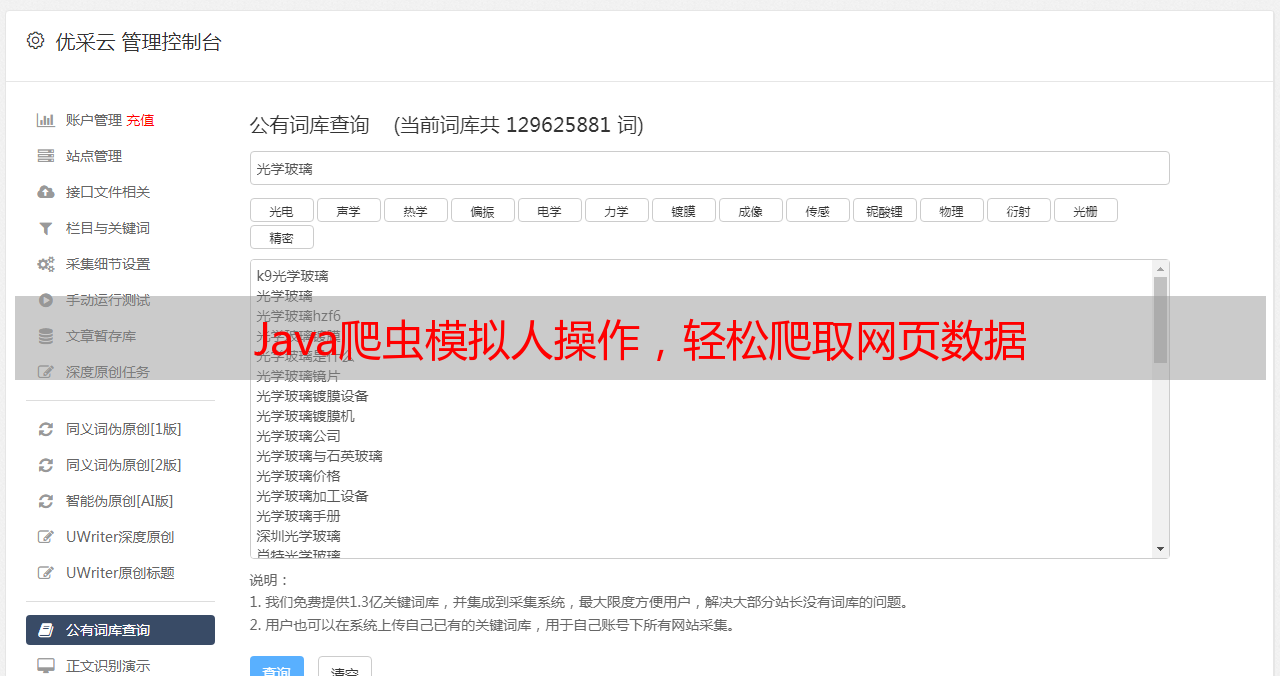

优采云(www.ucaiyun.com)是一家专注于提供网络爬虫服务的公司,提供高质量、高效率的数据采集与处理服务,同时还提供SEO优化等一系列增值服务。如果您需要进行网络爬虫开发或数据分析,欢迎联系我们!