每日轻松爬取微信公众号文章,最简易方法揭秘!

优采云 发布时间: 2023-04-02 15:17对于自媒体人来说,每天爬取微信公众号的推送文章是一项必备技能。但是,对于很多人来说,这似乎是一个非常复杂和困难的任务。那么,有没有一种最简单的方法可以实现这个目标呢?答案当然是肯定的!本文将详细介绍如何用最简单的方法实现每天爬取微信公众号的推送文章。

1.了解微信公众平台

在开始之前,我们需要了解一些关于微信公众平台的基本知识。微信公众平台是一个开放平台,允许企业、机构、个人等注册为公众号,并通过该平台向用户提供服务。在微信公众平台上,用户可以发布图文、语音、视频等多种类型的信息,并通过各种方式与用户进行互动。

2.安装Python

在开始使用Python爬虫之前,我们需要先安装Python环境。Python是一种流行的编程语言,广泛用于数据分析、科学计算和Web开发等领域。你可以从官方网站(https://www.python.org/downloads/)下载并安装Python。

3.安装必要的库

在使用Python进行爬虫之前,我们需要安装一些必要的库。这些库包括requests、beautifulsoup4、lxml和pandas等。你可以使用以下命令在终端中安装这些库。

pip install requests

pip install beautifulsoup4

pip install lxml

pip install pandas

4.获取微信公众平台的Cookie

在使用Python进行爬虫之前,我们需要获取微信公众平台的Cookie。Cookie是一种用于存储用户信息的小文件,通常由服务器发送给浏览器,并保存在本地计算机上。在微信公众平台上,Cookie用于验证用户身份和授权访问。

为了获取微信公众平台的Cookie,我们需要使用Chrome浏览器和Chrome插件EditThisCookie。你可以从Chrome网上应用商店(https://chrome.google.com/webstore/detail/editthiscookie/fngmhnnpilhplaeedifhccceomclgfbg)下载并安装该插件。

安装完成后,打开Chrome浏览器,并登录到微信公众平台。然后点击EditThisCookie图标,在弹出窗口中找到名为“wxuin”、“wxsid”、“wxloadtime”和“mm_lang”的Cookie,并将它们复制到一个文本文件中。

5.编写Python爬虫程序

现在,我们已经准备好编写Python爬虫程序了。下面是一个简单的Python爬虫程序示例:

python

import requests

from bs4 import BeautifulSoup

import pandas as pd

cookies ={

'wxuin':'',

'wxsid':'',

'wxloadtime':'',

'mm_lang':''

}

url ='https://mp.weixin.qq.com/mp/profile_ext?action=getmsg&__biz=MzU3NDA3OTY1NQ==&f=json&offset=0&count=10&is_ok=1&scene=124&uin=&key=&pass_ticket=&wxtoken=&appmsg_token=&x5=0&f=json'

headers ={

'Host':'mp.weixin.qq.com',

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36',

'Cookie':';'.join([f'{k}={v}' for k, v in cookies.items()])

}

res = requests.get(url, headers=headers).json()

articles =[]

for item in res['general_msg_list']['list']:

title = item['app_msg_ext_info']['title']

digest = item['app_msg_ext_info']['digest']

url = item['app_msg_ext_info']['content_url']

articles.append({'title': title,'digest': digest,'url': url})

df = pd.DataFrame.from_records(articles)

print(df)

这个程序使用requests和beautifulsoup4库从微信公众平台获取文章列表,并使用pandas库将结果保存为一个数据框。你可以根据需要修改代码,以适应不同的数据抓取需求。

6.使用定时任务执行爬虫程序

最后,我们需要设置一个定时任务来自动执行爬虫程序。在Linux系统中,我们可以使用crontab命令来设置定时任务。下面是一个示例定时任务:

0 0 ***/usr/bin/python /path/to/your/python/script.py >>/path/to/your/log/file.log 2>&1

这个定时任务将在每天午夜零点执行你的Python脚本,并将输出保存到日志文件中。

7.总结

本文介绍了如何用最简单的方法实现每天爬取微信公众号的推送文章。我们首先了解了微信公众平台的基本知识,然后安装必要的库和获取微信公众平台的Cookie。接着,我们编写了一个简单的Python爬虫程序,并使用定时任务自动执行该程序。希望这篇文章能够对你有所帮助!

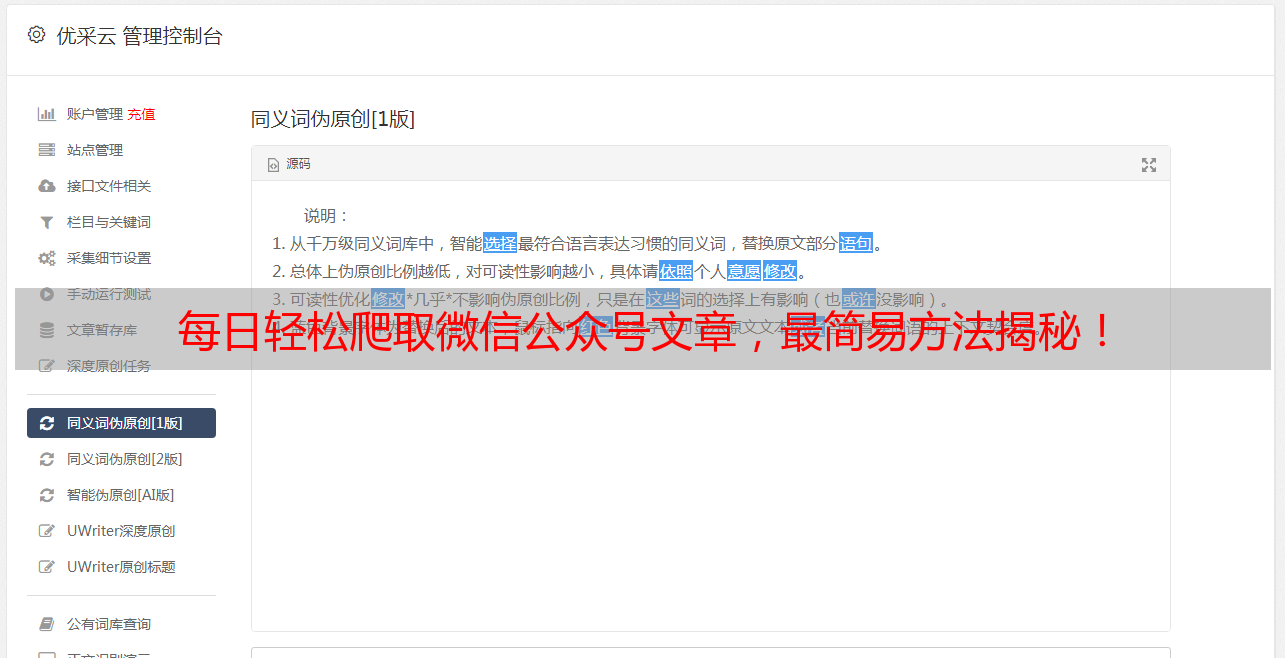

8.关于优采云

优采云是一家提供SEO优化服务的公司,专注于为企业提供高质量、高效率的SEO服务。如果您需要更好地优化您的网站,请访问我们的网站www.ucaiyun.com,以获取更多信息。