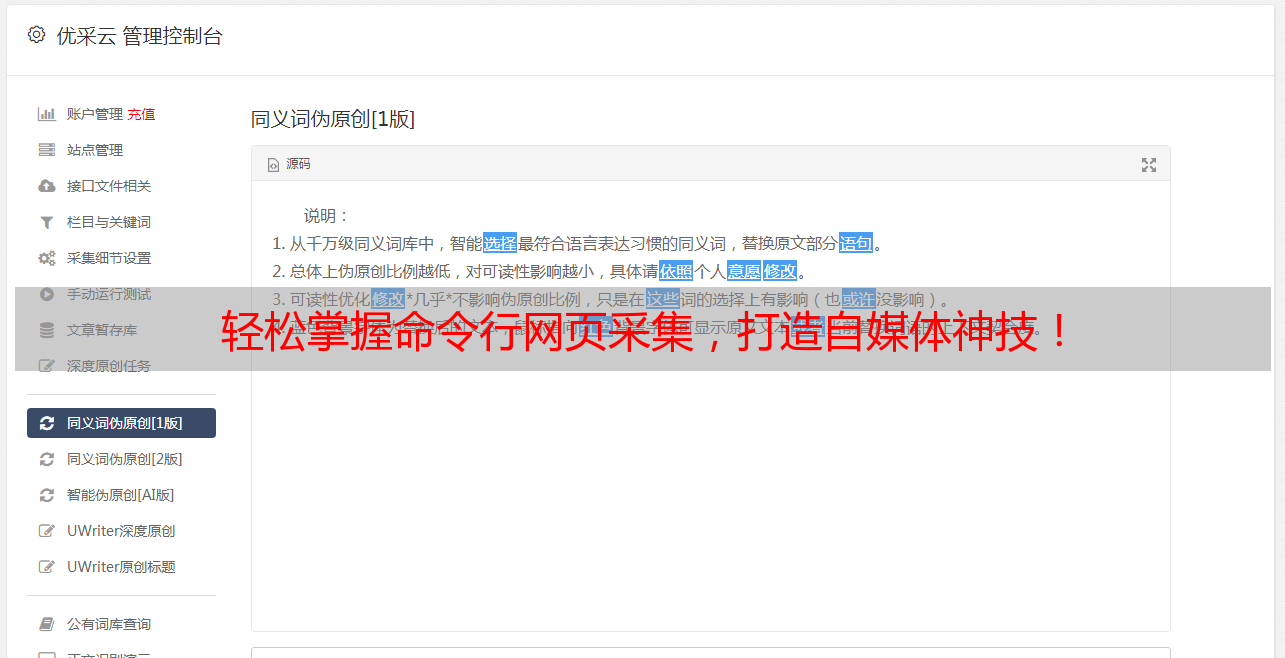

轻松掌握命令行网页采集,打造自媒体神技!

优采云 发布时间: 2023-04-01 23:102023年04月01日,UWriter为你带来一篇关于命令行网页采集的自媒体文章,让你轻松掌握这个神奇的技能。

一、什么是命令行网页采集?

命令行网页采集是指通过命令行终端工具,在不使用浏览器的情况下,获取网页数据的过程。它可以自动化地抓取大量数据,并且速度非常快。这种方式可以避免手动打开浏览器、点击等繁琐的操作,提高效率。

二、命令行网页采集的优点

1.效率高:相比手动操作或者使用爬虫框架,命令行网页采集更加快速高效。

2.节省资源:无需使用浏览器等软件,节省了计算机资源。

3.可定制性高:可以根据自己的需求进行定制,更加灵活。

4.易于扩展:可以结合其他工具进行扩展。

三、如何使用命令行进行网页采集?

1.安装curl:curl是一个命令行工具,用于传输数据。在Linux系统中,curl通常已经安装好了;在Windows系统中,则需要下载curl程序并将其添加到系统环境变量中。

2.使用curl命令:使用curl命令可以获取网页数据。例如,要获取百度首页的HTML代码,可以在终端中输入以下命令:

curl https://www.baidu.com

3.使用grep命令:grep是一个用于文本搜索的工具。可以使用grep命令从HTML代码中提取出需要的数据。例如,要从百度首页中提取出搜索框的HTML代码,可以在终端中输入以下命令:

curl https://www.baidu.com | grep -A 1 's_form'

四、如何进行网页采集优化?

1.选择合适的目标网站:选取合适的目标网站可以提高采集效率。

2.使用合适的抓取策略:不同的网站可能需要不同的抓取策略,需要根据实际情况进行调整。

3.设置合理的请求频率:设置合理的请求频率可以避免对目标网站造成过大压力。

4.使用代理IP:使用代理IP可以避免被目标网站封禁IP。

五、命令行网页采集案例

以下是一个简单的案例,使用curl和grep命令从豆瓣电影Top250页面中获取电影名称和评分。

curl https://movie.douban.com/top250 | grep '<span class="title">'| awk -F'[><]''{print