揭秘爬虫程序的局限:为何无法完全爬取JS内容?

优采云 发布时间: 2023-04-01 17:16众所周知,爬虫程序在网络数据采集中扮演着重要的角色。但是,随着前端技术的不断更新,越来越多的网站使用JavaScript来渲染页面,而传统的爬虫程序却无法获取这些通过JavaScript生成的内容。那么,为什么爬虫程序爬不全js呢?本文将从多个方面进行分析。

1. JavaScript动态加载

现在很多网站都采用JavaScript动态加载数据,而传统的爬虫程序只能获取到页面源代码中静态的HTML内容,无法获取通过JavaScript动态加载的内容。例如,在一个电商网站上,用户滚动页面时会自动加载更多商品信息,这些信息就是通过JavaScript生成并添加到页面中的。此时,传统爬虫程序只能获取到最初加载出来的商品信息,无法获取后续动态加载出来的内容。

2. JavaScript加密

为了防止被爬虫程序抓取数据,一些网站还采用了JavaScript加密技术。例如,在一个需要登录才能查看的网站上,可能会使用JavaScript对部分数据进行加密处理,只有在用户登录后才会解密显示出来。这样一来,传统爬虫程序就无法直接获取到加密过后的数据。当然,通过分析JavaScript代码,我们还是可以破解这种加密方式的。

3. AJAX异步请求

很多网站使用AJAX技术进行异步请求,这样就可以在不刷新整个页面的情况下获取到新的数据。传统爬虫程序无法模拟这种异步请求,因此也就无法获取到通过AJAX获取到的数据。

4.反爬虫机制

为了防止被恶意爬虫程序抓取数据,一些网站还采用了反爬虫机制。例如,在一些网站上,如果用户访问过于频繁,就会出现验证码或者封禁IP等情况。当然,这些反爬虫措施对于真正需要获取数据的用户来说也是一种阻碍。

5.人工智能识别

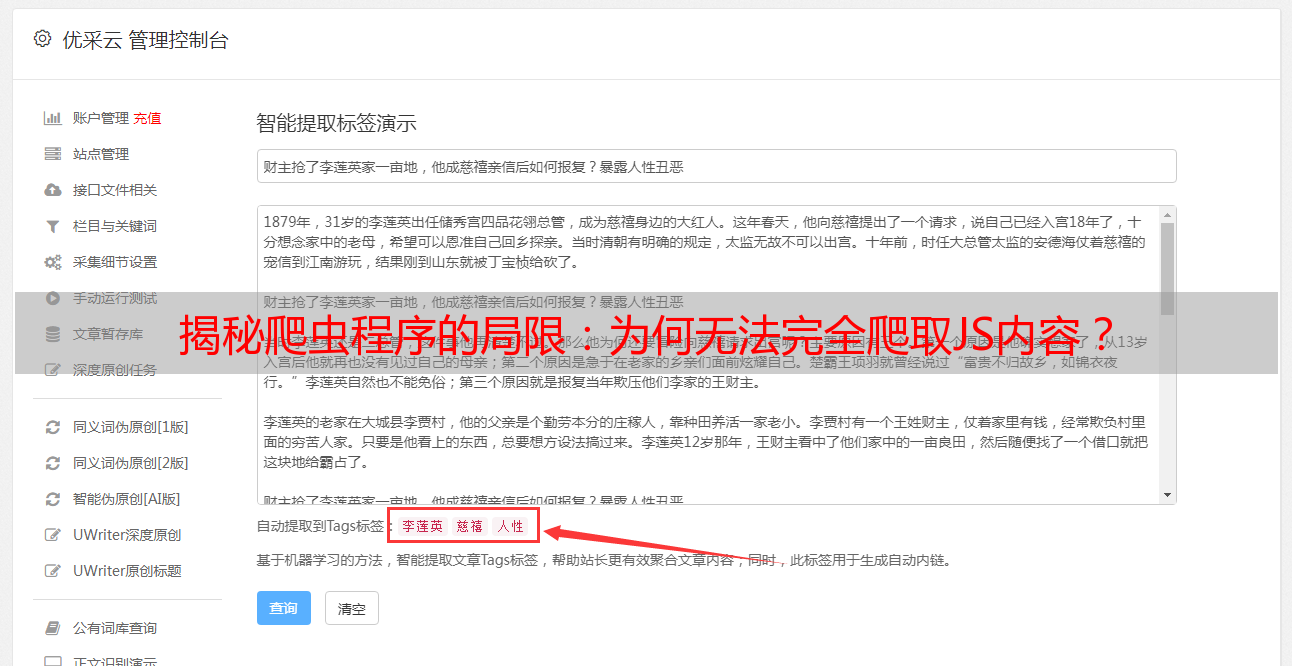

随着人工智能技术的不断发展,一些网站也开始使用AI进行内容生成和识别。例如,在一个新闻网站上,可能会使用AI自动生成文章摘要和标签等信息。这些信息是通过AI算法生成的,并非静态的HTML内容,因此传统爬虫程序也无法获取到。

6.解决方案

那么,如何解决爬虫程序爬不全js的问题呢?以下是几种常见的解决方案:

(1)使用无界面浏览器,例如PhantomJS、Selenium等,模拟用户行为获取数据。

(2)分析网站的JavaScript代码,找到数据生成的关键代码,并模拟执行这些代码。

(3)通过API获取数据。一些网站提供了API接口,可以直接通过API获取数据。

(4)使用第三方工具,例如爬虫框架Scrapy、数据抓取工具Octoparse等。

综上所述,爬虫程序爬不全js的原因有很多,但是我们也可以采用多种方式来解决这个问题。无论是开发人员还是数据分析师,都需要深入了解前端技术和爬虫程序的相关知识,才能更好地应对数据采集和分析的挑战。

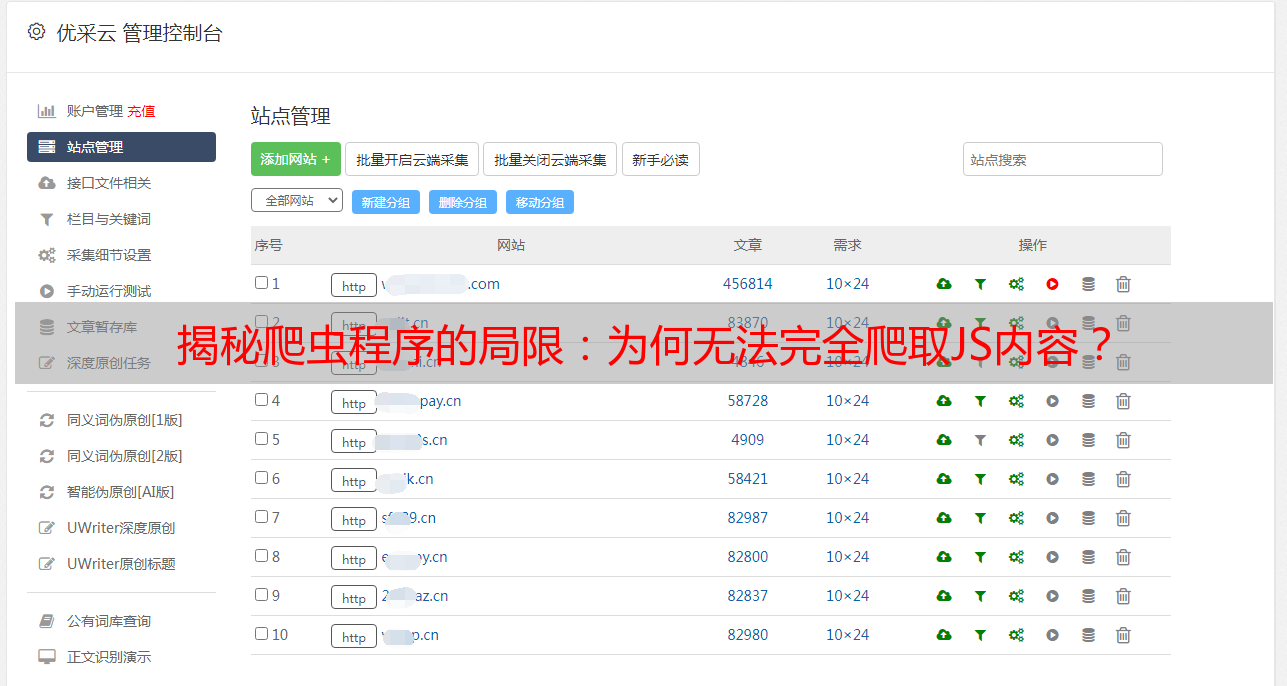

本文由优采云提供SEO优化支持。优采云是一家专业的数据采集和处理平台,致力于为用户提供高效、稳定、可靠的数据服务。想要了解更多信息,请访问我们的官网:www.ucaiyun.com。