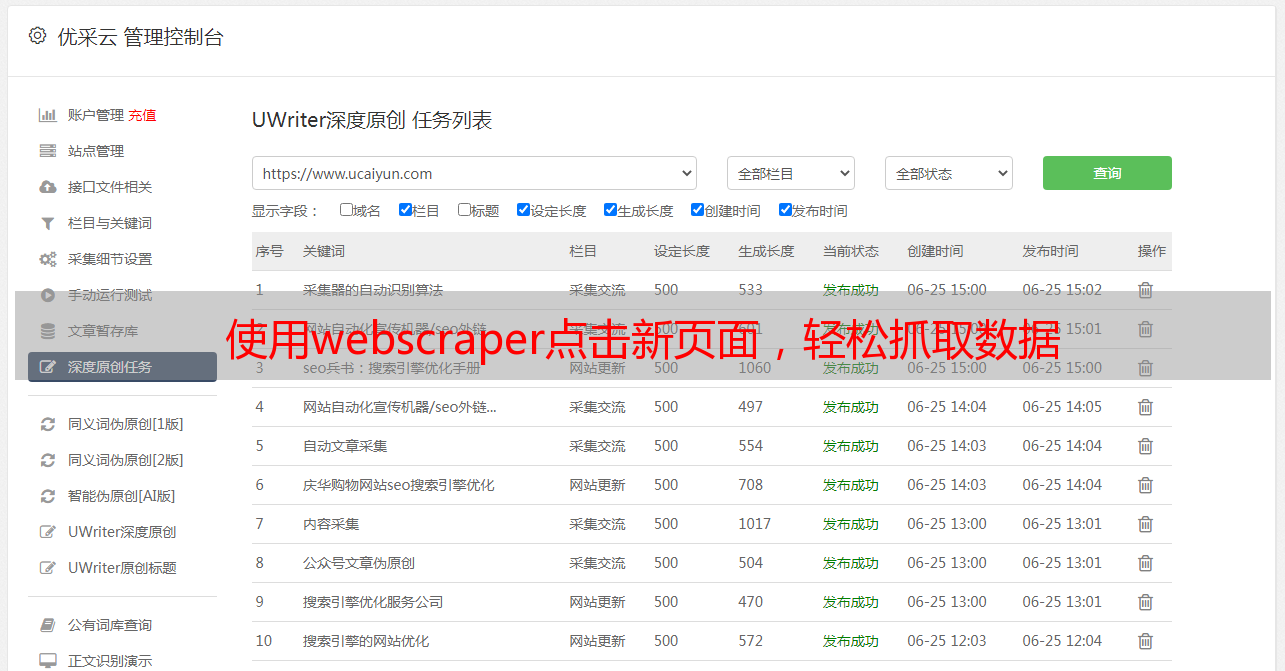

使用webscraper点击新页面,轻松抓取数据

优采云 发布时间: 2023-04-01 06:08在如今这个信息爆炸的时代,数据是一种非常宝贵的资源。因此,数据爬取技术也越来越受到人们的重视。webscraper是一款强大的数据爬取工具,使用它可以很方便地抓取网页上的数据。但是,有些网站需要点击某个链接才能跳转到下一个页面,这时候怎样用webscraper点击新页面抓取呢?本文将为您详细介绍。

一、webscraper简介

webscraper是一个基于浏览器插件的数据爬取工具,它可以在Chrome和Firefox浏览器上运行。使用这个工具可以快速地抓取网页上的数据,并且不需要编写任何代码。

二、webscraper点击新页面抓取方法

1.安装webscraper插件

首先,在Chrome或Firefox浏览器上安装webscraper插件。安装完毕后,在浏览器右上角会出现一个小图标。

2.创建一个新项目

打开您要爬取数据的网站,并单击浏览器右上角的webscraper图标。选择“创建新项目”并输入名称和起始网址。

3.选择元素

在“选择元素”选项卡中,单击要抓取的元素。如果您要抓取多个元素,请选择“多个元素”选项。

4.添加链接

如果您要抓取需要点击链接才能跳转到下一个页面的网站,可以使用“添加链接”选项。在该选项卡中,单击“添加链接”,然后输入要点击的链接的CSS选择器或XPath表达式。

5.配置新页面

在“配置新页面”选项卡中,可以设置新页面的名称、网址和元素。如果您要抓取多个元素,请选择“多个元素”选项。

6.运行爬虫

单击工具栏中的“运行爬虫”按钮,webscraper将开始抓取数据并将其保存在CSV文件中。

7.优化爬虫

webscraper还提供了许多其他功能,例如定时自动运行爬虫、导出数据、使用代理服务器等。这些功能可以帮助您更好地优化爬虫。

8. webscraper代码示例

如果您想使用webscraper代码来实现点击新页面抓取,以下是一些示例代码:

python

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

#创建浏览器对象

browser = webdriver.Chrome()

#打开网站

browser.get("https://www.example.com")

#等待元素加载完成

wait = WebDriverWait(browser, 10)

element = wait.until(EC.presence_of_element_located((By.CSS_SELECTOR,".example")))

#点击链接

element.click()

#切换到新页面

browser.switch_to.window(browser.window_handles[1])

#等待新页面元素加载完成

element = wait.until(EC.presence_of_element_located((By.CSS_SELECTOR,".example")))

#抓取数据

data = element.text

#关闭浏览器

browser.quit()

9.总结

使用webscraper可以很方便地抓取网页上的数据,而且不需要编写任何代码。如果您要抓取需要点击链接才能跳转到下一个页面的网站,可以使用“添加链接”选项,并在“配置新页面”选项卡中设置新页面的名称、网址和元素。同时,webscraper还提供了许多其他功能,例如定时自动运行爬虫、导出数据、使用代理服务器等。希望本文对您有所帮助。