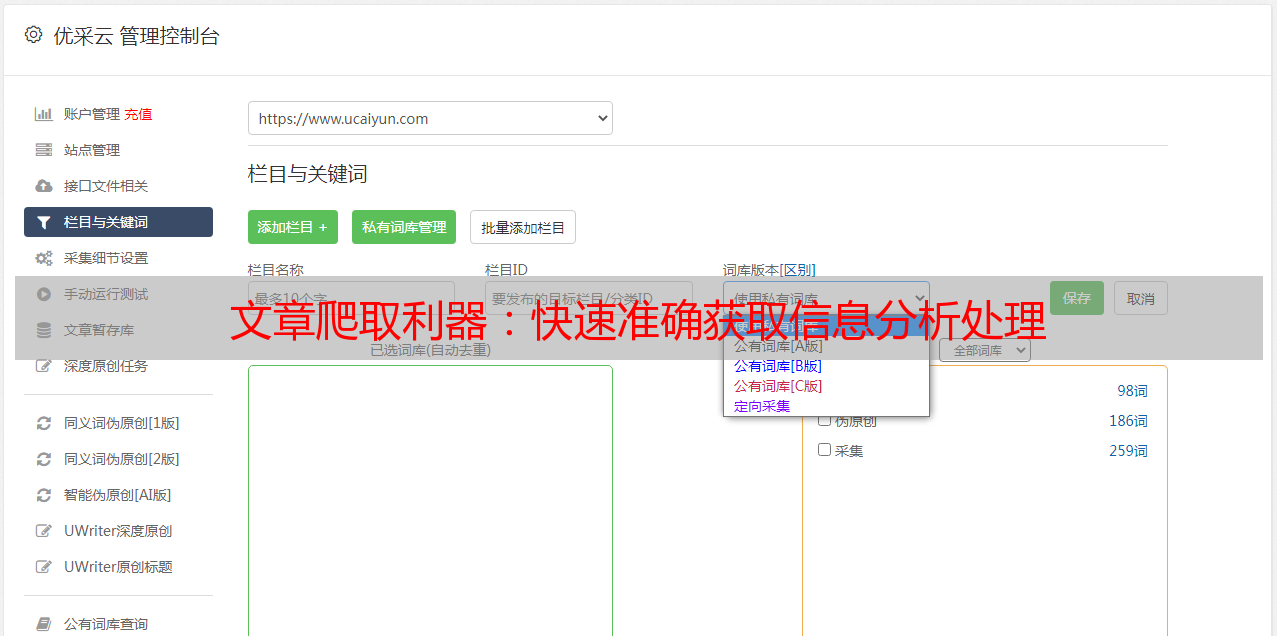

文章爬取利器:快速准确获取信息分析处理

优采云 发布时间: 2023-03-31 20:17随着互联网时代的到来,人们可以通过各种渠道来获取信息,而自媒体平台则成为了一个非常重要的信息来源。然而,对于自媒体作者来说,如何快速、准确地获取信息并进行分析处理是非常关键的。本文将从以下九个方面逐步分析讨论文章爬取的必要性、方法和技巧,帮助自媒体作者更好地进行信息收集与处理。

一、文章爬取的必要性

在互联网时代,信息量巨大,每天都有海量的文章被发布,这些文章包含了各种行业、领域的知识和资讯。自媒体作者需要快速获取这些信息,并进行筛选整理。而传统的手动搜索方法效率低下且不准确,因此文章爬取成为了一种必要的方式。

二、网络爬虫的基本原理

网络爬虫是一种程序,它可以自动地浏览互联网上的页面,并将页面中的数据进行提取和分析。其基本原理是通过发送HTTP请求获取网页HTML代码,然后解析HTML代码中的内容,并提取出所需数据。

三、Python编程语言介绍

Python是一种高级编程语言,它具有简单易学、功能强大、可扩展性好等特点。在文章爬取中,Python是一种非常常用的编程语言,因为它有着大量的网络爬虫库和框架,如BeautifulSoup、Scrapy等。

四、BeautifulSoup库的使用

BeautifulSoup是Python中一个非常流行的HTML解析库,它可以将HTML代码转换成Python对象,并提供了一些方便的方法来获取和操作页面元素。使用BeautifulSoup可以快速地对网页内容进行解析和提取。

python

#示例代码

from bs4 import BeautifulSoup

import requests

url ='https://www.ucaiyun.com'

response = requests.get(url)

soup = BeautifulSoup(response.text,'html.parser')

print(soup.title.string)

五、Scrapy框架的使用

Scrapy是Python中一个基于Twisted框架开发的网络爬虫框架,它可以快速地构建高效、稳定的网络爬虫程序。使用Scrapy可以方便地定义爬虫规则和数据抓取流程。

python

#示例代码

import scrapy

class UcaiyunSpider(scrapy.Spider):

name ="ucaiyun"

start_urls =[

'https://www.ucaiyun.com',

]

def parse(self, response):

for title in response.css('h2.entry-title'):

yield {

'title': title.css('a::text').get(),

}

六、反爬机制及应对策略

由于文章爬取的存在,一些网站会采取反爬机制来防止爬虫程序的访问。这些反爬机制包括IP限制、User-Agent识别、验证码等。为了应对这些反爬机制,我们可以采取一些策略,如使用代理IP、伪装User-Agent、模拟人工操作等。

七、数据存储与处理

文章爬取得到的数据需要进行存储和处理,以便后续分析和利用。常见的数据存储方式有MySQL、MongoDB等数据库,也可以将数据保存在本地文件中。在数据处理方面,可以使用Pandas等数据分析工具进行清洗和分析。

八、SEO优化与文章爬取

作为自媒体作者,除了获取信息外,如何让自己的文章被更多人看到也是非常重要的。因此,在文章爬取的过程中,我们需要注意SEO优化技巧,如选择合适的关键词、优化标题和描述等。

九、结语

文章爬取是自媒体作者必备的技能之一,在信息获取和内容创作方面有着不可替代的作用。通过本文的介绍,相信读者已经了解了文章爬取的基本原理、方法和技巧,并能够更好地运用到自己的工作中。如果需要更多帮助和指导,可以关注优采云并访问其官网www.ucaiyun.com,了解更多信息和服务。