自媒体爬虫攻略:基础知识、工具与数据获取

优采云 发布时间: 2023-03-31 15:22自媒体的发展离不开数据的支撑,而爬虫技术是获取数据的一种重要手段。本文将从多个方面介绍自媒体如何利用爬虫获取数据,包括爬虫基础知识、爬虫工具的选择、反爬策略、数据存储和分析等方面。

一、爬虫基础知识

1.1什么是爬虫

简单来说,爬虫就是模拟浏览器行为,将网页上的数据抓取下来。通过网络请求获取网页内容,再对内容进行解析,提取出需要的数据。

1.2爬虫工作原理

爬虫主要由网络请求、解析和存储三个部分组成。首先发送请求获取网页内容,然后对内容进行解析提取有用信息,并将其存储在数据库或文件中。

1.3爬虫常用库和框架

Python语言中最常用的爬虫库是requests、beautifulsoup和scrapy。其中requests负责网络请求,beautifulsoup负责解析HTML/XML文档,scrapy则是一个完整的Web抓取框架。

二、选择合适的爬虫工具

2.1 Scrapy框架

Scrapy是一个Python语言编写的开源网络爬虫框架,可以帮助我们快速开发爬虫程序。通过Scrapy框架,我们可以轻松地实现爬虫的自动化和高效化。

2.2 Selenium

Selenium是一款自动化测试工具,也可以用来做爬虫。相比于其他爬虫工具,Selenium更加灵活,可以模拟浏览器行为,同时也可以处理JavaScript等动态内容。

2.3 PySpider

PySpider是一个Python语言编写的强大的Web爬虫系统,它采用了分布式架构和消息队列技术,能够快速高效地抓取数据,并支持数据可视化和导出等功能。

三、反爬策略

3.1 User-Agent伪装

User-Agent是HTTP请求头中的一个字段,代表浏览器或客户端的身份信息。有些网站会根据User-Agent来识别是否为机器人访问,因此我们可以设置合适的User-Agent来伪装成浏览器身份。

3.2 IP代理池

有些网站会限制同一IP地址频繁访问,因此我们可以使用IP代理池来切换IP地址。通过调用代理池接口获取可用的代理IP地址,并设置请求头中的代理IP地址。

四、数据存储

4.1 MySQL数据库

MySQL是一种关系型数据库管理系统,可以用来存储结构化数据。通过Python语言中的pymysql库,我们可以轻松地连接MySQL数据库,并将数据存储到其中。

4.2 MongoDB数据库

MongoDB是一种非关系型文档数据库,可以用来存储半结构化和非结构化数据。通过Python语言中的pymongo库,我们可以轻松地连接MongoDB数据库,并将数据存储到其中。

五、数据分析

5.1 Pandas库

Pandas是一个强大的数据处理和分析工具,可以用来处理各种格式的数据。通过Pandas库,我们可以对爬取到的数据进行清洗、转换和统计分析等操作。

5.2 Matplotlib库

Matplotlib是一个Python语言编写的绘图库,可以用来生成各种类型的图表。通过Matplotlib库,我们可以将分析结果可视化展示出来。

六、案例分析

以某新闻网站为例,使用Scrapy框架编写爬虫程序,爬取新闻标题、发布时间和内容等信息,并将其存储到MySQL数据库中。然后使用Pandas和Matplotlib库对爬取到的数据进行清洗和统计分析,并生成柱状图展示统计结果。

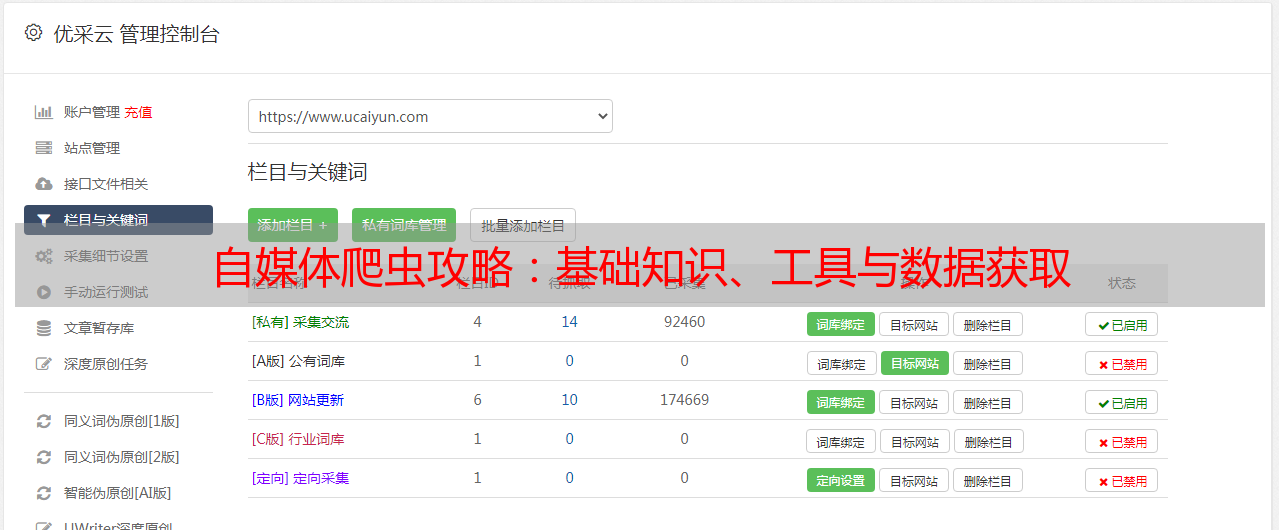

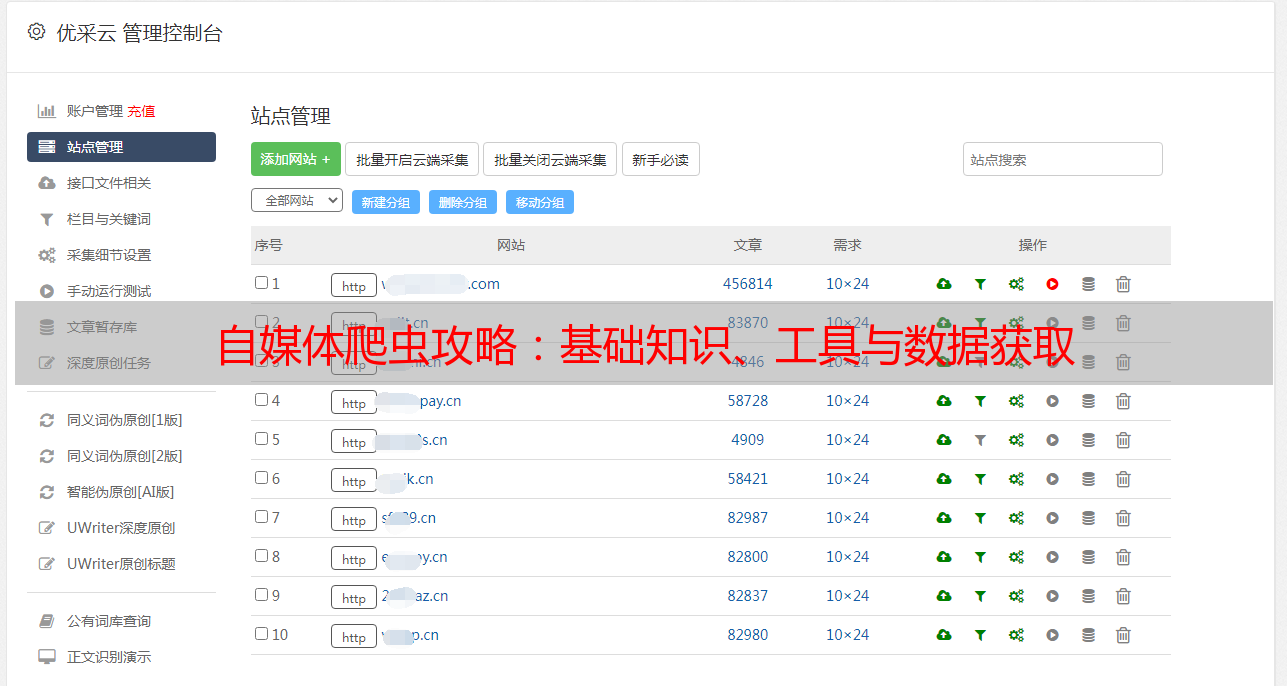

七、优采云

优采云是一家专业的互联网营销服务提供商,提供SEO优化、SEM广告投放、社交媒体营销等全方位的互联网营销服务。如果您在自媒体运营中遇到了问题,可以考虑选择优采云提供的优质服务。

八、SEO优化

SEO是指通过搜索引擎优化技术,提升网站在搜索引擎中的排名,增加网站曝光量和流量。自媒体在进行SEO优化时,需要注意关键词的选择、内容质量和外链建设等方面。

九、结语

本文介绍了自媒体如何利用爬虫获取数据的相关知识和技术,并举例说明了爬虫程序的编写和数据分析过程。希望对自媒体从业者有所帮助。如果您想要了解更多关于互联网营销方面的知识,请访问优采云官网www.ucaiyun.com。