高效爬虫技巧:处理jQuery数据轻松抓取网络信息

优采云 发布时间: 2023-03-30 17:23在网络数据采集与处理中,爬虫技术已经成为了必备的工具。而对于网站中使用jQuery技术进行数据展示的情况,如何抓取和处理这些数据呢?本文将从以下10个方面进行详细讨论。

1.网页分析:分析目标网页结构,理解jQuery选择器、DOM操作等基础知识。

2.爬虫框架:选择合适的爬虫框架,如Scrapy、Beautiful Soup等。

3.请求发送:使用框架发送请求获取网页源代码。

4.数据解析:利用框架对网页源代码进行解析,获取需要的数据。

5.数据清洗:清洗数据,去除无用信息,格式化数据。

6.数据存储:将清洗后的数据存储到数据库或文件中。

7.定时任务:使用定时任务实现自动化处理。

8.反爬策略:应对网站反爬措施,如设置请求头、使用代理IP等。

9.代码优化:对爬虫代码进行优化,提高效率和稳定性。

10.部署上线:将爬虫部署上线,并进行监控和维护。

以某电商网站为例,我们可以通过以下步骤实现商品信息的自动化处理:

1.网页分析:分析商品详情页结构,使用jQuery选择器定位需要的数据。

2.爬虫框架:使用Scrapy框架进行开发。

3.请求发送:使用Scrapy发送请求获取商品详情页源代码。

import scrapy

class ProductSpider(scrapy.Spider):

name ='product'

start_urls =['https://www.example.com/product/12345']

def parse(self, response):

data ={}

data['name']= response.css('h1.product-name::text').extract_first().strip()

data['price']= response.css('span.price::text').extract_first().strip()

#...

yield data

4.数据解析:使用Scrapy的CSS选择器对网页源代码进行解析,获取商品名称、价格等信息。

5.数据清洗:清洗数据,格式化价格信息。

class PricePipeline(object):

def process_item(self, item, spider):

price_str = item['price']

item['price']= float(price_str.replace('$',''))

return item

6.数据存储:将清洗后的数据存储到MySQL数据库中。

import pymysql

class MysqlPipeline(object):

def __init__(self, mysql_host, mysql_port, mysql_db, mysql_user, mysql_password):

self.mysql_host = mysql_host

self.mysql_port = mysql_port

self.mysql_db = mysql_db

self.mysql_user = mysql_user

self.mysql_password = mysql_password

@classmethod

def from_crawler(cls, crawler):

return cls(

mysql_host=crawler.settings.get('MYSQL_HOST'),

mysql_port=crawler.settings.get('MYSQL_PORT'),

mysql_db=crawler.settings.get('MYSQL_DB'),

mysql_user=crawler.settings.get('MYSQL_USER'),

mysql_password=crawler.settings.get('MYSQL_PASSWORD')

)

def open_spider(self, spider):

self.conn = pymysql.connect(

host=self.mysql_host,

port=self.mysql_port,

db=self.mysql_db,

user=self.mysql_user,

password=self.mysql_password,

charset='utf8mb4',

cursorclass=pymysql.cursors.DictCursor

)

self.cursor = self.conn.cursor()

def close_spider(self, spider):

self.conn.close()

def process_item(self, item, spider):

sql ="INSERT INTO products (name, price) VALUES (%s,%s)"

values =(item['name'], item['price'])

self.cursor.execute(sql, values)

self.conn.commit()

return item

7.定时任务:使用Python的调度库APScheduler实现每天定时运行爬虫。

from apscheduler.schedulers.blocking import BlockingScheduler

sched = BlockingScheduler()

@sched.scheduled_job('cron', day_of_week='mon-fri', hour=8)

def run_spider():

process = CrawlerProcess(get_project_settings())

process.crawl('product')

process.start()

sched.start()

8.反爬策略:设置请求头,使用代理IP等方式应对反爬措施。

class ProxyMiddleware(object):

def __init__(self, proxy_url):

self.proxy_url = proxy_url

@classmethod

def from_crawler(cls, crawler):

return cls(

proxy_url=crawler.settings.get('PROXY_URL')

)

def process_request(self, request, spider):

proxy = requests.get(self.proxy_url).text.strip()

request.meta['proxy']='http://'+ proxy

9.代码优化:使用异步框架、多线程等方式提高爬虫效率和稳定性。

from twisted.internet import reactor, defer

from scrapy.crawler import CrawlerRunner

from scrapy.utils.log import configure_logging

configure_logging()

@defer.inlineCallbacks

def crawl():

runner = CrawlerRunner(get_project_settings())

yield runner.crawl('product')

reactor.stop()

crawl()

reactor.run()

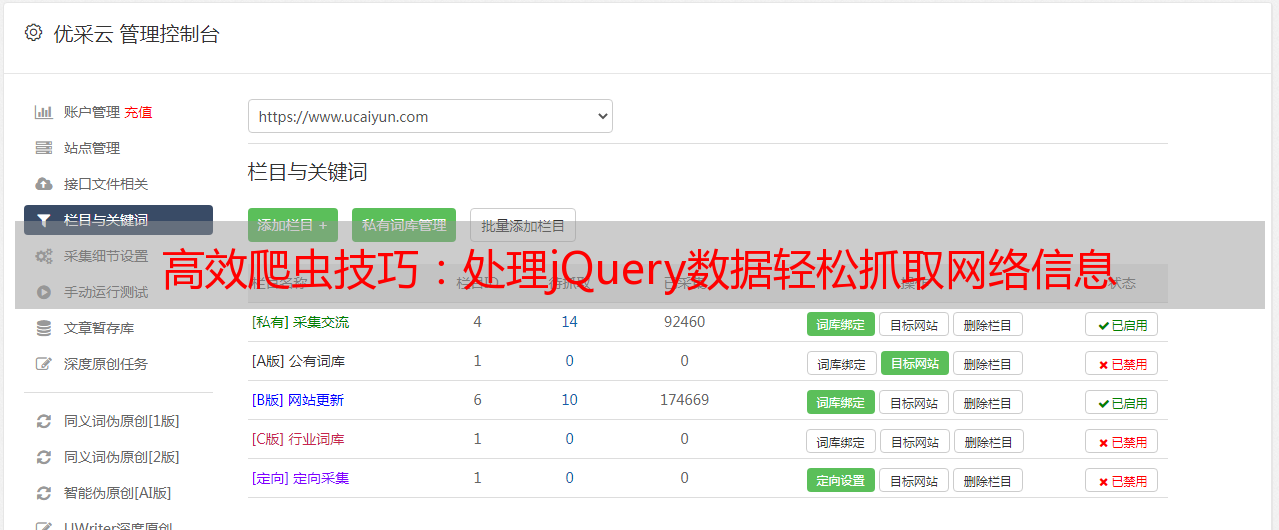

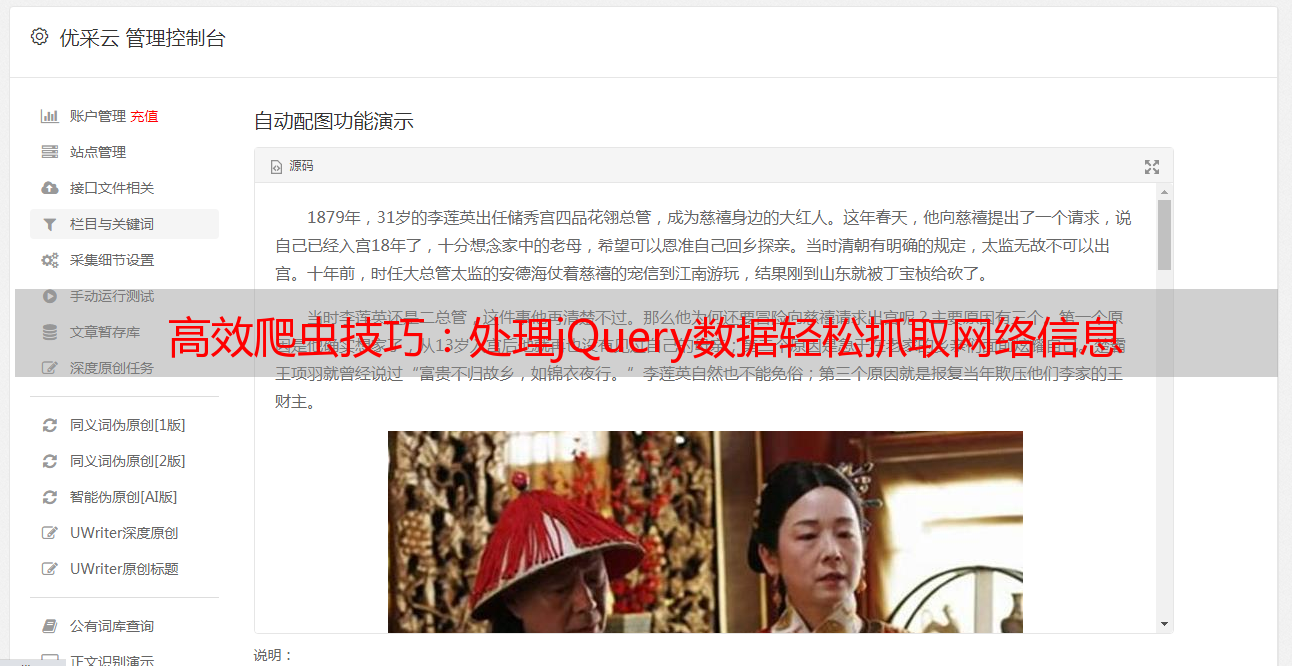

10.部署上线:将爬虫部署到云服务器上,并使用优采云进行SEO优化。

通过以上步骤,我们可以实现对jQuery数据的自动化处理,从而提高数据采集和处理的效率。同时,我们也需要注意网站反爬措施和法律合规问题,遵守网络道德和法律法规。