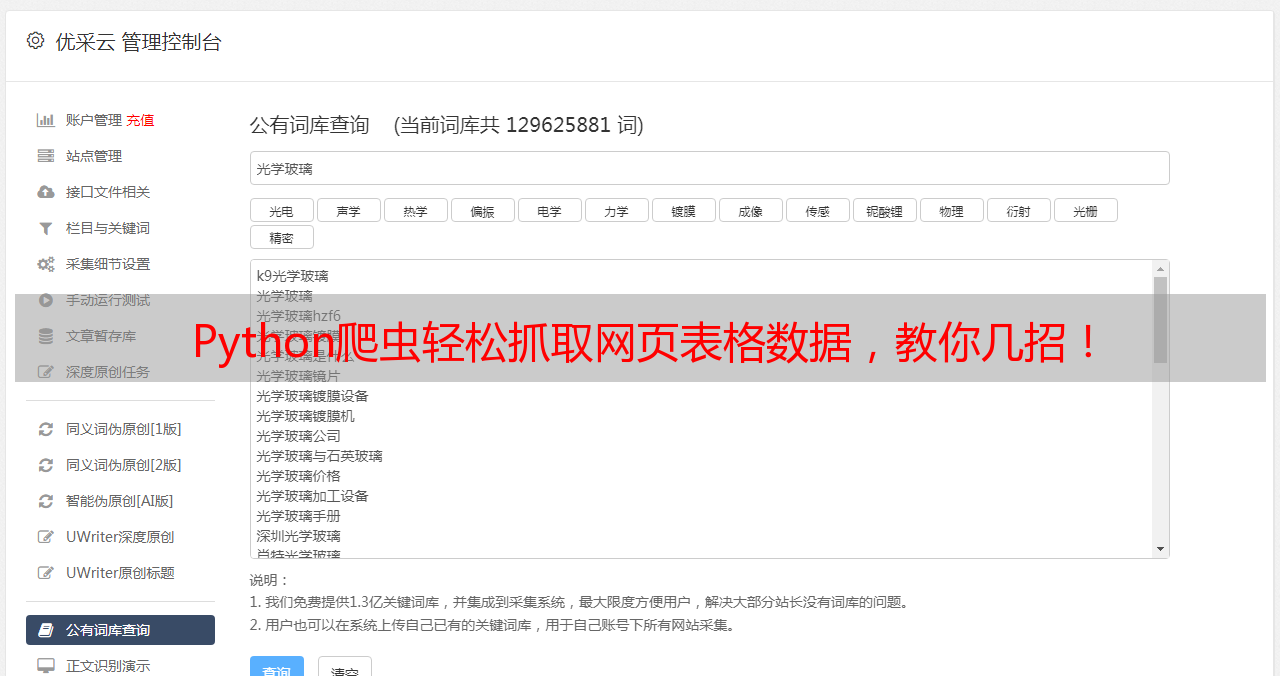

Python爬虫轻松抓取网页表格数据,教你几招!

优采云 发布时间: 2023-03-30 11:22Python爬虫已经成为了数据采集和处理的重要工具之一,它可以自动化地获取互联网上的数据并进行处理。在实际应用中,我们经常需要从网页中抓取一些表格数据,这就需要使用Python爬虫技术来实现。本文将介绍如何使用Python爬虫获取网页上的表格数据。

一、什么是Python爬虫?

Python爬虫是指利用Python编写程序,自动化地从互联网上获取各种信息的过程。通过网络爬虫技术,我们可以获取到各种网页上的内容,并进行处理和分析。Python爬虫技术已经广泛应用于数据采集、搜索引擎优化(SEO)、舆情监控等领域。

二、Python爬虫页面几个表格如何爬取?

在实际应用中,我们经常需要从网页中获取表格数据。下面将介绍如何使用Python爬虫技术来抓取网页上的几个表格数据。

1.使用BeautifulSoup库解析HTML

BeautifulSoup是一个Python库,它可以帮助我们解析HTML文档。在使用BeautifulSoup库之前,我们需要先安装它:

#安装BeautifulSoup

pip install beautifulsoup4

安装完成后,在Python中可以使用如下代码来解析HTML文档:

#导入BeautifulSoup库

from bs4 import BeautifulSoup

#解析HTML文档

soup = BeautifulSoup(html_doc,'html.parser')

其中,`html_doc`是一个包含HTML文档的字符串。

2.获取表格数据

在使用BeautifulSoup解析HTML文档后,我们可以使用它提供的方法来获取表格数据。例如,下面的代码可以获取一个网页上的第一个表格:

#获取第一个表格

table = soup.find('table')

#获取表头和表格内容

thead = table.find('thead')

tbody = table.find('tbody')

#获取表头行和表格内容行

head_rows = thead.find_all('tr')

body_rows = tbody.find_all('tr')

#遍历表头行和表格内容行

for row in head_rows + body_rows:

#获取每行中的单元格

cells = row.find_all('td')

#输出单元格内容

for cell in cells:

print(cell.text)

这段代码将输出第一个表格中所有单元格的内容。

3.解决编码问题

在Python爬虫中,经常会遇到编码问题。为了避免编码问题,我们可以在请求页面时指定编码格式。例如,下面的代码可以请求一个页面并指定编码格式为UTF-8:

import requests

url ='http://example.com'

response = requests.get(url, headers={'User-Agent':'Mozilla/5.0'}, timeout=30)

response.encoding ='utf-8'

html_doc = response.text

4.处理分页

有些网站的表格数据可能分布在多个页面上。在这种情况下,我们需要处理分页问题。例如,下面的代码可以抓取一个网站上的多个页面中的表格数据:

import requests

from bs4 import BeautifulSoup

url_template ='http://example.com/page/{}'

page_count = 10

for page in range(1, page_count+1):

url = url_template.format(page)

response = requests.get(url, headers={'User-Agent':'Mozilla/5.0'}, timeout=30)

response.encoding ='utf-8'

html_doc = response.text

soup = BeautifulSoup(html_doc,'html.parser')

#获取表格数据...

其中,`url_template`是一个包含页码变量的URL模板,`page_count`是要抓取的页面总数。

5.处理动态加载数据

有些网站使用JavaScript来动态加载表格数据。在这种情况下,我们需要使用Selenium等工具来模拟浏览器行为,并获取动态加载的数据。例如,下面的代码可以使用Selenium来获取一个网站上的动态加载数据:

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

chrome_options = Options()

chrome_options.add_argument('--headless')

driver = webdriver.Chrome(options=chrome_options)

url ='http://example.com'

driver.get(url)

html_doc = driver.page_source

soup = BeautifulSoup(html_doc,'html.parser')

#获取动态加载的表格数据...

6.处理登录问题

有些网站需要登录才能访问表格数据。在这种情况下,我们需要使用模拟登录的方法来获取表格数据。例如,下面的代码可以使用Selenium来模拟登录并获取一个网站上的表格数据:

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

chrome_options = Options()

chrome_options.add_argument('--headless')

driver = webdriver.Chrome(options=chrome_options)

url_login ='http://example.com/login'

url_table ='http://example.com/table'

driver.get(url_login)

#输入用户名和密码...

driver.find_element_by_name('username').send_keys('your_username')

driver.find_element_by_name('password').send_keys('your_password')

#提交登录表单...

driver.find_element_by_name('submit').click()

driver.get(url_table)

html_doc = driver.page_source

soup = BeautifulSoup(html_doc,'html.parser')

#获取表格数据...

7.处理反爬虫问题

有些网站为了防止被爬虫抓取数据,会采取一些反爬虫措施,例如限制访问频率、使用验证码等。在这种情况下,我们需要使用一些技巧来规避反爬虫措施。例如,可以使用代理IP来隐藏爬虫的真实IP地址,或者使用逆向工程技术来破解验证码。

8.数据处理与存储

获取到表格数据后,我们可以使用Python的Pandas库来进行数据处理和分析。例如,下面的代码可以将表格数据转换为Pandas的DataFrame对象:

import pandas as pd

#将表格数据转换为DataFrame对象

df = pd.read_html(str(table))[0]

如果需要将数据存储到数据库中,可以使用Python的SQLAlchemy库来实现。例如,下面的代码可以将表格数据存储到MySQL数据库中:

from sqlalchemy import create_engine

#创建数据库连接

engine = create_engine('mysql+pymysql://username:password@host/database')

#将DataFrame写入MySQL数据库

df.to_sql('table_name', engine, if_exists='replace')

9.总结

本文介绍了如何使用Python爬虫技术来获取网页上的表格数据。具体来说,我们介绍了如何使用BeautifulSoup库解析HTML、获取表格数据、解决编码问题、处理分页、处理动态加载数据、处理登录问题、处理反爬虫问题、数据处理与存储等方面的内容。希望本文对大家学习Python爬虫技术有所帮助。