Python自动采集流程快速实现,轻松高效!

优采云 发布时间: 2023-03-29 16:20Python自动化自动采集,让数据采集变得更加高效、简单。本文将介绍Python自动化自动采集的流程,帮助大家了解如何快速完成数据采集任务。

一、确定数据来源

在进行数据采集前,首先需要确定数据来源。可以通过搜索引擎、社交媒体、网站抓取等多种方式获取数据源。在此过程中,需要注意选择合适的工具和技术,以及需要遵守相关法律法规。

二、编写爬虫程序

Python是一种常用的爬虫语言,可以使用各种框架和库来编写爬虫程序。其中,Scrapy是一个功能强大的爬虫框架,可以快速构建一个高效的爬虫系统。同时,BeautifulSoup、Selenium等库也有很好的支持。

三、分析页面结构

在进行数据采集前,需要对页面结构进行分析。通过浏览器开发者工具或者其他工具来查看HTML代码和CSS样式表。这样可以更好地了解页面结构,并且更好地定位所需的信息。

四、设置请求头

为了避免被目标网站发现并拒绝访问,我们需要设置请求头信息。请求头信息包括User-Agent、Referer等字段,可以通过浏览器开发者工具来查看。

五、模拟登录

在进行数据采集时,有些网站需要登录才能获取数据。这时需要模拟登录,可以使用Selenium等库来实现。

六、解析数据

在获取到网页源代码后,需要对其进行解析,以提取所需数据。这时可以使用正则表达式、XPath等方式进行解析。同时,BeautifulSoup也是一种很好的选择。

七、存储数据

在完成数据采集后,需要将所得数据存储下来。可以使用MySQL、MongoDB等数据库进行存储。也可以将数据保存为JSON、CSV等格式的文件。

八、定期更新

为了保证采集的数据及时准确,需要定期更新爬虫程序。同时也要关注目标网站的变化,及时调整程序以适应新的页面结构。

九、优化SEO

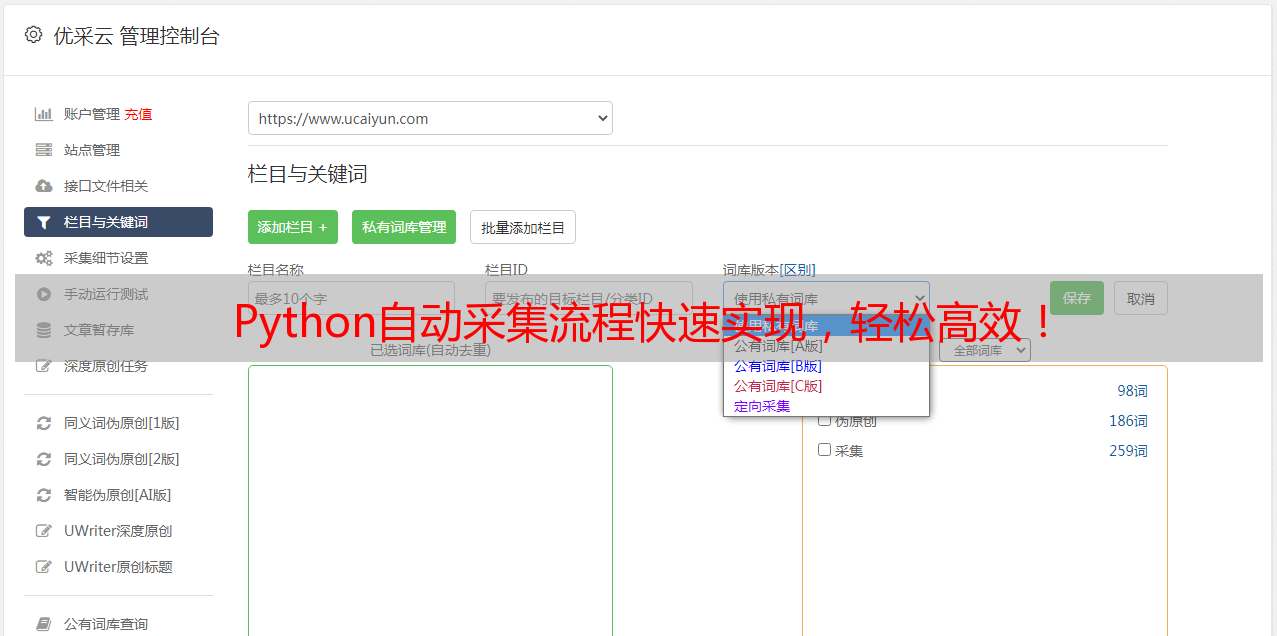

在完成数据采集后,还需要对其进行SEO优化。通过合理的关键词排名和内部链接等方式来提高网站的搜索引擎排名。同时,使用优采云等工具也可以帮助我们更好地进行SEO优化。

总结:通过Python自动化自动采集的流程,我们可以更加高效地完成数据采集任务。同时,在实际操作中还需要遵守相关法律法规,并注意保护用户隐私信息。如果您想了解更多相关信息,可以访问优采云网站www.ucaiyun.com。