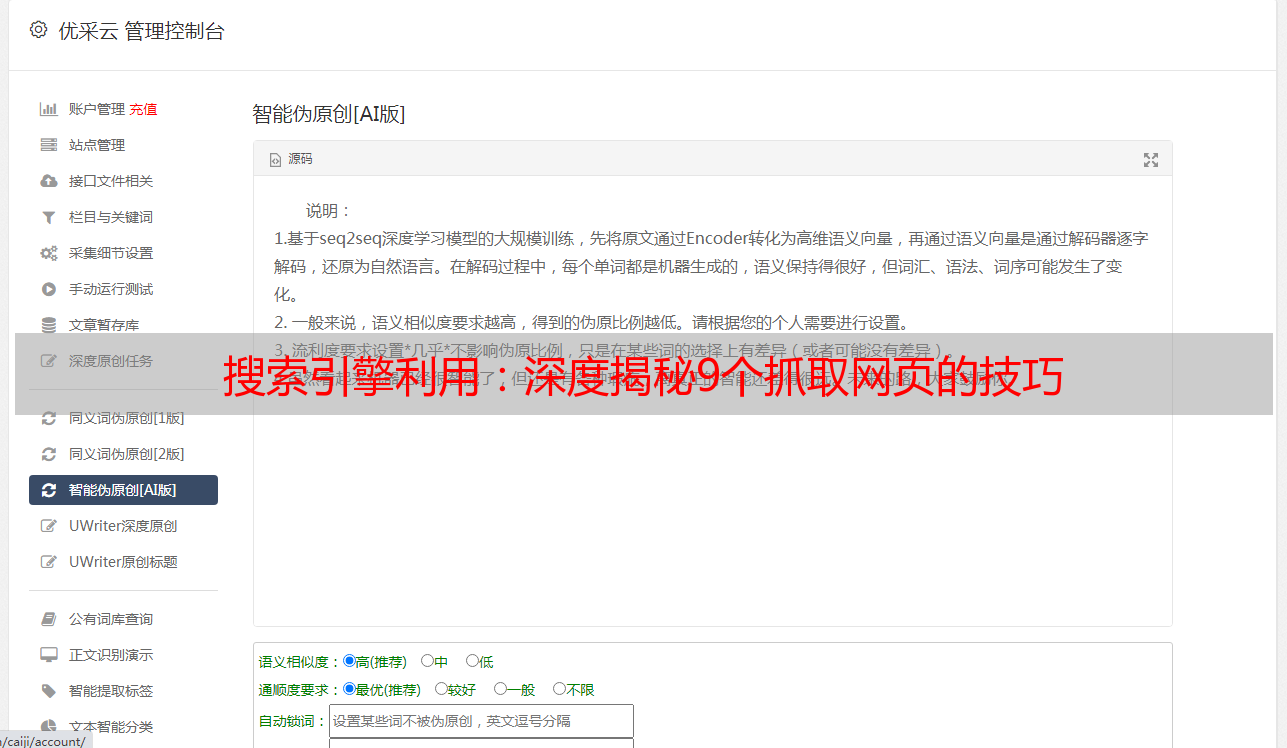

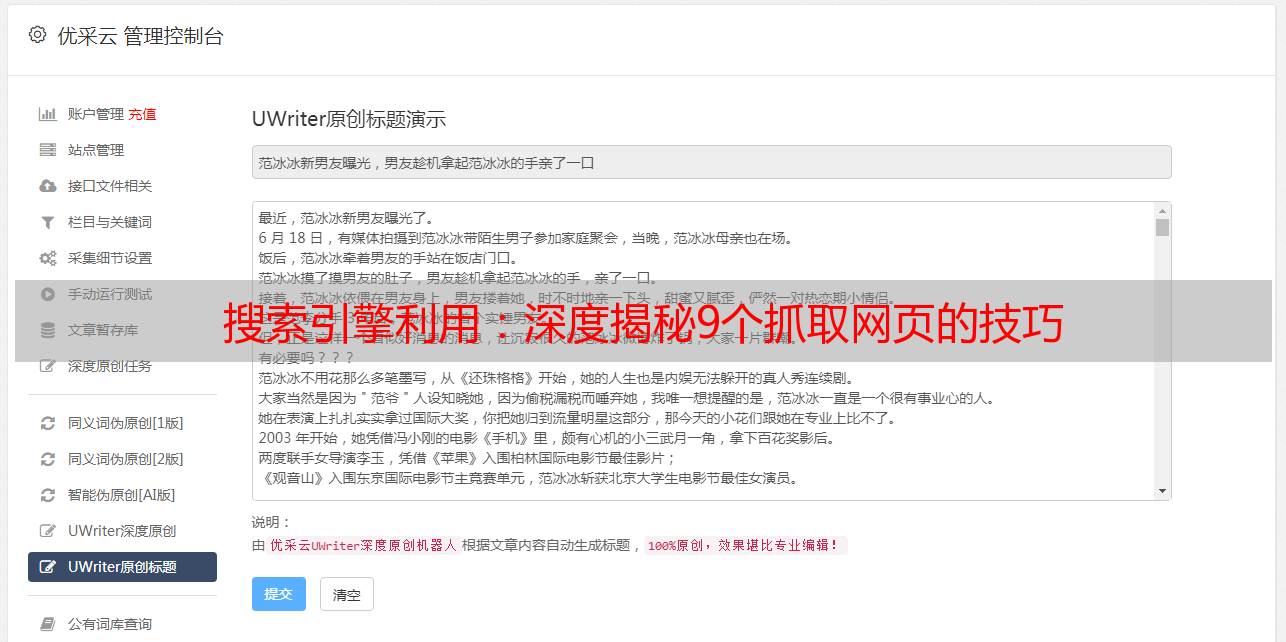

搜索引擎利用:深度揭秘9个抓取网页的技巧

优采云 发布时间: 2023-03-29 16:20搜索引擎是人们获取信息的重要渠道,而搜索引擎的核心就是抓取网页。那么搜索引擎是如何进行抓取的呢?本文将从9个方面对搜索引擎抓取机制进行深度揭秘,帮助读者更好地理解SEO优化。本文由优采云提供技术支持,更多SEO优化知识请访问www.ucaiyun.com。

一、HTTP协议

HTTP协议是搜索引擎抓取网页的基础,它定义了客户端和服务器之间传输数据的规范。当搜索引擎爬虫访问一个网页时,它会发送一个HTTP请求给服务器,服务器会根据请求返回一个HTTP响应。在HTTP请求和响应中包含了很多重要信息,如状态码、头部信息等。

二、DNS解析

DNS解析是将域名转换为IP地址的过程。当搜索引擎爬虫访问一个网站时,首先需要通过DNS解析获取该网站的IP地址。DNS解析过程包括递归查询和迭代查询两种方式。

三、Robots协议

Robots协议是一种标准协议,用于告诉搜索引擎爬虫哪些页面可以访问,哪些页面不可以访问。当搜索引擎爬虫访问一个网站时,它会首先查看该网站的Robots协议,根据协议来确定哪些页面可以抓取。

四、URL管理

URL管理是搜索引擎爬虫抓取网页的关键环节之一。搜索引擎爬虫会从一个*敏*感*词*URL开始,通过解析页面中的链接不断扩展URL队列。在URL管理过程中,需要考虑去重、优先级等问题。

五、内容提取

搜索引擎爬虫抓取网页后,需要对网页内容进行提取和分析。内容提取包括文本提取、图片提取、链接提取等。在内容提取过程中,需要考虑文本编码、HTML标签等问题。

六、数据存储

搜索引擎抓取的数据需要进行存储和索引。通常情况下,搜索引擎会使用倒排索引等技术来对数据进行高效存储和检索。

七、分布式抓取

由于互联网规模庞大,单机抓取效率低下,因此搜索引擎通常采用分布式抓取技术。分布式抓取能够充分利用多台机器的计算能力和带宽资源,提高抓取效率。

八、反爬机制

为了防止恶意爬虫对网站造成影响,搜索引擎通常会采取反爬机制。反爬机制包括IP封禁、验证码、User-Agent检测等。对于SEO优化人员来说,需要遵守搜索引擎的规则,合法抓取数据。

九、抓取频率

搜索引擎通常会根据网站的重要性和更新频率来确定抓取频率。对于新闻类网站等更新频率较高的网站,搜索引擎会进行较为频繁的抓取。而对于一些静态页面较多的网站,则不会进行过多的抓取。

总之,搜索引擎抓取机制是一个复杂的系统,需要考虑很多方面的问题。只有深入理解搜索引擎抓取机制,并遵守搜索引擎规则,才能够进行有效的SEO优化。如果您想要了解更多SEO优化知识,请访问优采云(www.ucaiyun.com)。