高效数据采集,从第二页开始抓取,这样做更省时!

优采云 发布时间: 2023-03-29 00:12随着互联网技术的不断发展,数据采集已经成为了各行业获取信息的重要手段之一。而对于数据采集来说,爬虫技术无疑是其中最为重要的一环。本文将详细介绍如何使用爬虫技术从第二页开始进行数据采集,并防止出现重复内容。

一、什么是数据采集爬虫?

数据采集爬虫,简称“爬虫”,是指一种自动化程序,可以模拟人类在互联网上浏览和获取信息的过程。通过网络访问和解析网页,将目标网站中的有用信息提取出来,并进行存储和分析。数据采集爬虫可以帮助我们快速、准确地获取所需的信息,并进行后续处理。

二、为什么需要从第二页开始抓取?

在进行数据采集时,我们通常都会从目标网站的首页开始抓取。但如果我们只是简单地从首页开始抓取,很容易会出现以下两个问题:

1.首页的信息可能并不完整。很多网站为了提高用户体验,在首页上只显示部分信息,更多内容需要用户点击“下一页”或“更多”等按钮才能查看。如果我们只是从首页开始抓取,就会漏掉很多有用的信息。

2.重复内容过多。如果我们每次都从首页开始抓取,那么每次获取的内容都会包含前面已经获取过的内容,这会导致重复内容过多,浪费时间和空间。

因此,为了避免上述问题,我们需要从第二页开始抓取。

三、如何防止出现重复内容?

在进行数据采集时,避免出现重复内容是非常重要的。否则不仅会浪费时间和空间,还可能对后续处理造成影响。以下是几种有效防止出现重复内容的方法:

1.使用去重算法。在存储数据之前,可以对数据进行去重处理。比较常用的去重算法有哈希算法、布隆过滤器等。

2.设置唯一索引。在存储数据时,可以设置唯一索引来避免插入重复数据。如果插入了重复数据,则会报错并停止插入。

3.定期清除历史数据。如果我们只需要获取最新的数据,并不需要保留历史数据,那么可以定期清除历史数据来避免出现重复内容。

四、如何编写爬虫程序?

编写爬虫程序需要具备一定的编程基础和网络知识。以下是编写爬虫程序的一般步骤:

1.分析目标网站的结构。了解目标网站的页面结构、数据存储方式、反爬虫机制等信息,为后续编写爬虫程序做好准备。

2.编写爬虫程序。使用编程语言(如Python、Java等)编写爬虫程序,实现对目标网站的访问、解析和数据提取。

3.存储数据。将获取到的数据存储到数据库或文件中,便于后续处理和分析。

4.防止被反爬虫。在编写爬虫程序时,需要注意目标网站是否设置了反爬虫机制,并采取相应措施来避免被封禁或被禁止访问。

五、优采云如何帮助数据采集?

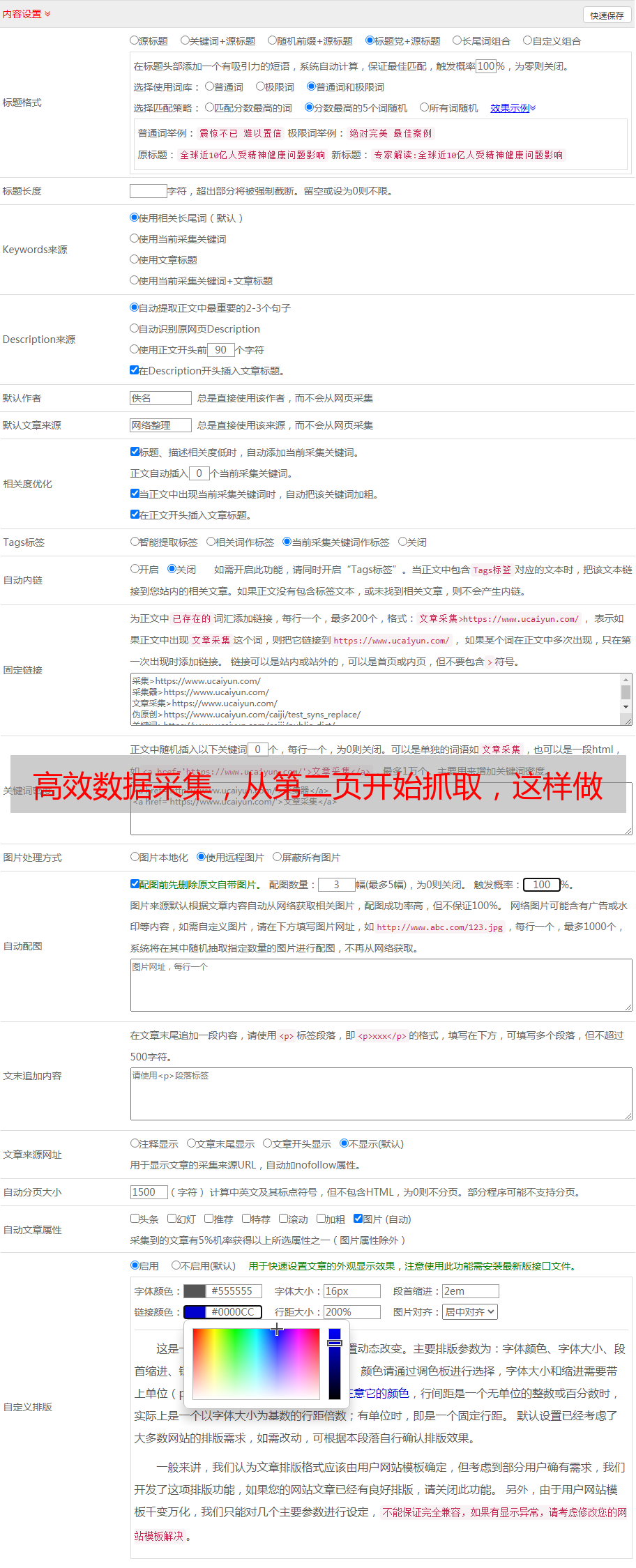

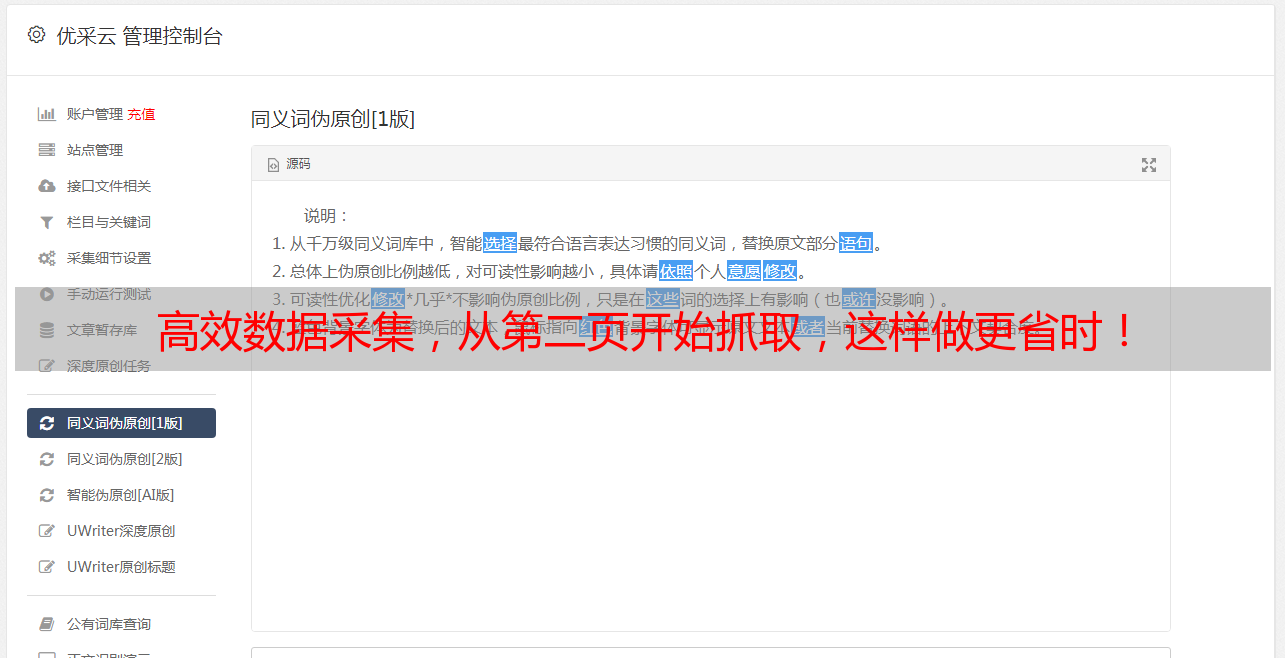

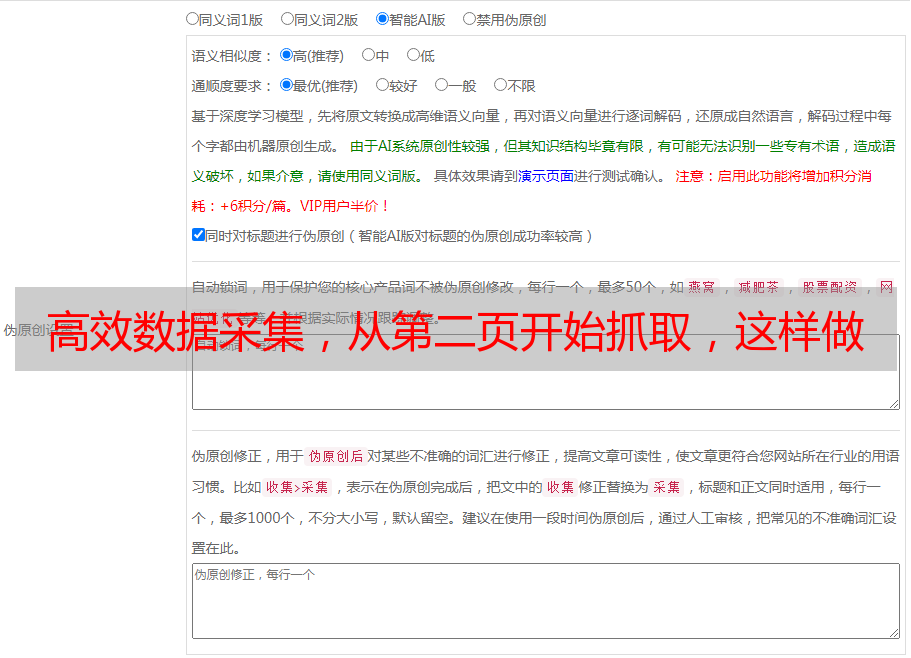

优采云是一款专业的数据采集工具,可以帮助用户快速、高效地获取所需的信息。其主要功能包括:

1.支持多种数据源。优采云支持多种数据源,包括HTML、XML、JSON等格式的数据源,可以满足用户不同的需求。

2.支持自定义抓取规则。用户可以根据自己的需求自定义抓取规则,提高数据采集的准确性和效率。

3.支持数据清洗和去重。优采云可以对获取到的数据进行清洗和去重,避免出现重复内容。

4.支持SEO优化。优采云可以根据用户需求对数据进行SEO优化,提高网站的搜索排名和曝光度。

总之,数据采集爬虫是一项非常重要的技术,在各行各业都有广泛应用。在进行数据采集时,我们需要从第二页开始抓取,并注意防止出现重复内容。同时,使用优秀的数据采集工具如优采云,可以提高数据采集的效率和准确性,为我们带来更多的商业价值。