在线抓取技术轻松获取所需信息!

优采云 发布时间: 2023-03-28 15:17随着互联网的迅猛发展,信息爆炸式增长,人们需要更高效的方式来获取所需信息。在线抓取技术应运而生,成为一种快速、有效地获取网络信息的方法。本文将从多个方面介绍在线抓取技术,帮助读者了解如何利用这一技术获取所需信息。

一、什么是在线抓取?

在线抓取(Web Scraping),又称数据爬虫(Data Crawling),是一种自动化提取互联网数据的技术。它通过模拟人类浏览器行为,自动访问网站并解析网页内容,将所需数据提取出来并保存到本地文件或数据库中。

二、在线抓取的应用场景

在线抓取技术可以应用于各个领域,例如:

1.市场调研:通过抓取竞争对手的产品价格、销售情况等信息,了解市场趋势;

2.舆情监测:通过抓取社交媒体、新闻网站等平台发布的内容,了解公众对某个事件或话题的态度和反应;

3.数据分析:通过抓取大量数据并进行分析,得出有价值的结论;

4.搜索引擎优化(SEO):通过抓取搜索引擎的搜索结果和排名,了解竞争对手的关键词策略,从而制定更好的SEO策略。

三、在线抓取的技术实现

在线抓取的实现需要掌握以下技术:

1. HTTP协议:了解HTTP请求和响应的基本原理;

2. HTML/CSS/JavaScript:了解网页结构和样式,以及网页中常用的JavaScript库和框架;

3.解析库:选择适合自己语言的HTML解析库,如Python中的Beautiful Soup、Java中的Jsoup等;

4.数据存储:选择适合自己需求的数据库或文件格式,如MySQL、MongoDB、CSV等。

四、在线抓取的注意事项

1.遵守法律法规:在进行在线抓取时,需要遵守相关法律法规,尤其是隐私保护和知识产权方面;

2.尊重网站规则:不得通过在线抓取侵犯网站规则,如禁止爬虫协议(robots.txt)等;

3.控制访问频率:要避免对目标网站造成过大压力,控制访问频率和并发数;

4.数据清洗和去重:需要对抓取到的数据进行清洗和去重,保证数据的准确性和完整性。

五、在线抓取工具推荐

1. Scrapy:Python开发的高级网络爬虫框架,可快速构建抓取规则并进行数据存储和处理;

2. Selenium:基于浏览器自动化的工具,可以模拟人类浏览器行为,解决JavaScript渲染问题;

3. Octoparse:提供可视化操作界面,支持自定义抓取规则和数据导出方式;

4. ParseHub:提供强大的抓取和数据处理功能,并支持API调用和自动化任务。

六、结语

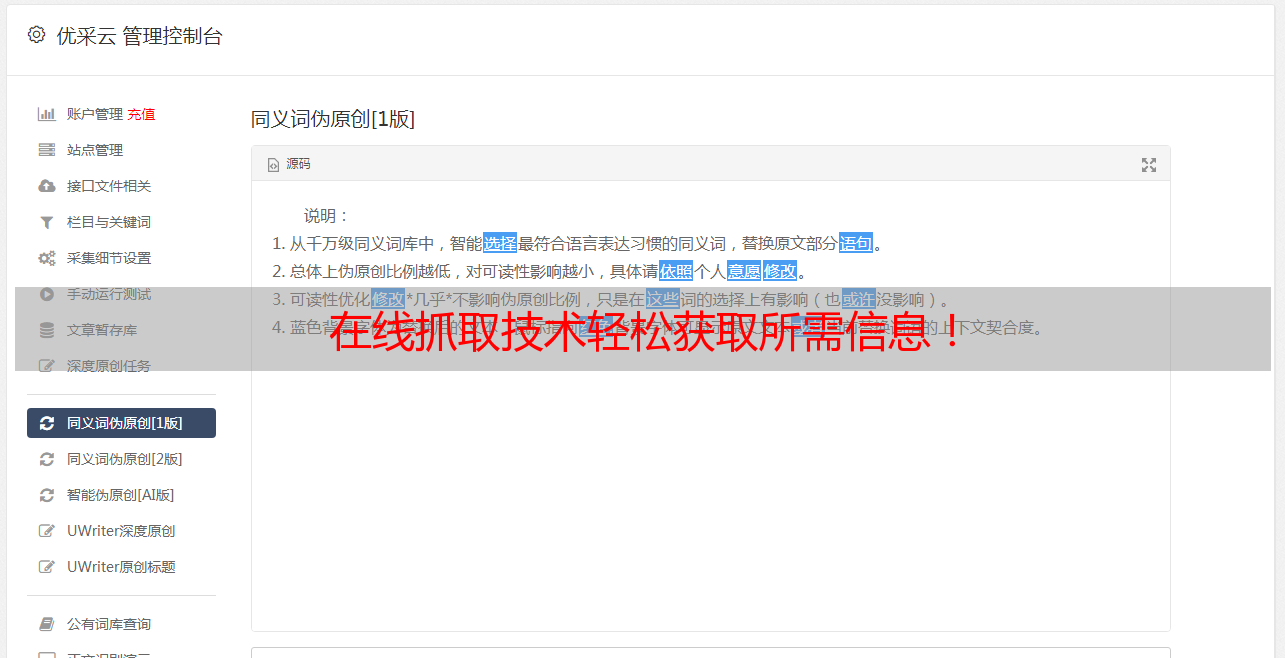

通过在线抓取技术,我们可以快速获取所需信息,提高工作效率,实现更多可能。但在使用该技术时需要注意法律法规和伦理道德等方面的问题。优采云(www.ucaiyun.com)是一家专业的数据采集与处理平台,在线抓取方面有着丰富的经验和技术积累。同时也提供SEO优化服务,帮助企业更好地利用在线抓取技术实现营销目标。