PHP网页爬虫实战:简单易学,快速入门!

优采云 发布时间: 2023-03-26 08:14随着互联网的不断发展,我们每天都会接触到各种各样的数据,而如何快速、高效地获取这些数据并进行分析处理,成为了众多企业和个人所关注的问题。而网页爬虫作为一种获取互联网数据的重要方式,也逐渐受到了越来越多人的关注和使用。本文将从零开始,详细介绍如何使用PHP语言构建一个简单但实用的网页爬虫。

1.了解网页爬虫的基本概念

在开始构建网页爬虫之前,我们需要先了解一些基本概念。简单来说,网页爬虫就是一种自动化程序,它可以模拟人类在浏览器中访问网站的行为,获取指定页面中的数据,并进行处理和存储。而这个过程中所涉及到的一些术语和技术点,包括但不限于:

- User-Agent:模拟浏览器访问时需要发送给服务器的请求头部信息;

- Cookie:记录用户在浏览器中对某个站点登录状态等信息;

- HTTP协议:网页请求和响应时所使用的通信协议;

- DOM解析:将HTML页面转化为树形结构,以便进行数据提取和处理;

-正则表达式:用于匹配和提取HTML中的数据。

2.安装PHP环境并安装必要的扩展

在开始编写爬虫代码之前,我们需要先安装PHP环境,并安装一些必要的扩展库,包括但不限于:

- curl扩展:用于发送HTTP请求并获取响应;

- simplexml扩展:用于解析XML格式的数据;

- dom扩展:用于解析HTML页面;

- mbstring扩展:用于处理Unicode字符集。

3.编写基本的爬虫框架

在了解了基本概念和安装必要的扩展之后,我们就可以开始编写基本的爬虫框架了。具体来说,我们需要完成以下几个步骤:

-设置User-Agent和Cookie等请求头部信息;

-发送HTTP请求并获取响应;

-解析HTML页面并提取所需数据;

-存储数据。

下面是一个简单的示例代码:

php

<?php

//设置请求头部信息

$opts = array(

'http'=> array(

'method'=>"GET",

'header'=>"User-Agent: Mozilla/5.0(Windows NT 6.1; WOW64; rv:54.0) Gecko/20100101 Firefox/54.0\r\n".

"Cookie: foo=bar\r\n"

)

);

$context = stream_context_create($opts);

//发送HTTP请求并获取响应

$html = file_get_contents('http://www.example.com', false,$context);

//解析HTML页面并提取所需数据

$dom = new DOMDocument();

@$dom->loadHTML(mb_convert_encoding($html,'HTML-ENTITIES','UTF-8'));

$xpath = new DOMXPath($dom);

$elements =$xpath->query("//div[@class='content']");

//存储数据

foreach ($elements as $element){

echo $element->nodeValue;

}

?>

4.处理反爬虫机制

在实际使用爬虫时,我们可能会遇到一些反爬虫机制,比如IP封锁、验证码等。针对这些问题,我们需要采取相应的措施,比如:

-使用代理IP:通过使用代理IP来隐藏真实IP地址,从而避免被封锁;

-处理验证码:通过OCR技术或者手动输入等方式处理验证码;

-限制爬虫频率:通过设置访问间隔或者随机访问间隔等方式限制爬虫频率。

5.爬取动态网页数据

除了静态页面之外,我们还可能需要爬取一些动态网页数据,比如使用Ajax技术进行异步加载的数据。此时我们就需要使用一些特殊的技术手段来模拟浏览器中的行为,比如:

-使用PhantomJS:PhantomJS是一个基于WebKit的无界面浏览器,可以模拟浏览器中的行为,并获取JavaScript生成的HTML代码;

-使用Selenium:Selenium是一个自动化测试工具,可以模拟用户在浏览器中的行为,并获取JavaScript生成的HTML代码。

6.存储和处理数据

在爬取到数据之后,我们需要将其进行存储和处理。常见的存储方式包括:

-文件存储:将数据以纯文本或者XML/JSON等格式保存到文件中;

-数据库存储:将数据保存到MySQL、MongoDB等数据库中;

-内存存储:将数据保存到Redis等内存数据库中。

而对于数据处理方面,我们可以使用各种各样的技术手段来进行数据清洗、分析和可视化展示,比如:

-使用正则表达式进行数据清洗;

-使用Pandas和Matplotlib等库进行数据分析和可视化展示;

-使用Elasticsearch和Kibana等工具进行日志分析和可视化展示。

7.遵循法律和道德原则

在使用网页爬虫时,我们需要遵循相关法律法规和道德原则。比如,在爬取他人网站数据时,需要遵守robots协议;在爬取个人隐私数据时,需要获得相应授权;在爬取商业竞争对手数据时,需要遵守公平竞争原则,不得进行不正当竞争行为。

8.优化爬虫效率和稳定性

在实际使用爬虫时,我们还需要考虑如何优化爬虫效率和稳定性。常见的优化方式包括:

-使用多线程或者异步IO等技术提高并发能力;

-采用分布式架构提高可扩展性;

-对于*敏*感*词*数据处理任务,可以使用Hadoop、Spark等分布式计算框架。

9.总结

网页爬虫作为一种获取互联网数据的重要方式,在各个领域都有着广泛的应用。通过本文的介绍,相信大家已经了解了网页爬虫的基本概念、编写方法和注意事项。在使用爬虫时,我们需要遵守相关法律法规和道德原则,同时也需要不断优化其效率和稳定性,以便更好地为企业和个人服务。

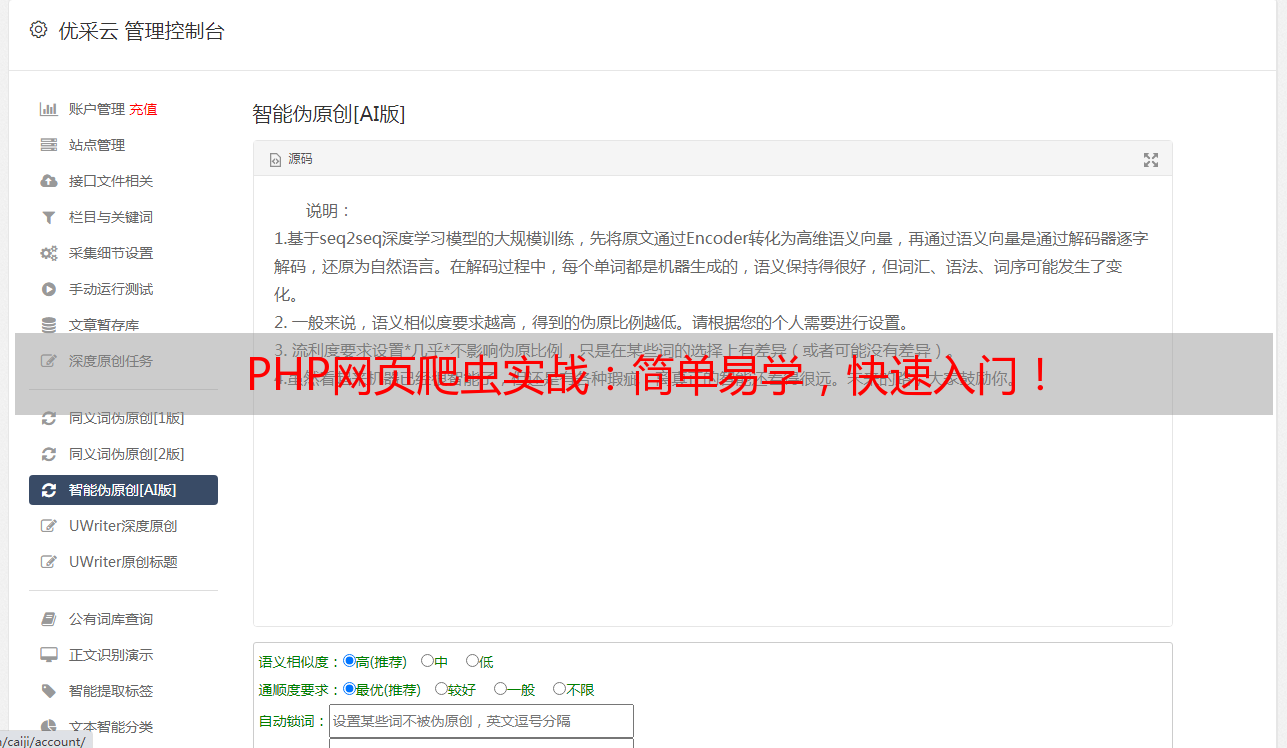

本文由优采云提供技术支持,优采云是一家专业的SEO优化平台,致力于为广大用户提供高效、便捷、智能的SEO优化服务。欢迎访问www.ucaiyun.com了解更多信息。