网络爬虫工具能否适用于所有网站数据收集?

优采云 发布时间: 2023-03-24 22:15在互联网时代,数据被誉为新的石油,而网络爬虫则是获取数据的重要手段之一。然而,所有网站都可以使用网络爬虫工具收集数据吗?这是一个需要探讨的话题。

1.爬虫协议

首先要明确的是,网站拥有自己的服务器和资源,如果随意使用网络爬虫工具进行数据采集,可能会对网站造成不必要的负担和损害。因此,为了规范爬虫行为,互联网上出现了“爬虫协议”。常见的爬虫协议有Robots协议和Sitemap协议。

Robots协议是指在网站根目录下放置一个名为robots.txt的文件,告诉搜索引擎和其他爬虫哪些页面可以访问和抓取,哪些页面禁止访问和抓取。如果一个网站没有提供Robots协议或者提供了但没有遵守,那么使用网络爬虫工具进行数据采集就是*敏*感*词*。

2.反爬机制

即使一个网站允许使用网络爬虫工具进行数据采集,也可能会设置反爬机制。常见的反爬机制有IP封禁、验证码、User-Agent检测等。如果一个网站设置了反爬机制,那么就需要使用相应的技术手段来规避。

3.法律风险

在进行数据采集时,还需要注意法律风险。一些网站可能会对数据的使用和传播进行限制,如果随意使用可能会触犯法律。因此,在使用网络爬虫工具进行数据采集时,需要遵守相关法律和规定。

4.数据质量

除了合法性问题,还需要考虑数据质量问题。网络爬虫工具可以采集到大量数据,但并不是所有数据都有用。因此,在进行数据采集时需要明确自己的需求,并通过筛选、清洗等方式提高数据质量。

5.安全问题

最后一个要考虑的问题是安全问题。网络爬虫工具可以获取到网站的敏感信息,如果不加以保护就可能造成安全隐患。因此,在进行数据采集时需要注意安全问题,并采取相应的措施进行保护。

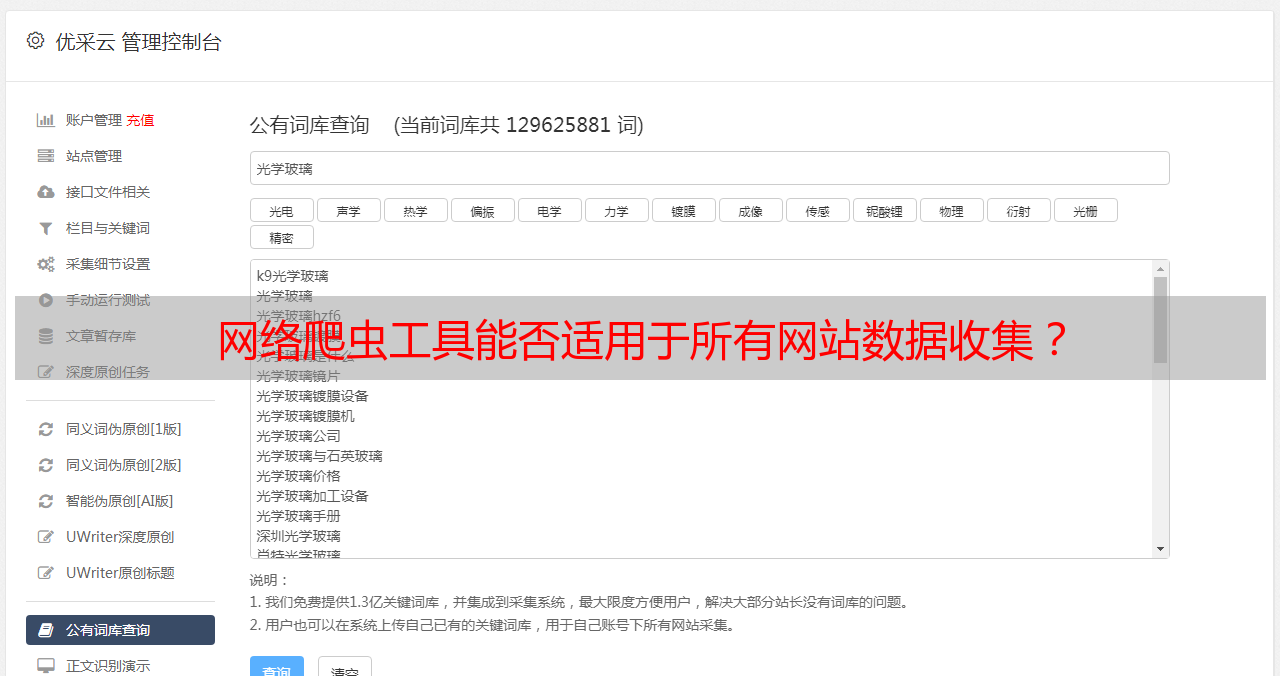

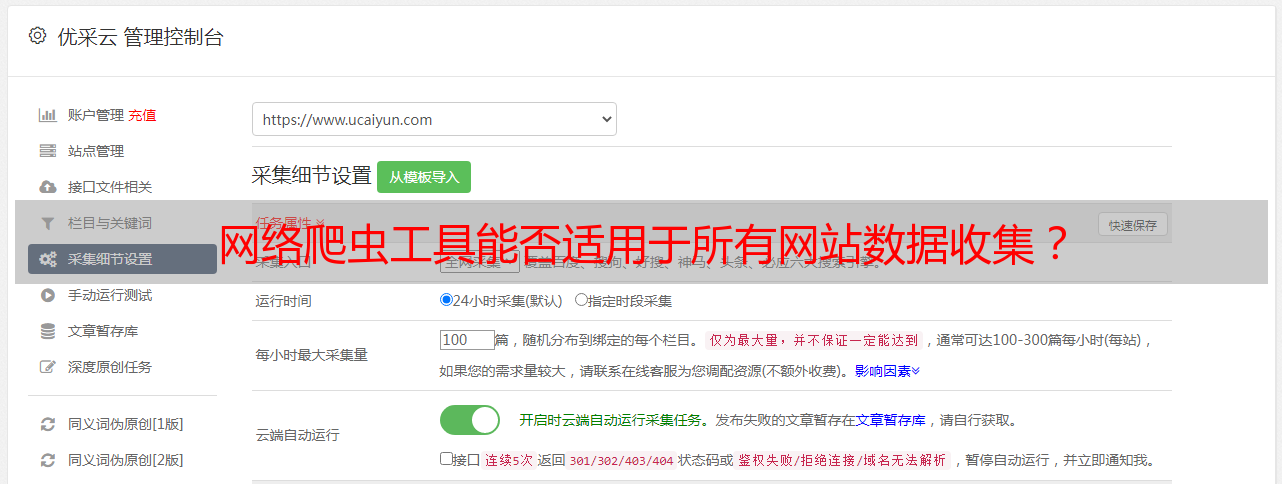

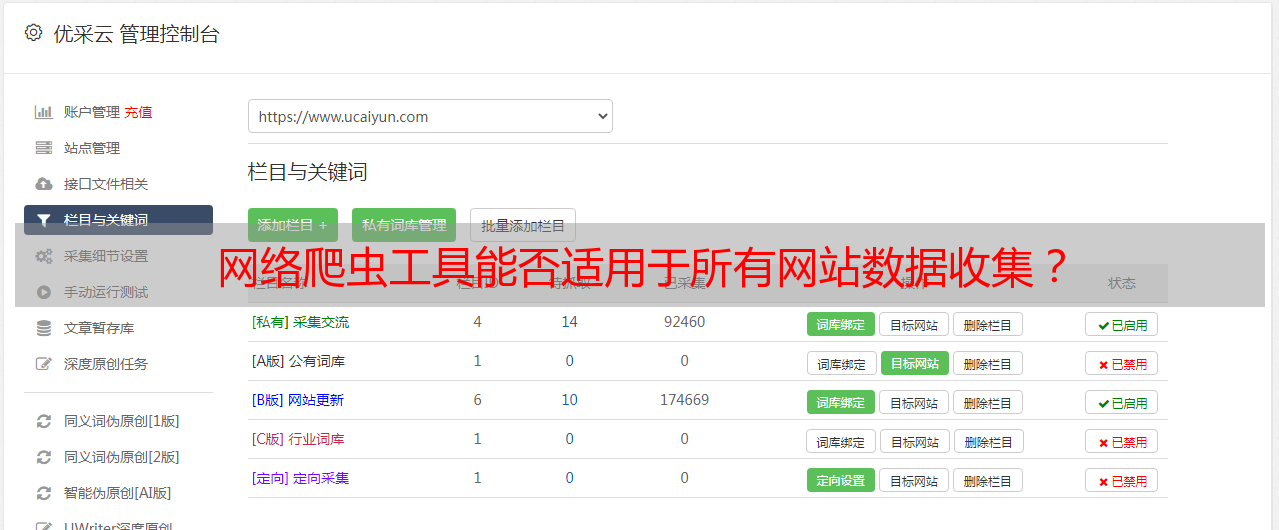

综上所述,所有网站并不能都使用网络爬虫工具收集数据,需要遵守Robots协议和相关法律规定,并注意反爬机制、数据质量和安全问题。如果您需要进行网络爬虫相关操作,可以选择优采云提供的爬虫服务,通过SEO优化提高网站的流量和曝光度。更多详情请访问www.ucaiyun.com。